服务器网站源码在哪wordpress清除插件

1.设计要求

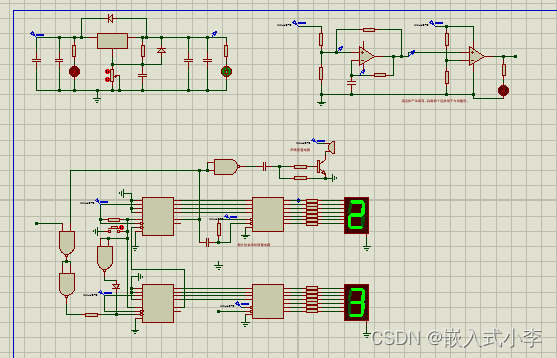

设计、制作一个篮球赛24秒违例倒计时报警器。要求:

(1)具有倒计时功能。可完整实现从“24”秒开始依序倒计时并显示倒计时过程,显示时间间隔为1秒。

(2)具有消隐功能。当“24”秒倒计时至终点的瞬间,显示器字幕立刻自行消隐,消隐时间必须大于5秒。

(3)具有复位功能。无论显示器是显示倒计时的时间或消隐状态下,只要按下复位键,显示器立刻晃示“24”秒接着开始倒计时。

(4)具有准时报警功能。当发生“24”秒违例时,在倒计时“24”秒结束,数码管消隐的瞬间并且立刻发出报警声“嘀-----”,且该声音时间不能太长也不能太短,只能是0.5秒左右,在3米外可听到清晰报警声。

主要元器件:LM317(调9V),LM7809,NPN三极管9013,CD4011,LM358,CD4511,数码管,CD40192,继电器,IN4148,电阻, 电容。

2.电路设计

3.元件介绍

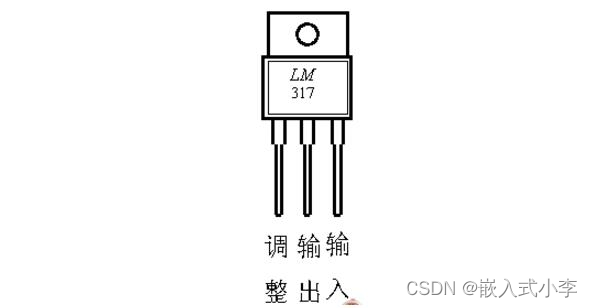

LM317是一种线性稳压器,它是一款集成电路芯片,由德州仪器(Texas Instruments)公司推出。LM317的主要功能是提供稳定的输出电压,并在输入电压变化时自动调节电压输出。它广泛应用于各种电子设备中,如电源电路、电子仪器、电动车充电器等。

LM317的主要特点和工作原理如下:

1. 调节范围:LM317能够提供的输出电压范围很广,通常从1.25V到37V不等。通过调整引脚的电阻分压,可以轻松地设置所需的输出电压。

2. 调节稳定性:LM317具有良好的稳定性,即使在输入电压变化或负载变化时,也可以保持稳定的输出电压。这使得它成为一种可靠的电压稳压器。

3. 过热保护:LM317还内置了过热保护功能,当芯片温度超过安全范围时,它会自动停止输出,以保护芯片免受损坏。

4. 电流调节:LM317还可以通过外部电流限制电阻来限制输出电流。这使得它适用于不同负载要求的应用。

LM317的工作原理是基于稳压器的串联调整方式。在输入电压稳定时,通过调整引脚上的电阻值,它会将稳定的输出电压提供给负载。当输入电压或负载发生变化时,内部电路会自动调整,以保持输出电压稳定。

。

。

LM7809是一种线性稳压器,它是一款集成电路芯片,由德州仪器(Texas Instruments)公司推出。LM7809的主要功能是将输入电压稳定地调节为+9V的输出电压,并在输入电压或负载变化时自动调整电压输出。

LM7809是一种常用的正稳压器,它属于LM78xx系列稳压器中的一员。LM78xx系列稳压器包括多个型号,分别可以提供不同的输出电压。其中,LM7809用于提供+9V的输出电压。

LM7809的主要特点和工作原理如下:

1. 输出电压:LM7809能够稳定地提供+9V的输出电压。这种输出电压非常常见,广泛用于各种电子设备中。

2. 输入电压范围:LM7809的工作电压范围通常为10V至35V。输入电压应保持在这个范围内,以确保稳定的输出电压。

3. 稳定性:LM7809具有良好的稳定性,即使在输入电压变化或负载变化时,也可以保持稳定的输出电压。这使得它成为一种可靠的电压稳压器。

4. 过热保护:LM7809还内置了过热保护功能,当芯片温度超过安全范围时,它会自动停止输出,以保护芯片免受损坏。

5. 限流功能:LM7809还具有内置的限流功能,它可以限制输出电流的最大值,以保护电路和负载。

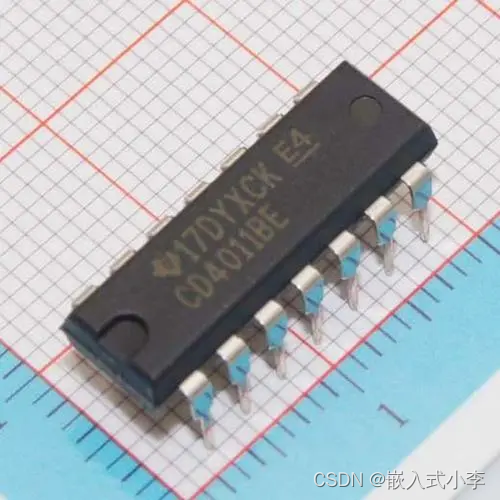

CD4011是一种四2输入与非门(NAND门)集成电路芯片,由德州仪器(Texas Instruments)公司推出。它是在数字逻辑电路中常用的基础组件之一。

CD4011芯片具有四个独立的2输入与非门,每个门具有两个输入端(A和B)和一个输出端(Y)。它的主要功能是将两个输入信号进行逻辑与非运算,然后将结果输出。

CD4011的工作原理如下:当输入门的A和B都是高电平(逻辑1)时,输出为低电平(逻辑0)。只要有一个输入是低电平,输出就为高电平。这种逻辑运算的功能使得它可以实现各种数字逻辑功能,如逻辑门、组合逻辑电路和时序逻辑电路等。

CD4011的优点包括低功耗、高噪声抑制、宽工作电压范围和稳定可靠的性能。它广泛应用于数字电路设计、计算机系统、通信设备、工业控制等领域。在数字电路设计中,CD4011可以用于构建逻辑门、多路选择器、触发器等各种功能模块。

需要注意的是,CD4011是一种非源极门(unbuffered gate),输出电流能力有限。因此,在实际应用中,如果需要驱动大负载或工作频率较高的电路,可能需要使用缓冲器或其他适当的控制器。

4.源文件

篮球赛24秒违例倒计时报警器的proteus仿真资源-CSDN文库![]() https://download.csdn.net/download/guangali/88819574?spm=1001.2014.3001.5501

https://download.csdn.net/download/guangali/88819574?spm=1001.2014.3001.5501