网站备案上传照片几寸代理自贸区注册公司

简介

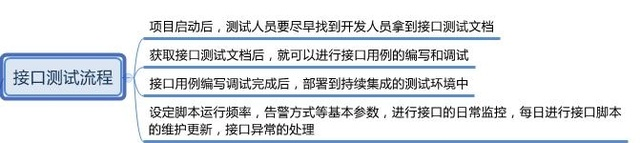

上篇我们已经介绍了什么是接口测试和接口测试的意义。在开始接口测试之前,我们来想一下,如何进行接口测试的准备工作。或者说,接口测试的流程是什么?有些人就很好奇,接口测试要流程干嘛?不就是拿着接口文档直接利用接口

测试工具测试嘛。其实,如果只是三五个接口,你可以这么做一个临时的接口测试。但是,如果是上百个接口,或者,你们公司的这个项目,第一次做接口测试,那么,我们还是很有必要严格遵守接口测试的流程。

接口测试的流程

接口测试也是属于功能测试,所以跟我们以往的功能测试流程并没有太大区别,测试流程依旧是:1.测试接口文档(需求文档) 2.根据接口文档编写测试用例(用例编写完全可以按照以往规则来编写,例如等价类划分,边界值等设计方法) 3. 执行测试,查看不同的参数请求,接口的返回的数据是否达到预期。

接口测试和功能测试一样,流程也大致遵守V模型,请看下图

一般来说,接口测试左边的每个阶段,每个公司可能都侧重点不同,例如有些公司就没有需求讨论和需求评审这个阶段。不管如何,用例设计,这个是少不了,而且是重点,要花时间的阶段。只有覆盖全面的接口测试用例,才能有比较好的测试接口覆盖率,才会找出更多的接口的Bug,后期接口才能越稳定。

为什么要写用例

功能测试用例,大家都写过。接口测试用例,很多人没有写过。在后边后又专门一章关于接口用例和接口报告的模板。在写之前,我们来讨论下,为什么要写接口用例。

- 理清思路,避免漏测和重复测

- 提高测试效率

- 跟进测试进度

- 告诉领导做过

- 跟进重复性工作

- 更好的记录问题,发现问题,复现问题

- 同时这也是是接口测试流程中的一个产物(测试用例)

上面七点,结合自己测试实际经验,应该来说是很好理解和认同的。有用例,自己做到心中有数,不要一个测试点重复测好多次,就有思路,避免漏掉测试点。跟着用例测试,避免随机测试那种没有目的性的测试,提高测试效率。有用

例,上级问你完成的进度,你好用数据回答。有用例,用来标记你执行的结果,证明你做过测试。避免将来发生问题,人家说你没有测试,有数据和证据说话。有用例,测出问题你可以根据用例将问题轻而易举的浮现出来,不至于等你反馈或

者复现的问题时,你忘记是如何操作才回出现问题。接口测试也需要重复跑,跑几轮,或者用自动化天天跑。这样的重复性工作,用例可以保证每次重复做的是一样的情况。

接口主要设计用例点

主要从四个方面来设计接口用例:功能,逻辑业务,异常,安全

功能:

1)功能是否正常;

2)功能是否按照接口文档实现

举例:比如博客园添加随笔,需要登录才能添加。也就是业务要求不支持游客添加随笔功能,如果设计一个没有登录的用户,然后去测试添加随笔接口,结果接口能添加到随笔,说明功能不正常,不符合需求和接口文档描述。

逻辑业务:是否依赖业务;

举例:该接口调用之前,需要调用登录接口,如果不登录也能请求数据,不符合业务规则。

异常:参数异常和数据异常

参数异常:关键字参数,参数为空,多,少参数,错误参数

数据异常:关键字数据,数据为空,长度不一致,错误数据

举例:不管数据异常还是参数异常,测试点差不多,一个参数有key和value,key表示参数,value表示数据。第一,看看参数和数据能不能支持关键字,例如Java中的保留关键字等等。第二个就是参数和数据都为空,看看是否做了判断。第三个,参数多和少,例如有两个参数的接口,你需要设计一个三个参数的用例,一个只有一个参数的用例。数据那边长度不一致,例如设计很长的字符串是否支持,因为数据库创建表过程都设置好了每个字段的长度。输入错误的参数和数据,例如故意输出单词等等。

安全测试用例设计:

1)cookie:有cookie才能获取数据,如果不带cookie还有信息返回,说明有问题

2)header:正常接口带header信息,删除header看是否能够返回数据。

3)唯一识别码:app手机识别码,一般是唯一的。

安全测试主要从上面三点检查。第三个是唯一识别码,主要是指app上手机的识别码,一般很少用到,除非很严格的接口测试,例如银行app登录,需要指纹,而指纹来源手机,一般有一个手机识别码判断过程。

Python接口自动化测试零基础入门到精通(2023最新版)