php网站建设参考文献百度点击优化

COW我第一次看见还以为是奶牛

很奇怪是个啥

后来了解到是clone on write 缩写的,大乌龙啊

这个有两种enum,一种是borrow,一种是own

rust中,数据读写经常涉及到所有权

这个borrow,很显然,就是不可变借用了

own就是可以写入修改了

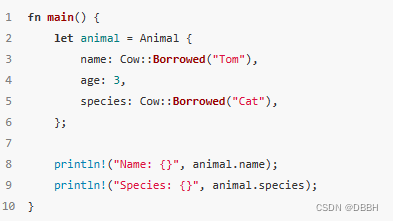

上面这个是读的例子,看起来蛮简单的

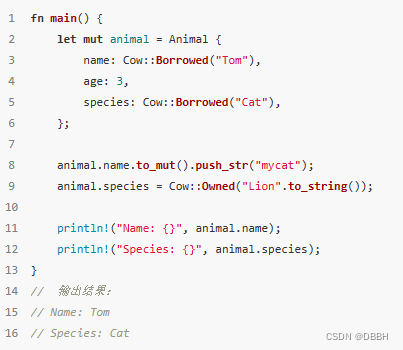

这个是写的例子,感觉,就只是少写了个clone?

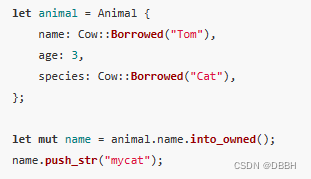

下面这个例子就看起来显得高端一点了,从不可变变成可变的

然后还有一个from,根据描述这个自动根据数据返回给你borrow或者own的cow对象

这些例子都是这里的https://juejin.cn/post/7221969436885631033