杭州 建设网站首页专业建设方案

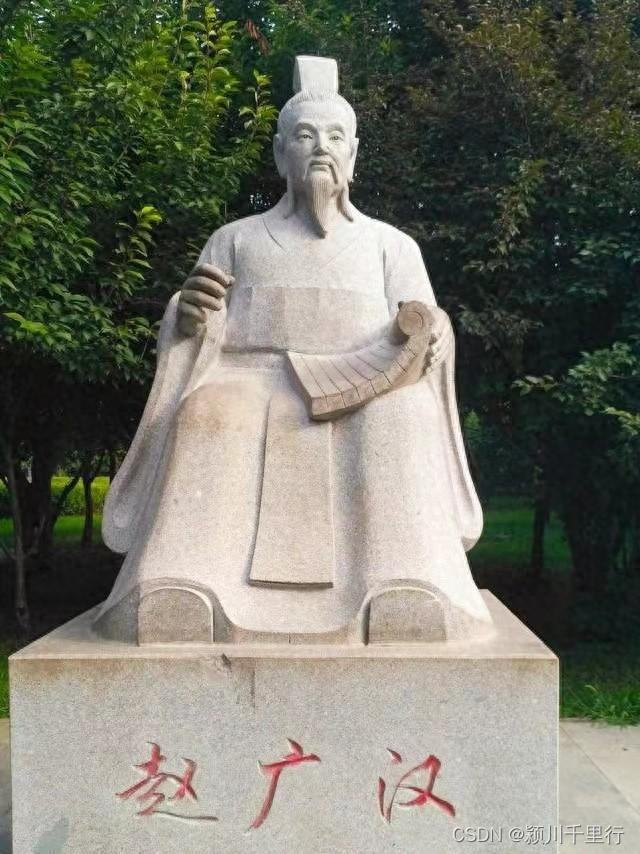

在颍川,他发明了举报箱,铁腕扫黑除恶。因为曾经在郡府所在地阳翟(禹州)当过县令,熟悉颍川社情民意,所以,任职郡守后雷厉风行,才不到一年,不但制服了骄横的豪门大族,也威慑了各地盗贼,创造了风清气正的社会环境。皇帝非常欣赏,提拔他担任首都长官(京兆尹),以加强京城治理。

在颍川,他发明了举报箱,铁腕扫黑除恶。因为曾经在郡府所在地阳翟(禹州)当过县令,熟悉颍川社情民意,所以,任职郡守后雷厉风行,才不到一年,不但制服了骄横的豪门大族,也威慑了各地盗贼,创造了风清气正的社会环境。皇帝非常欣赏,提拔他担任首都长官(京兆尹),以加强京城治理。

进京后不改初心,打击权贵,整顿治安,廉洁奉公,深受京城百姓爱戴。他干炼果断、无所畏惧,组织了一个年轻精干的办案队伍,无往而不胜。可是,也飘了!后来查到了丞相头上,亲自带队进入丞相府,强令丞相夫人跪下交代杀害仆人罪行,然而,属于捕风捉影。丞相绝地反击,查实他擅杀无辜,滥用权利等几项罪名。皇帝大怒,下令腰斩于市。

人生如棋需谨慎,执法严明莫枉法。