郑州建设工程交易中心网站手机建站平台微点

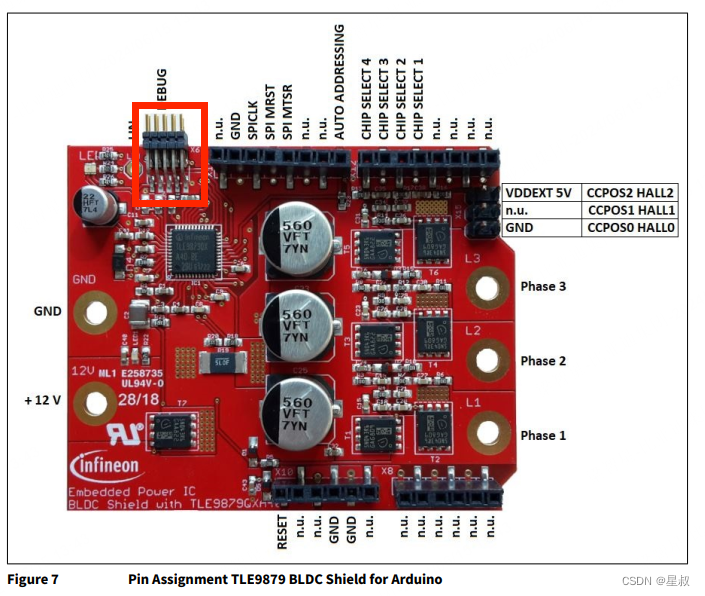

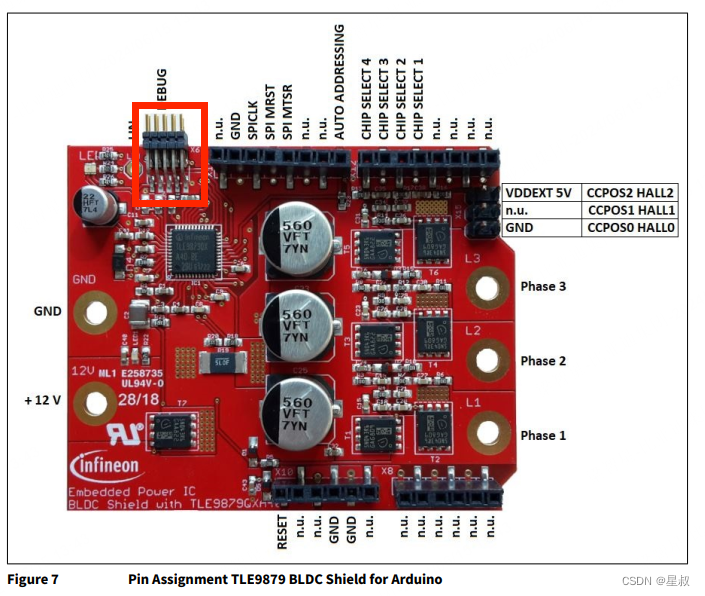

官方的Arduino评估板,如下图所示:

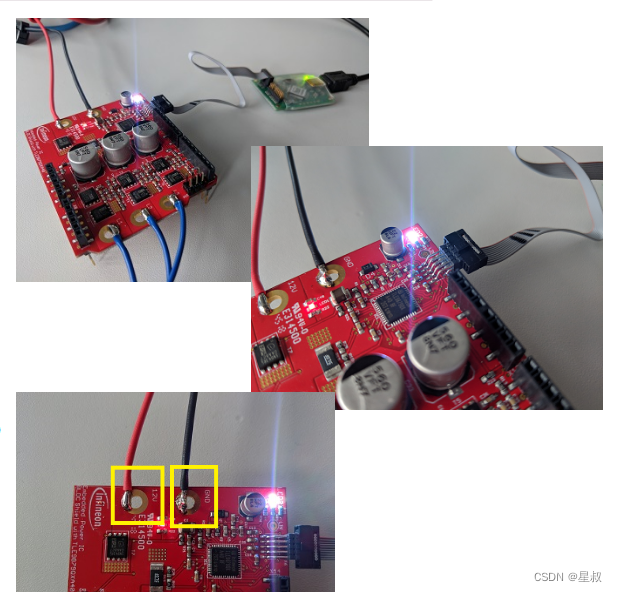

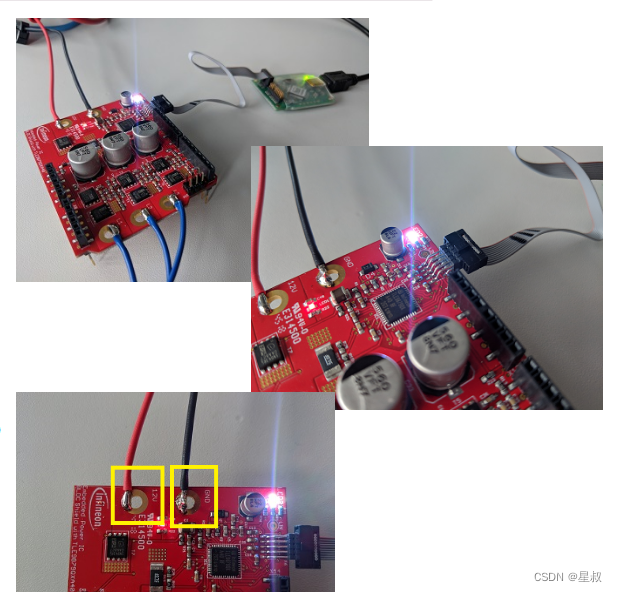

如果你有官方的调试器,应该不用关注本文章,如下图连接就是:

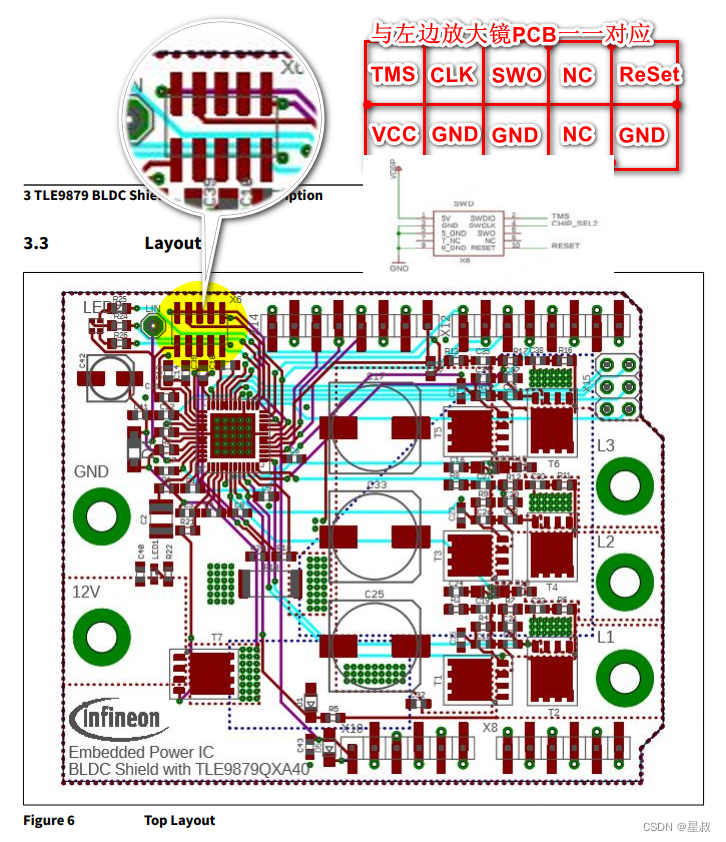

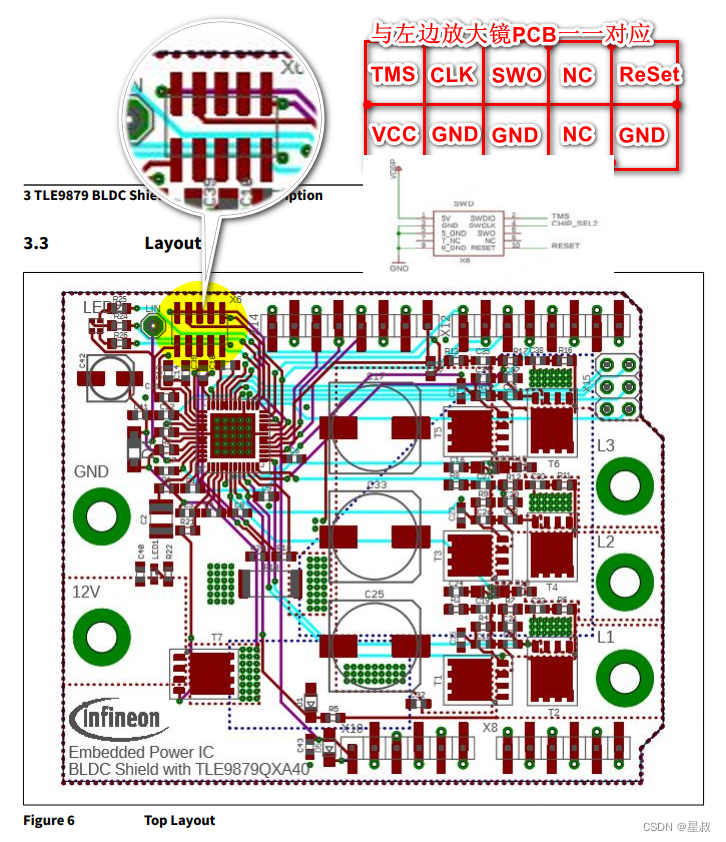

如果,您和博主一样需要自己飞线的话,如下图所示:PCB的名称在右边整理,SWD的刷写接口只需要5根线,VCC、GND、TMS、CLK 和 RESET。

官方的Arduino评估板,如下图所示:

如果你有官方的调试器,应该不用关注本文章,如下图连接就是:

如果,您和博主一样需要自己飞线的话,如下图所示:PCB的名称在右边整理,SWD的刷写接口只需要5根线,VCC、GND、TMS、CLK 和 RESET。