门户网站建设询价公告网站的标题与关键词

5大绝招揭秘:Cursor如何让RESTful API开发效率提升300%?

在当今快速迭代的软件开发世界中,高效构建RESTful API已成为开发者的必备技能。今天,我们将为大家介绍一款强大的AI辅助工具——Cursor,它能让您的API开发事半功倍。

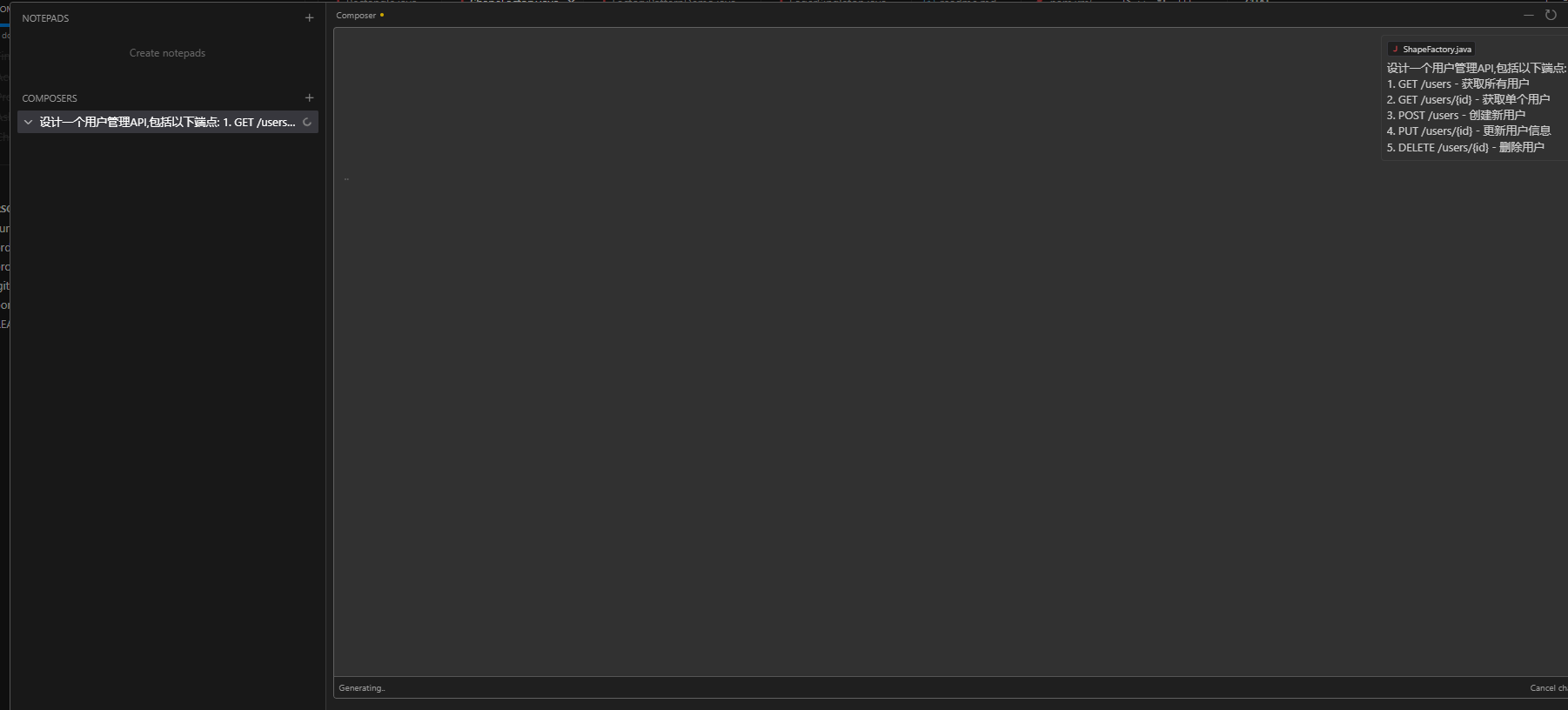

Cursor Composer:您的API设计助手

想象一下,您只需描述API需求,就能获得符合RESTful原则的架构设计。Cursor的Composer功能正是为此而生。

例如,我们需要一个用户管理API,包含常见的CRUD操作。只需在Cursor Composer中输入需求描述:

设计一个用户管理API,包括以下端点:

1. GET /users - 获取所有用户

2. GET /users/{id} - 获取单个用户

3. POST /users - 创建新用户

4. PUT /users/{id} - 更新用户信息

5. DELETE /users/{id} - 删除用户

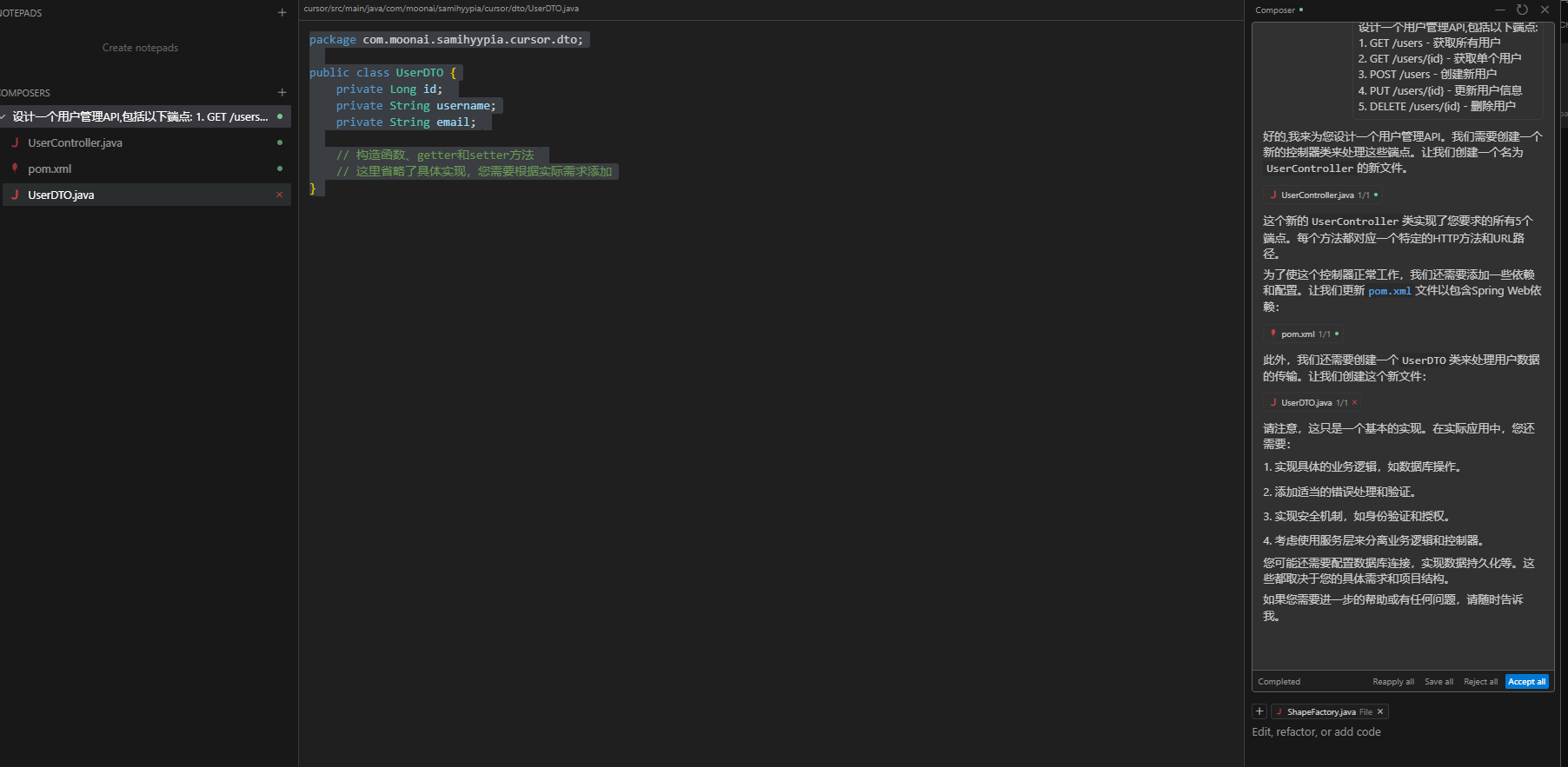

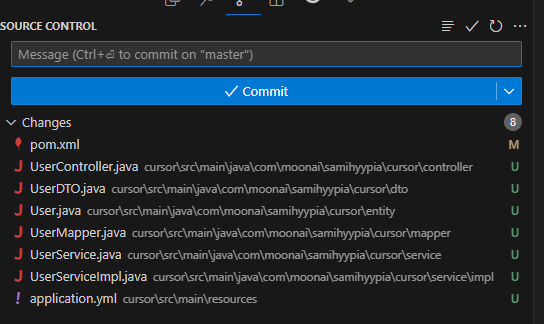

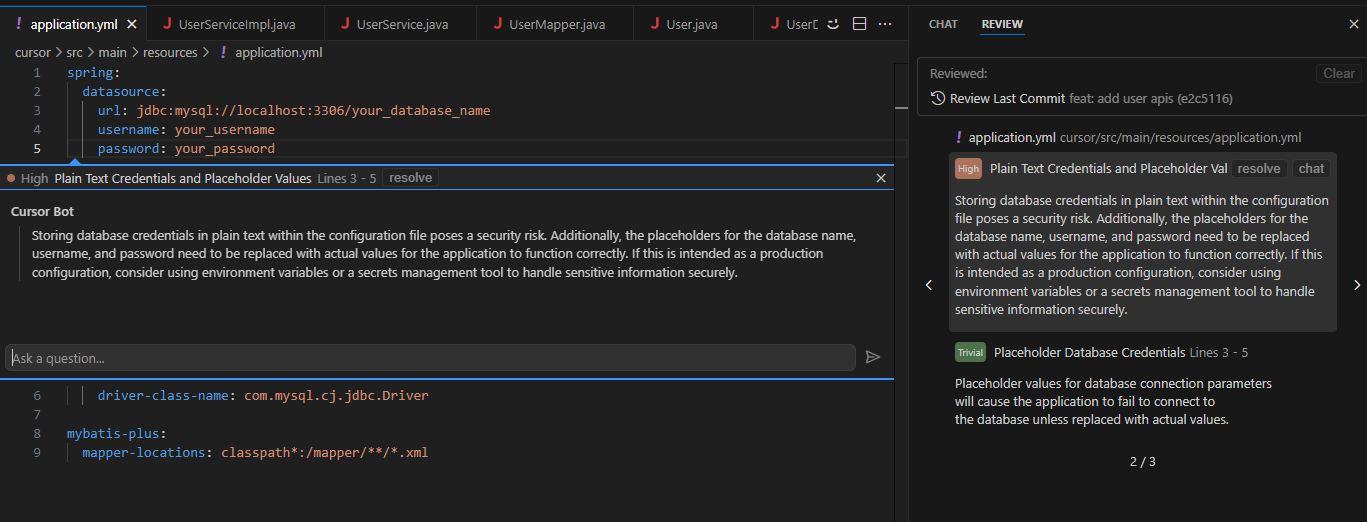

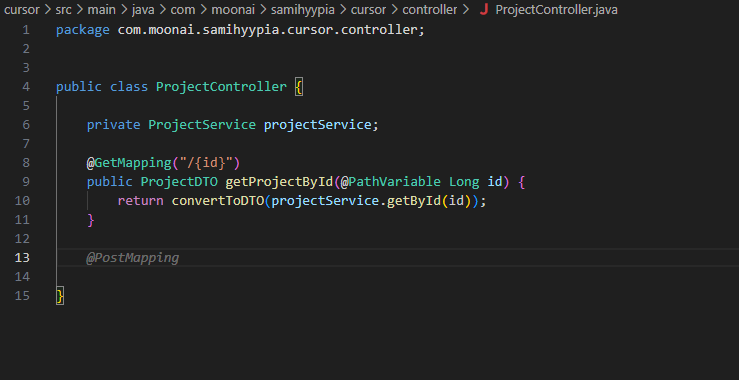

瞬间,Cursor就会为您生成完整的Controller类结构:

这不仅节省了大量编码时间,还确保了API设计的一致性和规范性。

智能代码生成:告别重复劳动

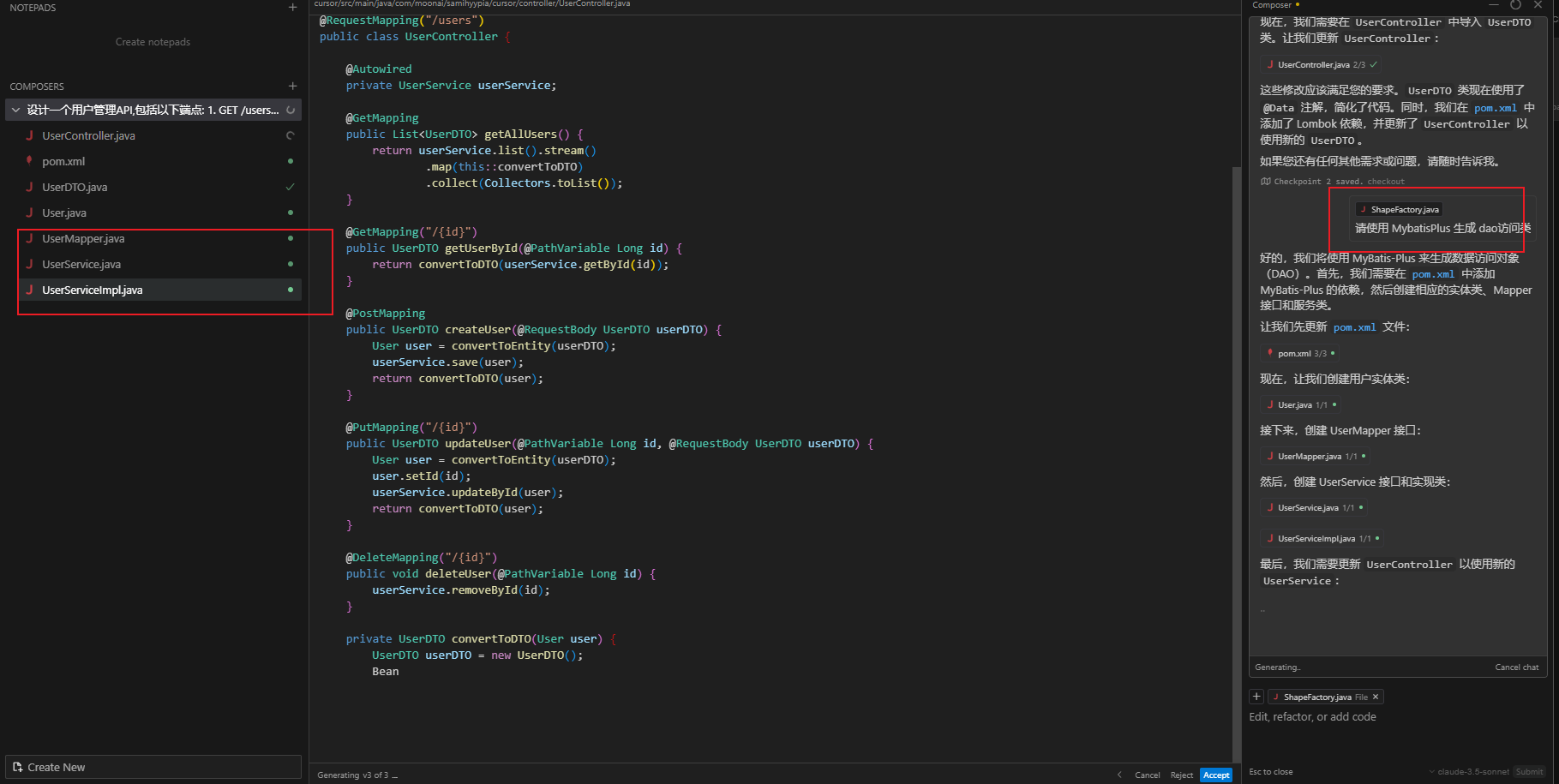

Cursor不仅能生成基本结构,还能根据您的需求进一步优化代码。例如,我们可以要求使用Lombok注解来简化DTO类:

甚至可以自动生成基于MyBatis-Plus的DAO访问类:

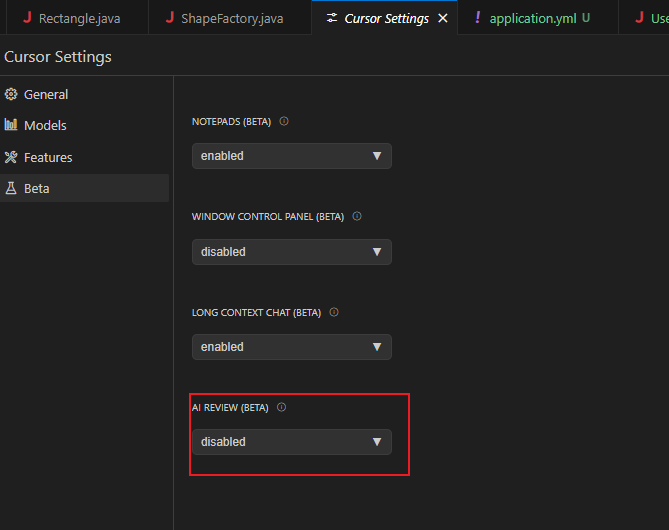

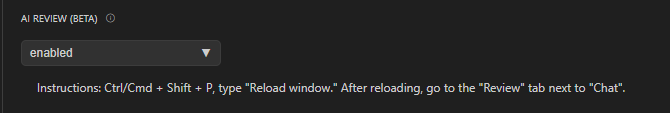

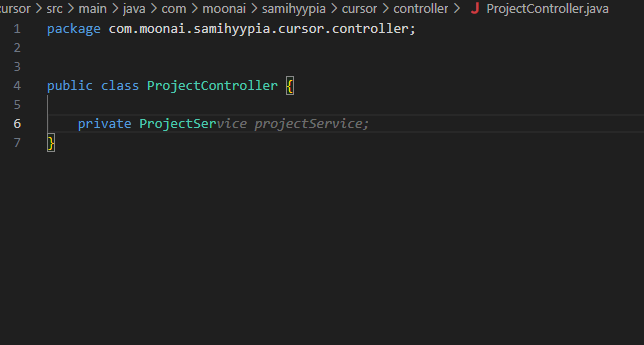

代码审查:提高代码质量

Cursor还提供了强大的代码审查功能。只需开启Review功能,Cursor就会自动分析您的代码,提供改进建议:

智能代码补全:提高开发效率

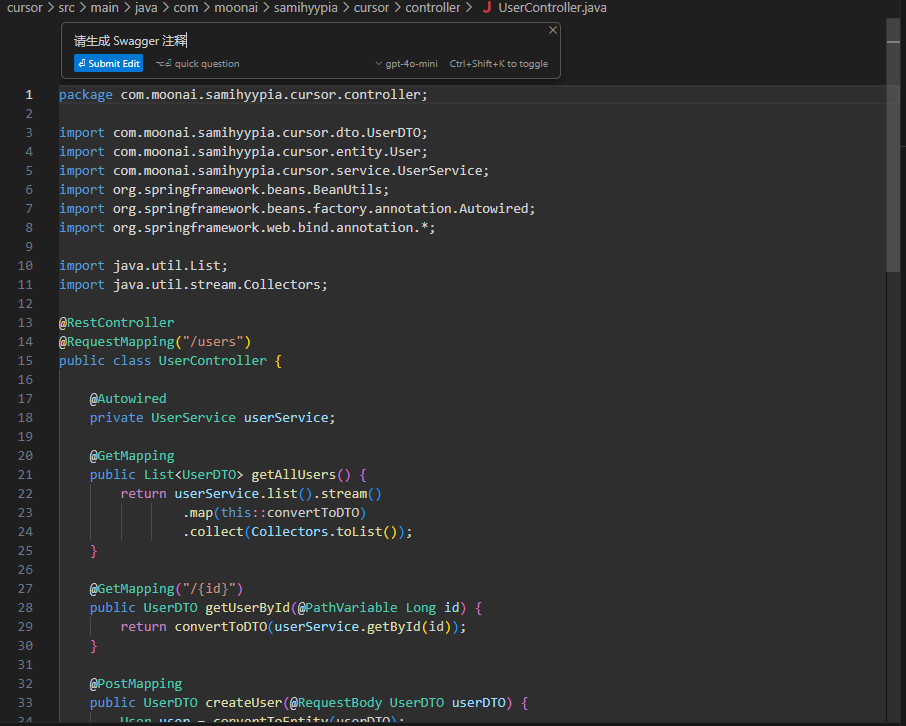

Cursor的智能Tab补全功能堪称开发者的得力助手。当您开始编写Controller方法时,只需按下Tab键,Cursor就会自动补全代码结构:

Swagger文档:一键生成

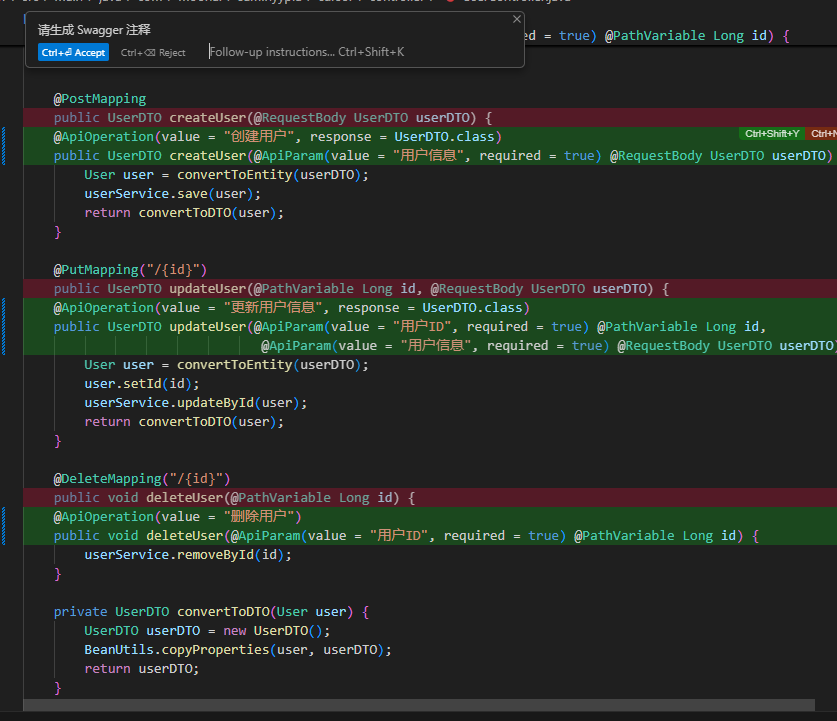

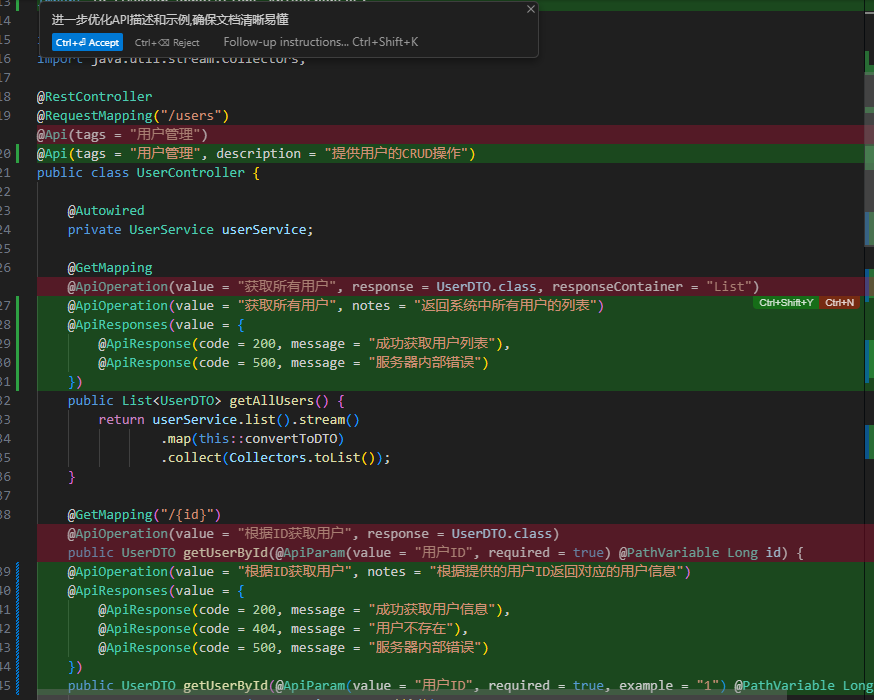

API文档的编写往往是开发者的心头痛。但有了Cursor,这个问题迎刃而解。通过简单的Ctrl+K快捷键,Cursor能自动为您的API方法生成Swagger注释:

这些注释不仅包含基本的API描述,还能自动识别参数类型和返回值,生成示例请求和响应。

实战练习:从零开始的图书管理API

为了充分展示Cursor的威力,让我们一起完成一个小项目——构建图书管理API。

- 首先,在Cursor Composer中描述API需求。

设计一个图书管理API,包括以下端点:

1. GET /books - 获取所有图书

2. GET /books/{id} - 获取单本图书

3. POST /books - 创建新图书

4. PUT /books/{id} - 更新图书信息

5. DELETE /books/{id} - 删除图书

- Cursor会立即生成Controller类框架。

- 使用Tab补全功能,快速实现各个方法。

- 最后,用Ctrl+K生成Swagger文档。

短短几分钟,一个功能完整、文档齐全的RESTful API就诞生了!

结语

Cursor不仅是一个代码编辑器,更是开发者的智能助手。它能大幅提升API开发效率,让您专注于创造性工作,而不是被繁琐的细节所困扰。

无论您是经验丰富的后端开发者,还是刚入门的新手,Cursor都能成为您的得力助手。它不仅能帮您写出更好的代码,还能让API开发变得更加轻松愉快。

那么,准备好提升您的API开发效率了吗?快来试试Cursor,让它成为您的API开发利器吧!