一个专门做特卖的网站可以做用户旅程图的网站

背景:上线的服务突然挂掉了

step1,去后端日志查看,发现并无异常,就是请求无法被接收

step2,查看了nginx的错误日志,发现该文件为空

step3,查看了niginx的运行日志,发现了以下问题

[error] 38#38: *474 connect() failed (113: No route to host) while connecting to upstream, client: 172.31.xx.xx, server: aibee.xxxx.edu.cn

分析该问题是端口问题,原以为是端口被关闭,查询后发现端口并没有被关闭

还有以下两种可能性

- 该问题端口并没有程序占用

- 该问题端口在本地防火墙未被打开

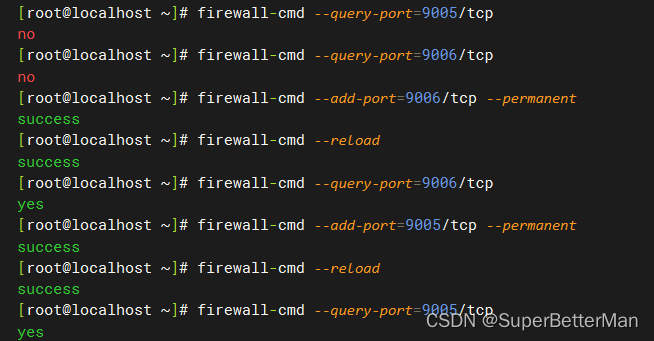

直接排除1的可能性,在本地防火墙查询该端口状态,果然出现问题

成功解决问题