个人网站建设知乎网站头部seo范例

分享115个HTML电子商务模板,总有一款适合您

115个HTML电子商务模板下载链接:https://pan.baidu.com/s/158y3jP0tv7ZikxNOBMKsSg?pwd=t970

提取码:t970

Python采集代码下载链接:采集代码.zip - 蓝奏云

import os

import shutil

import time

from time import sleep

from docx import Document

from docx.opc.oxml import qn

from docx.shared import Inches, RGBColor

from framework.base.BaseFrame import BaseFrame

from sprider.business.DownLoad import DownLoad

from sprider.business.SeleniumTools import SeleniumTools

from sprider.business.SpriderTools import SpriderTools

from selenium import webdriver

from selenium.webdriver.common.by import By

from sprider.model.SpriderEntity import SpriderEntity

from sprider.access.SpriderAccess import SpriderAccesstitle_name = "电子商务"class ChinaZJsSelenium:base_url = "https://sc.chinaz.com/" # 采集的网址save_path = "D:\\Freedom\\Sprider\\ChinaZ\\"sprider_count =114 #正在采集第10页的第7个资源,共38页资源sprider_start_count=565word_content_list = []folder_name = ""page_end_number=0max_pager=24#每页的数量haved_sprider_count =0 # 已经采集的数量page_count = 1 # 每个栏目开始业务content="text/html; charset=gb2312"filter_down_file=[]word_image_count=5 #word插入图片数量 同时也是明细采集图片和描述的数量sprider_detail_index = 0# 明细方法采集的数量 累加sprider_top_level="HTML"

小清新网上书店网页模板

小清新网上书店网页模板是一款适合电子商务图书销售网站模板。

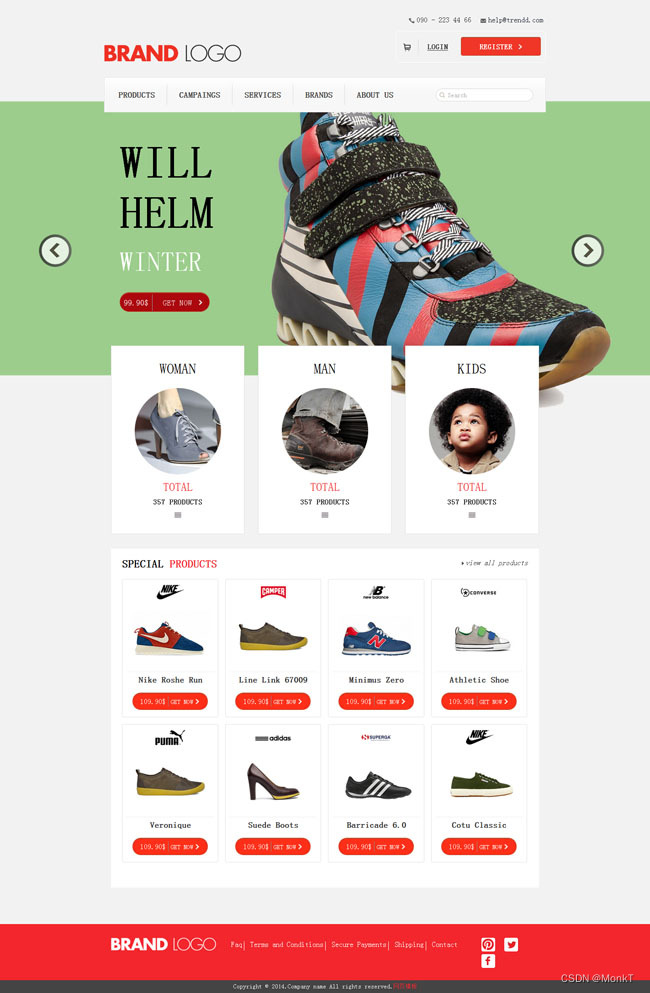

鞋子销售商城网站模板

鞋子销售商城网站模板是一款鞋帽电子商务销售公司网站模板。

蓝牙耳麦销售网站模板

蓝牙耳麦销售网站模板是一款简洁白色风格,适合电子商务网站模板下载。

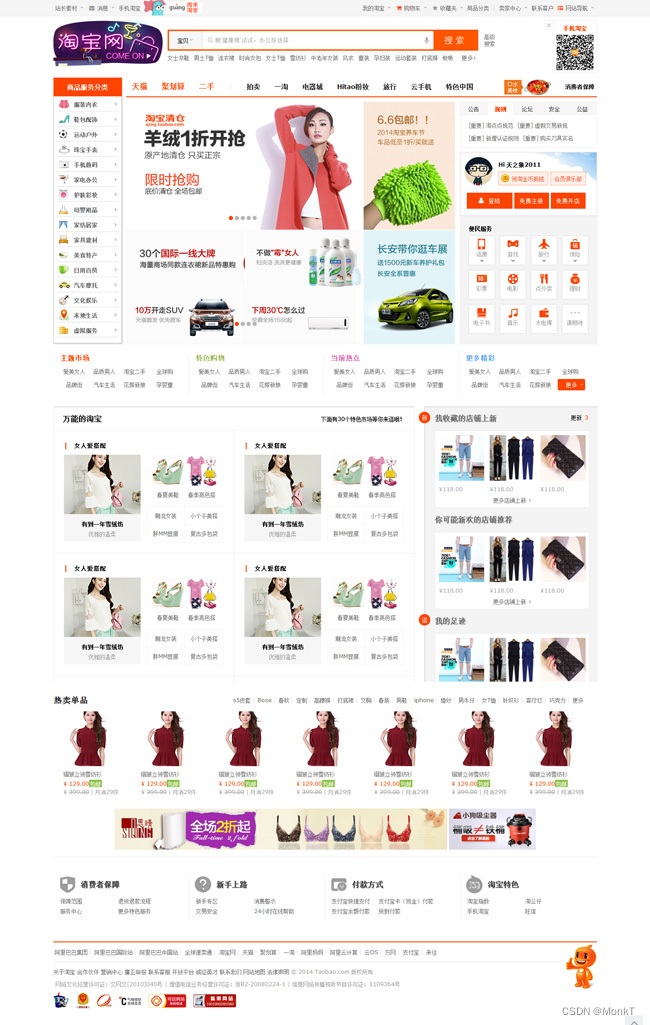

2014淘宝首页html模板

2014淘宝首页html模板是一款仿制淘宝首页的源代码html文件,近乎完美,浮动导航弹出。

2014淘宝首页html模板

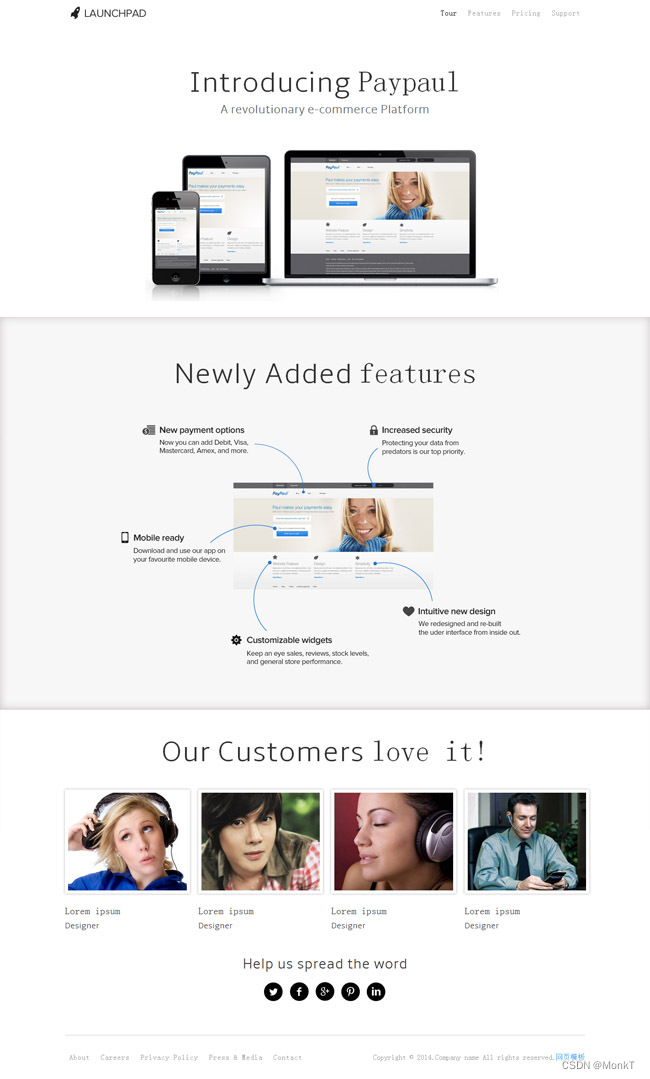

APP应用网站单页模板

b2c商城购物网站模板

Bootstrap3通用商城模板

HTML5化妆品电商网站模板

HTML5单页模版Art

HTML5家具商城响应式模板

HTML5扁平化电商网站模板

html购物网站模板下载

IDC服务器销售行业模板

iPhone手机应用软件模板

IT产品电子商务网站模板

IT公司网站CSS3模板

PSD韩国地球村商务模板

TM 商务模板FLASH

Web主机经销商html模板

WEB窄屏应用程序模板

书店商城网站html模板下载

企业商务CSS网页模板

企业平台CSS网页模板

优雅的后端管理电子商务模板

儿童用品公司HTML5网站模板

儿童用品电商HTML模板

儿童运动套装批发网站模板

冲浪服饰销售网站模板

创意办公家具设计网站模板

别墅销售网站模板下载

商业世界网站模板

def sprider(self,title_name):"""采集医疗保健 https://sc.chinaz.com/moban/YiLiaoBaoJian.html电子产品 https://sc.chinaz.com/moban/DianZiChanPin.html电子商务 https://sc.chinaz.com/moban/DianZiShangWu.html:return:"""if title_name == "医疗保健":self.first_column_name = "moban"self.folder_name = "HTML医疗保健模板"self.second_column_name = "YiLiaoBaoJian"elif title_name == "电子产品":self.first_column_name = "moban"self.folder_name = "HTML电子产品模板"self.second_column_name = "DianZiChanPin"elif title_name == "电子商务":self.first_column_name = "moban"self.folder_name = "HTML电子商务模板"self.second_column_name = "DianZiShangWu"BaseFrame().right("本次采集参数:sprider_count=" + str(self.sprider_count) + "")BaseFrame().right("本次采集参数:title_name="+title_name+"")BaseFrame().right("本次采集参数:second_column_name=" + self.second_column_name + "")# self.folder_name = "JS表单验证"self.sprider_category = title_name # 一级目录self.folder_namesecond_folder_name = str(self.sprider_count) + "个" + self.folder_name #二级目录self.sprider_type =second_folder_nameself.merchant=int(self.sprider_start_count) //int(self.max_pager)+1 #起始页码用于效率采集#原始路径+一级目录+二级目录self.file_path = self.save_path + os.sep + self.sprider_top_level + os.sep + self.folder_name + os.sep + second_folder_nameself.save_path = self.save_path+ os.sep + self.sprider_top_level + os.sep+self.folder_name +os.sep + second_folder_name+ os.sep + self.folder_nameBaseFrame().debug("开始采集ChinaZJL"+self.folder_name+"...")sprider_url = (self.base_url + "/{1}/{0}.html".format(self.second_column_name,self.first_column_name))down_path="D:\\Freedom\\Sprider\\ChinaZ\\"+self.sprider_top_level +"\\"+self.folder_name +"\\"+second_folder_name+"\\Temp\\"if os.path.exists(down_path) is True:shutil.rmtree(down_path)if os.path.exists(down_path) is False:os.makedirs(down_path)if os.path.exists(self.save_path ) is True:shutil.rmtree(self.save_path )if os.path.exists(self.save_path ) is False:os.makedirs(self.save_path )chrome_options = webdriver.ChromeOptions()diy_prefs ={'profile.default_content_settings.popups': 0,'download.default_directory':'{0}'.format(down_path)}# 添加路径到selenium配置中chrome_options.add_experimental_option('prefs', diy_prefs)chrome_options.add_argument('--headless') #隐藏浏览器# 实例化chrome浏览器时,关联忽略证书错误driver = webdriver.Chrome(options=chrome_options)driver.set_window_size(1280, 800) # 分辨率 1280*800#BaseFrame().debug("开始采集"+sprider_url)driver.get(sprider_url)# content = driver.page_sourceelement_list = driver.find_elements(By.CLASS_NAME, "masonry-brick") # 列表页面 核心内容 box col3 ws_block masonry-brick#element_list = div_elem.find_elements(By.CLASS_NAME, 'item')#print(element_list.get_attribute('innerHTML'))laster_pager_div = driver.find_element(By.CLASS_NAME, "fenye")laster_pager_a = laster_pager_div.find_elements(By.TAG_NAME, 'a')laster_pager_url = laster_pager_a[len(laster_pager_a) - 2]page_end_number = int(laster_pager_url.text)self.page_count=self.merchantwhile self.page_count <= int(page_end_number): # 翻完停止try:if self.page_count == 1:self.sprider_detail(driver,element_list,self.page_count,page_end_number,down_path)passelse:if self.haved_sprider_count == self.sprider_count:BaseFrame().debug("采集到达数量采集停止...")BaseFrame().debug("开始写文章...")self.builder_word(self.folder_name, self.word_content_list)BaseFrame().debug("文件编写完毕,请到对应的磁盘查看word文件和下载文件!")break#(self.base_url + "/sort/{0}/{1}/".format(url_index, self.page_count))#http://soft.onlinedown.net/sort/177/2/#https://sc.chinaz.com//jianli/xiaochengchu_2.htmlnext_url = self.base_url + "/{2}/{0}_{1}.html".format(self.second_column_name, self.page_count,self.first_column_name)driver.get(next_url)element_list = driver.find_elements(By.CLASS_NAME, "masonry-brick") # 列表页面 核心内容self.sprider_detail( driver, element_list, self.page_count, page_end_number, down_path)pass#print(self.page_count)self.page_count = self.page_count + 1 # 页码增加1except Exception as e:print("sprider()执行过程出现错误:" + str(e))sleep(1)商业相机CSS网页模板

商务公司网站模板下载

商务公司网页模板下载

商务合作HTML模板下载

商务手机模板

商务科技模板

商务设计CSS网页模板

图片存储企业html5模板

城市商务网站模板下载

多功能电子商务网页模板

大气商务网页模板下载

大气购物商城模板免费下载

婴儿用品商城网站模板

媒体网络CSS网页模板

小清新网上书店网页模板

巴黎时装秀购物网站模板

干净风格业务主题模板

扁平风格电子商务模版aditii

手机APP软件网站模板

手机网站CSS网页模板

数字公司CSS3模板

时尚商务css模板下载

服装B2C在线购物商城HTML5模板

服装电商网上商城HTML5模板

服装电子商务公司网站模板

橙色欧美商务网站模板

欧美商务合作HTML模板

欧美大气商务网站模板

欧美灰色html商务模板

汽车销售css网站模板

淡蓝色女包购物商城模板

灯饰灯具销售网站模板

电器销售企业网站模板

电子产品商城模板Complex

电子产品百货商城网站模板

电子商务模板下载

电子商务百货公司整站模板

电子购物商城网站模板

电影票在线购买网站模板

登山外套B2C商城网站模板

百货商场bootstrap模板下载

眼镜销售公司html5网站模板

程序设计CSS网页模板

粉红色礼品页面CSS模板

粉红色钻戒销售网站模板

粉色内衣网店模板下载

紫色商务CSS网页模板

红色资讯类门户网站模板

红色风格HTML5销售模板

纯色商务外贸英文模板

绿色时钟商务整站模板

绿色有机商店html模板

网店设计CSS网页模板

网店销售网站模板下载

网站开发CSS网页模板

网络世界html5网站模版

股票网站HTML5红色模板

色彩斑斓软件类模板

色彩鲜艳的HTML5商务模板

葡萄酒Html5电子商务模板

葡萄酒高端主题CSS模板

蓝牙耳麦销售网站模板

蓝色商务Html5网站模板

超市商店官网网站模板

车展汽车展示html模板

酒店网上预订html模板

import osdef void_file(dirPath):dirs = os.listdir(dirPath) # 查找该层文件夹下所有的文件及文件夹,返回列表for file in dirs:file_full_name = dirPath + '/' + filefile_ext = os.path.splitext(file_full_name)[-1]if file_ext is None or file_ext=="":continueif "rar" == str(file_ext.split(".")[1]):os.remove(file_full_name)if "zip" == str(file_ext.split(".")[1]):os.remove(file_full_name)if "gz" == str(file_ext.split(".")[1]):os.remove(file_full_name)if "tgz" == str(file_ext.split(".")[1]):os.remove(file_full_name)# 查找指定文件夹下所有相同名称的文件

def search_file(dirPath, fileName):dirs = os.listdir(dirPath) # 查找该层文件夹下所有的文件及文件夹,返回列表for currentFile in dirs: # 遍历列表absPath = dirPath + '/' + currentFileif os.path.isdir(absPath): # 如果是目录则递归,继续查找该目录下的文件search_file(absPath, fileName)elif currentFile == fileName:print(absPath) # 文件存在,则打印该文件的绝对路径os.remove(absPath)鞋包销售HTML网站模板

鞋子电子商务html网站模板

鞋子销售商城网站模板

韩国商务PSD模板

韩国商务PSD模板下载

韩国商务交流模板下载

韩国商务合作模板下载

韩国商务模板下载

韩国商务网站模板下载

韩国商务网页模板下载

韩国商务设计模板

韩国商务设计模板下载

韩国商务风光模板下载

韩国团队合作模板下载

韩国城市商务PSD模板

韩国城市商务模板下载

韩国城市科技模板下载

韩国电子商务PSD模板

韩国电子商务模板

韩国电子商务模板下载

韩国绿色商务模板下载

韩国网络商务模板下载

韩国网络通讯模板下载

高新科技HTML5模板

黄色卡通美食网站模板

黄色理财Html5网站模板

黄色视觉设计css模板

黑色商业服务html5模板

黑色商务css网站模板TM 商务模板FLASH

韩国电子商务模板

最后送大家一首诗:

山高路远坑深,

大军纵横驰奔,

谁敢横刀立马?

惟有点赞加关注大军。