阿里云服务器win系统建站教程gzip 网站

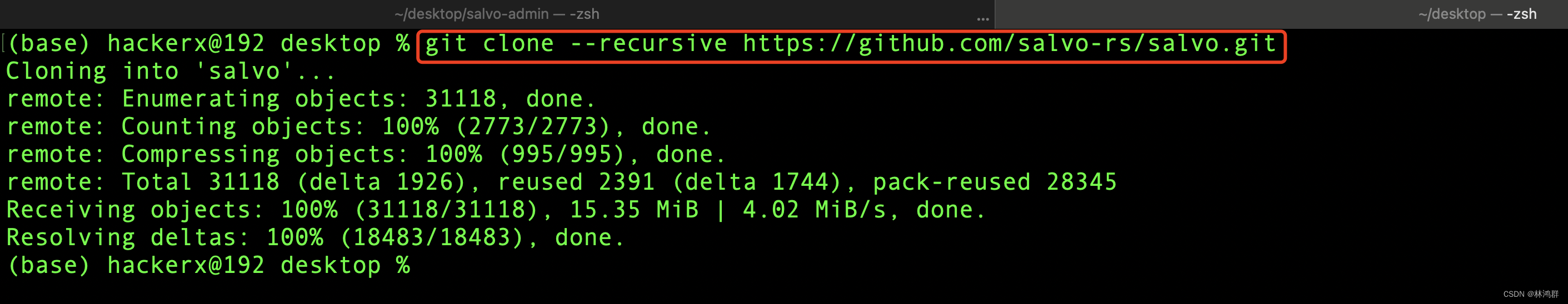

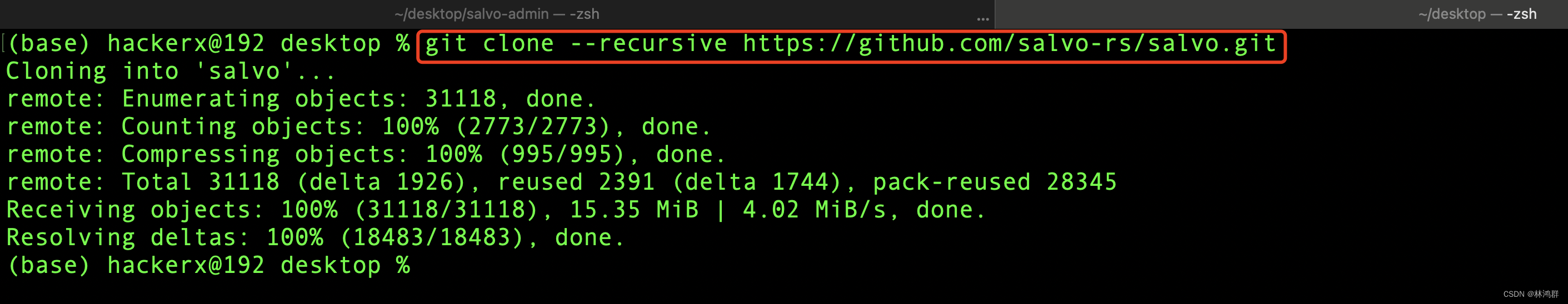

1.克隆源码:

https://github.com/salvo-rs/salvo.git

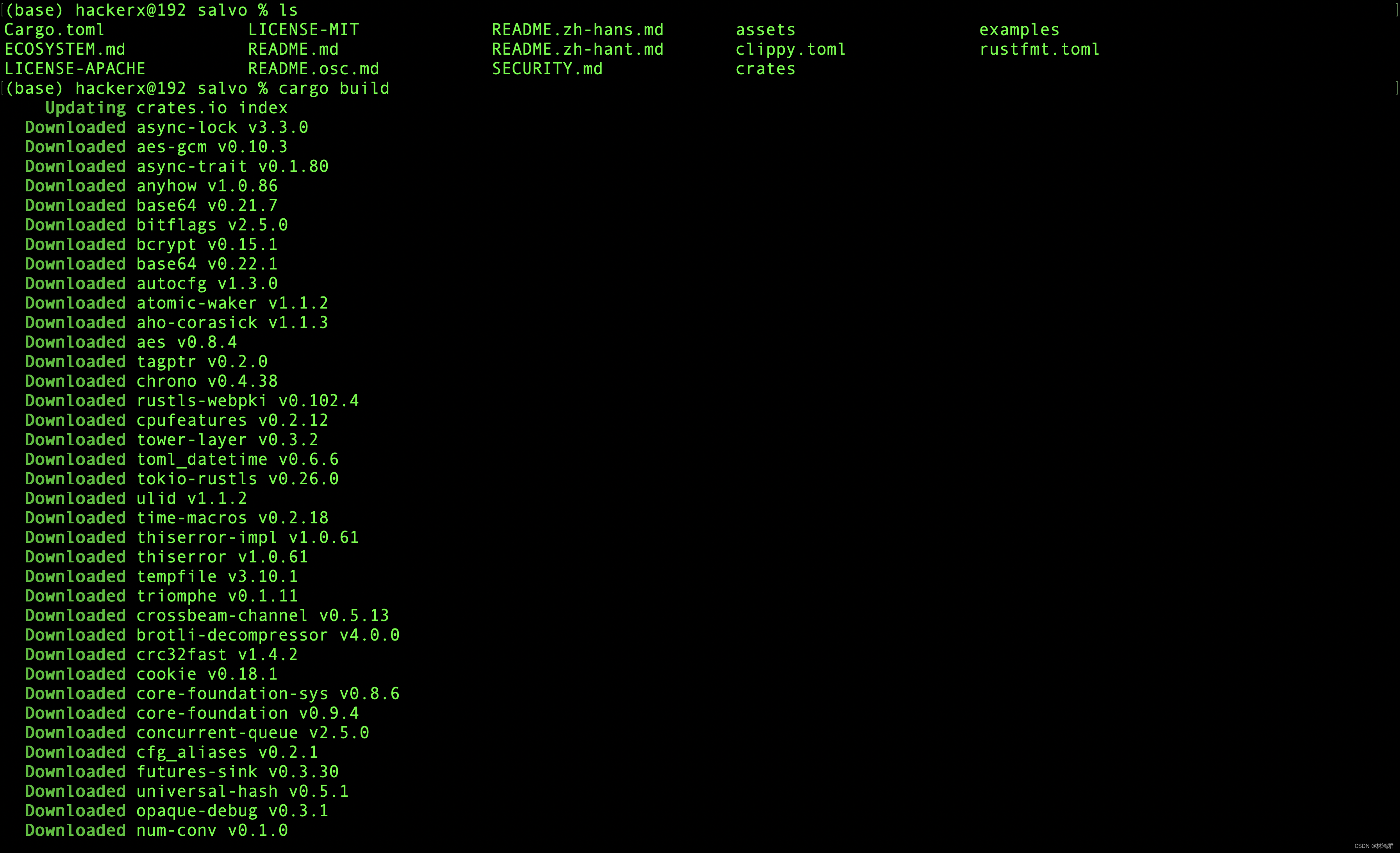

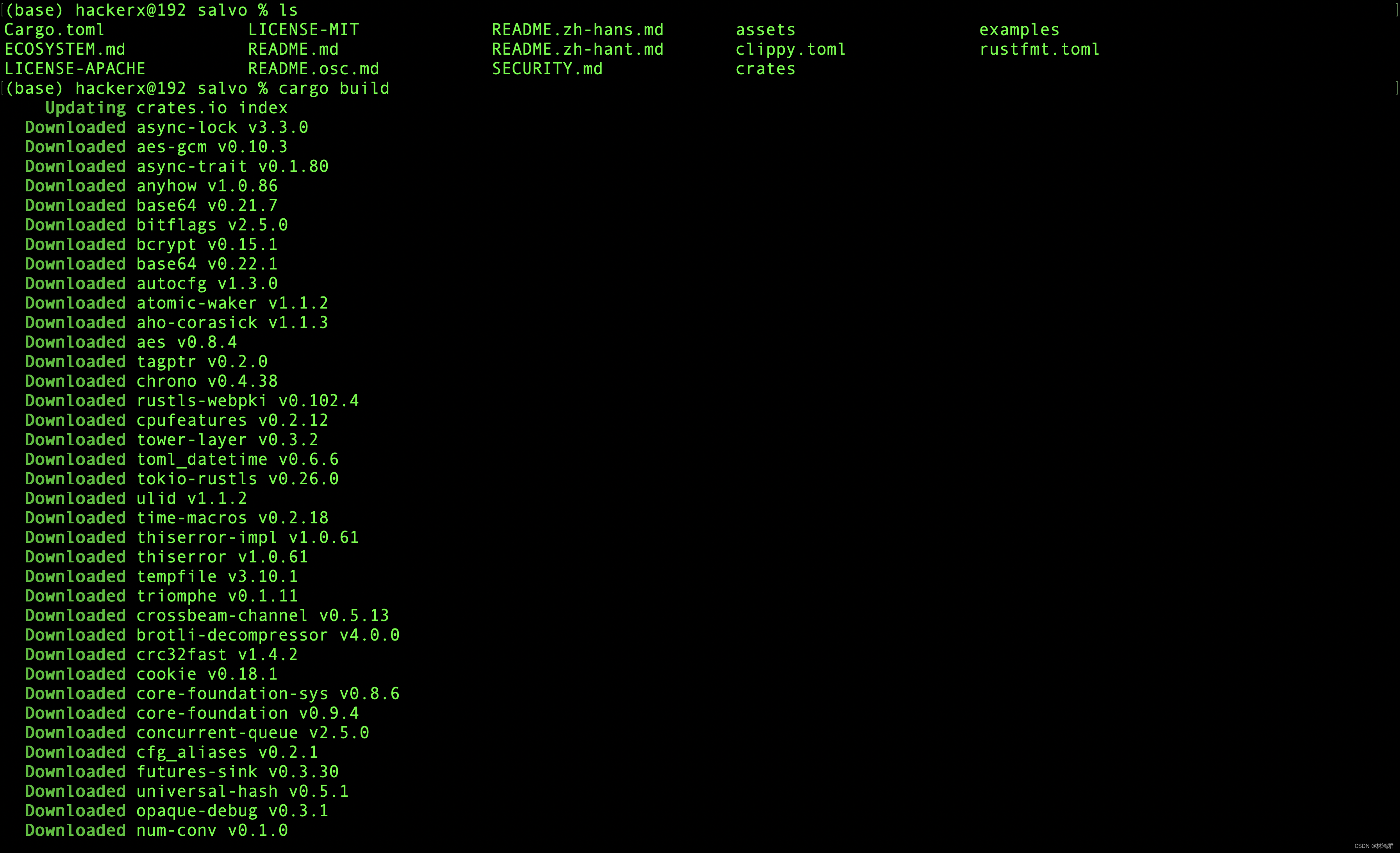

2.进入salve目录并运行cargo build编译

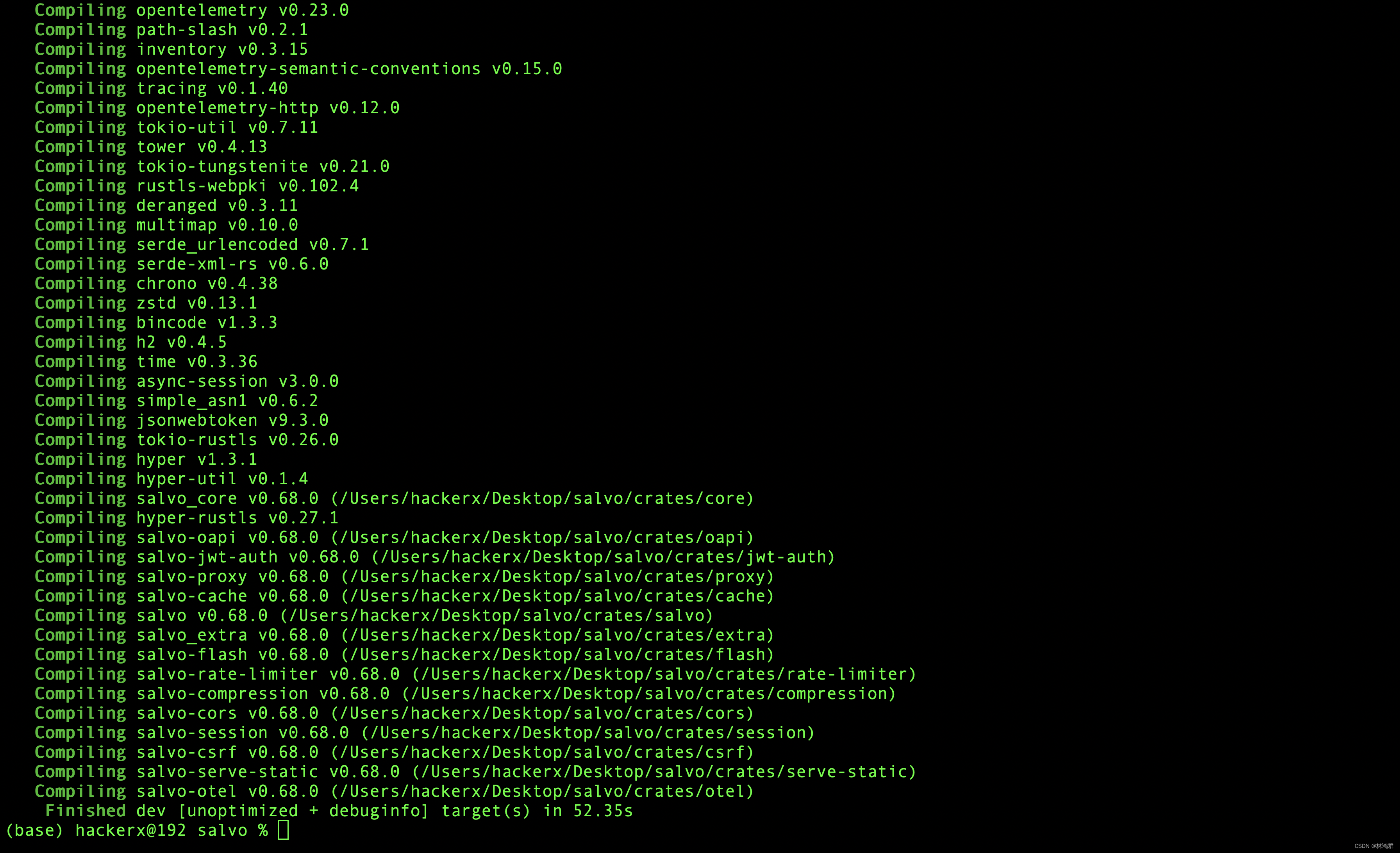

编译成功

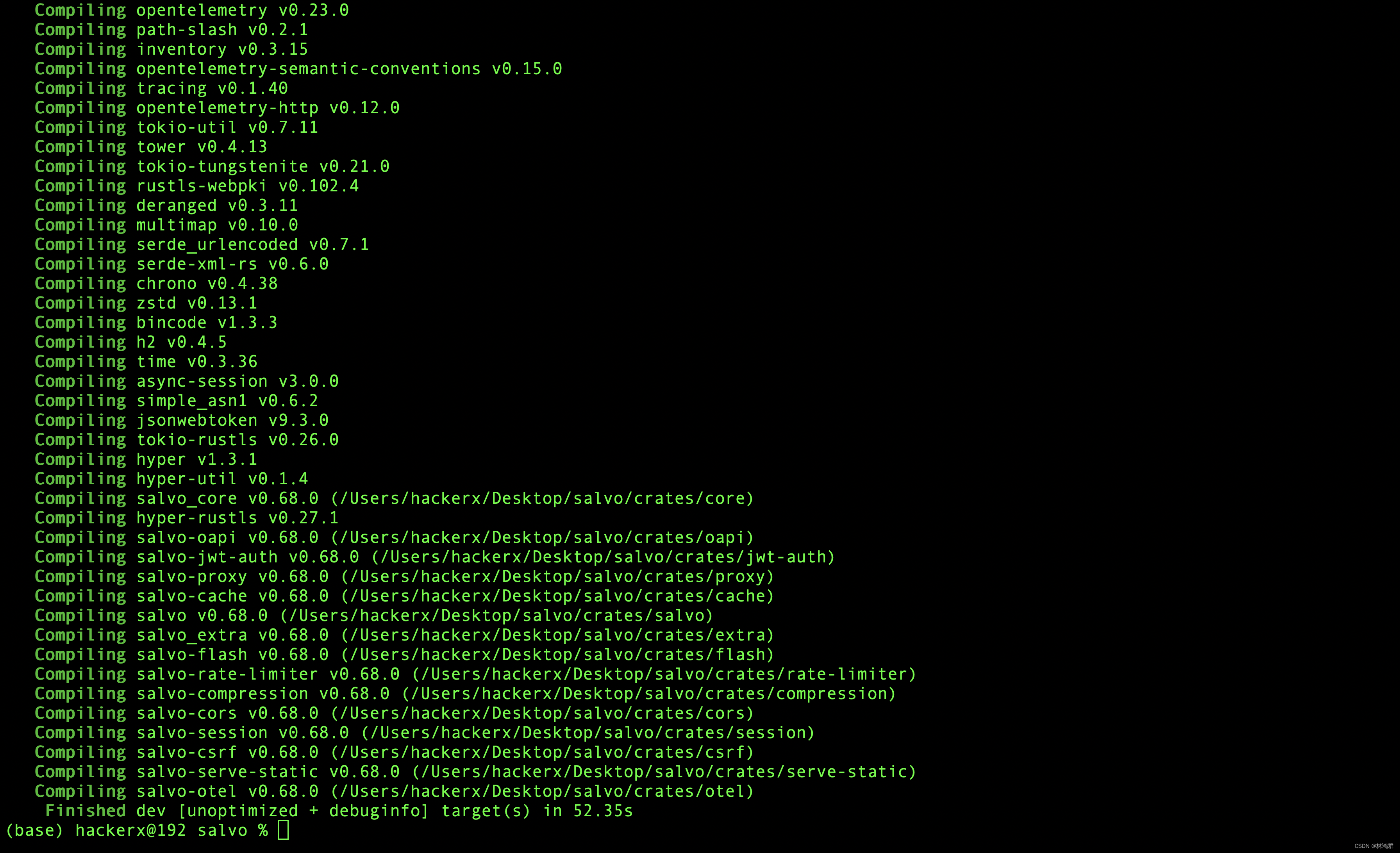

编译成功

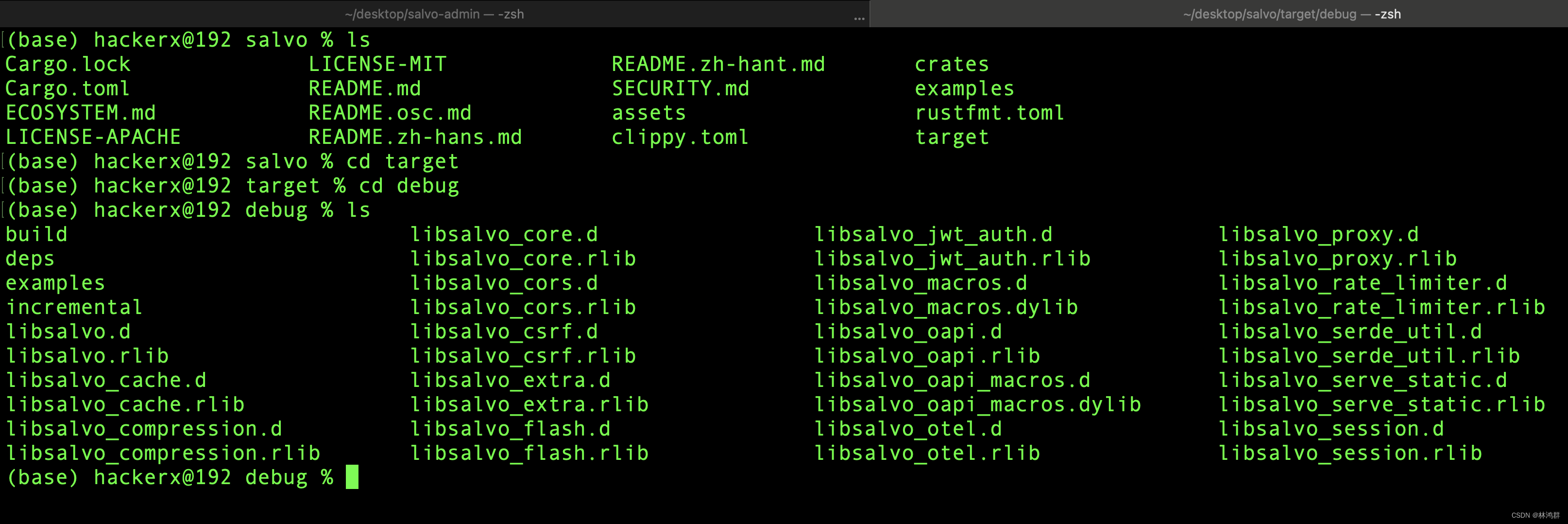

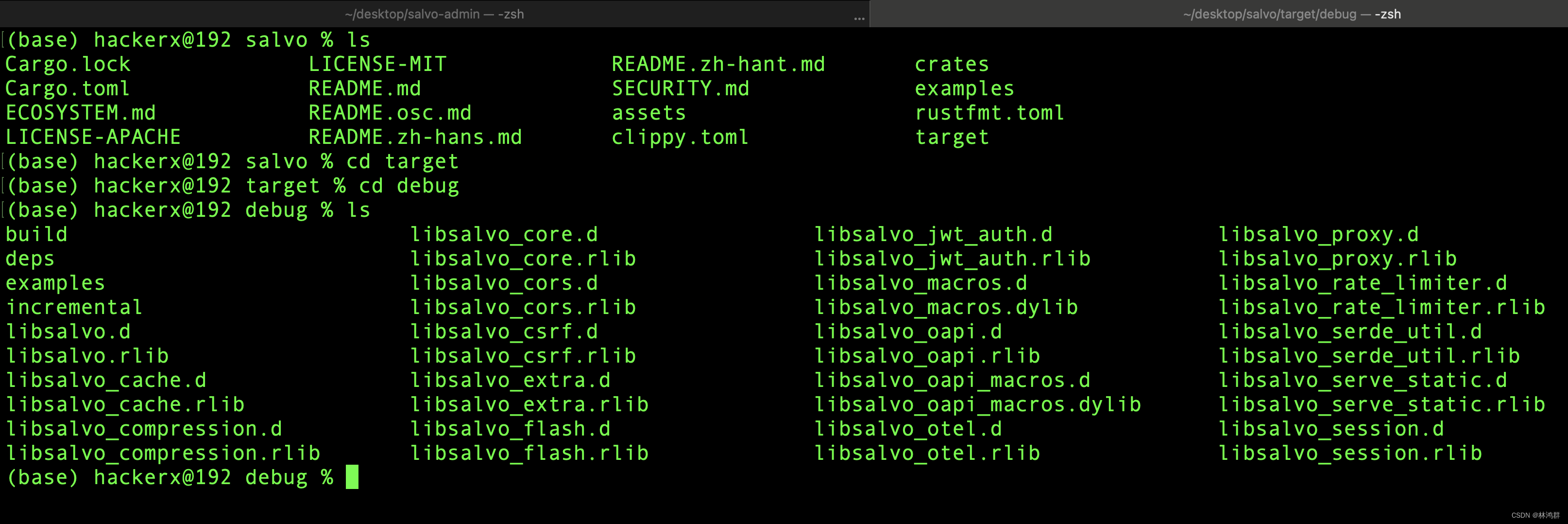

3.编译生成的库

4.安装salve-cli

4.安装salve-cli

git clone --recursive https://github.com/salvo-rs/salvo-cli.git编译salve-cli

1.克隆源码:

https://github.com/salvo-rs/salvo.git

2.进入salve目录并运行cargo build编译

编译成功

编译成功

3.编译生成的库

4.安装salve-cli

4.安装salve-cli

git clone --recursive https://github.com/salvo-rs/salvo-cli.git编译salve-cli