seo网站点击量排名优化媒体这些渠道进行采集的是

文章目录

- 1.早期的冯诺依曼机

- 2.早期冯诺依曼机的基本运行框图

- 3.早期冯诺依曼机的特点

- 4.现代计算机的结构

- 5. 小结

本次及以后有关于计算机组成原理的文章,旨在做学习时的记录和知识的分享。不论是应对期末考试,还是考研都是很有帮助的。希望大家多多支持更新!!!❤️❤️❤️

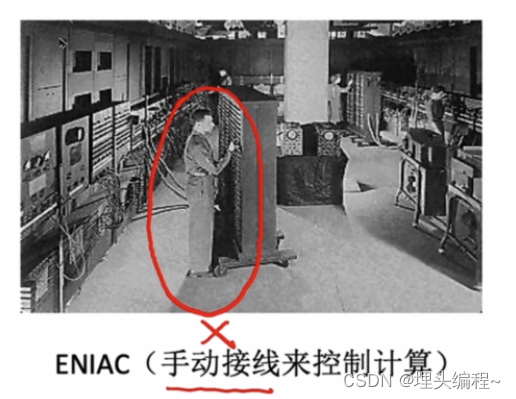

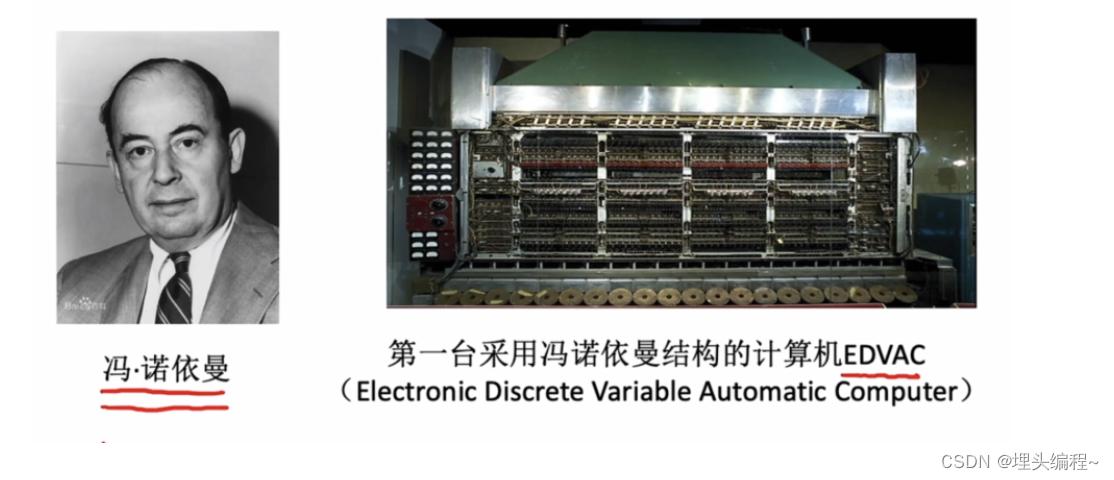

1.早期的冯诺依曼机

- 在早期的ENIAC计算机中,程序员们需要手动将线插入电脑中,来控制计算机的计算,因此计算机运行速度的优势就被手工接线这种方法给中和掉了。为了解决这个问题,冯诺依曼提出了“存储程序”的概念。

- 所谓存储程序就是:提前将指令以二进制的方式写好,将它存储在计算机的主存储器当中,然后交给计算机按其在存储器当中的首地址开始执行第一条指令,之后一条一条执行,直至程序结束。

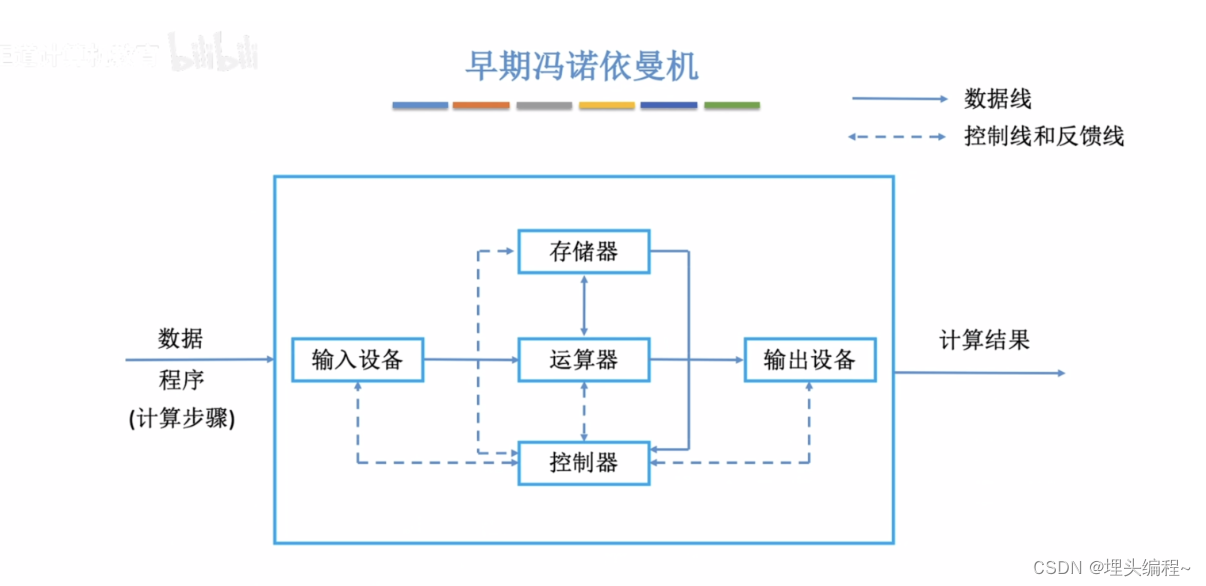

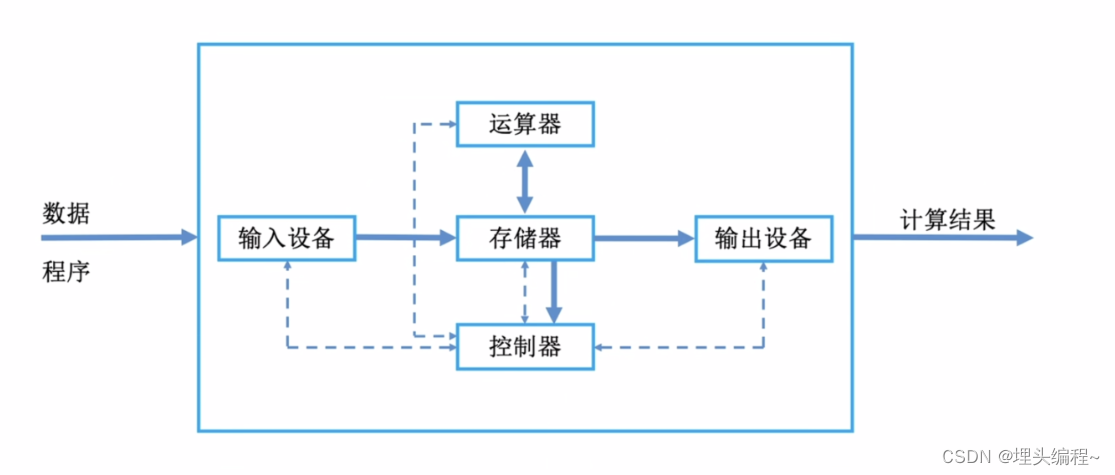

2.早期冯诺依曼机的基本运行框图

- 输入设备:将外部的数据和程序等信息转化成计算机能识别的形式(二进制形式);

- 储存器:存放数据和程序;

- 运算器:进行算术运算和逻辑运算;

- 输出设备:将结果转化为人们熟悉的形式(图片、声音、文字等);

- 控制器:指挥程序的运行;

在计算机系统中,软件和硬件在逻辑上是等价的。比如:给你一个乘法运算,用软件执行的成本要比硬件的成本要低,但速度要比硬件的慢。硬件(设计以专门的电路)刚好相反。

3.早期冯诺依曼机的特点

- 计算机有五大部件组成(其中输出/输入设备可被称为I/O设备)

- 指令和数据以同等的地位储存在存储器当中,可按地址寻访

- 指令和数据都是以二进制的方式表示

- 指令由操作码和地址码组成

- 储存程序

- 以运算器为中心(输入/输出设备与储存器之间的数据传送通过运算器来完成),缺点:导致数据计算的效率降低。

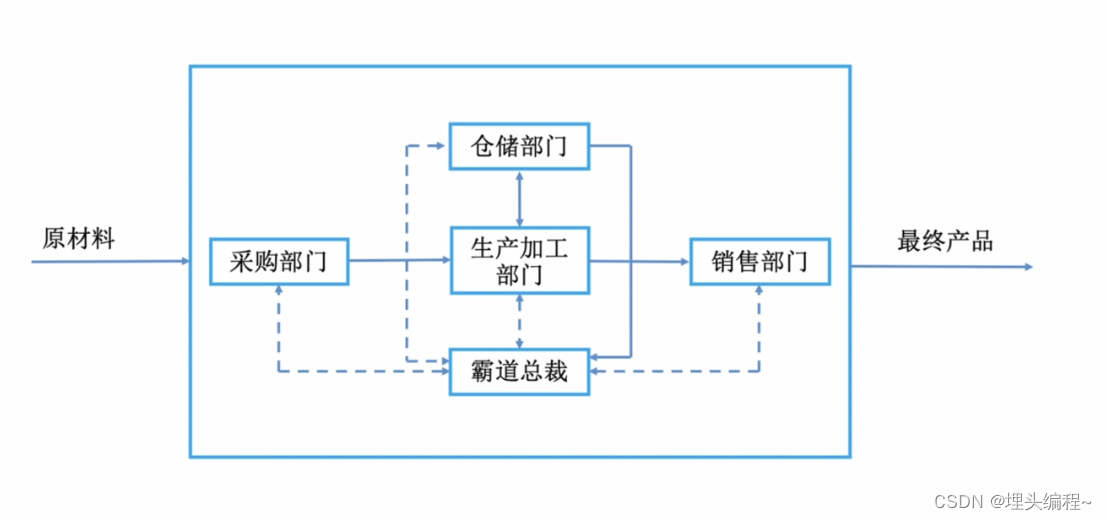

举一个加工厂的例子:

如果销售部门要拿商品出来买时,得先从生产加工部门发出请求,然后由生产加工部门从仓储部门拿出商品后,再把它交给销售部门。那有的人会想❓,我直接从仓储部门拿出看来不就好了,何必大费周章呢?如果你这么想,那恭喜你,你已经跟上了计算机科学家们的脚步了。

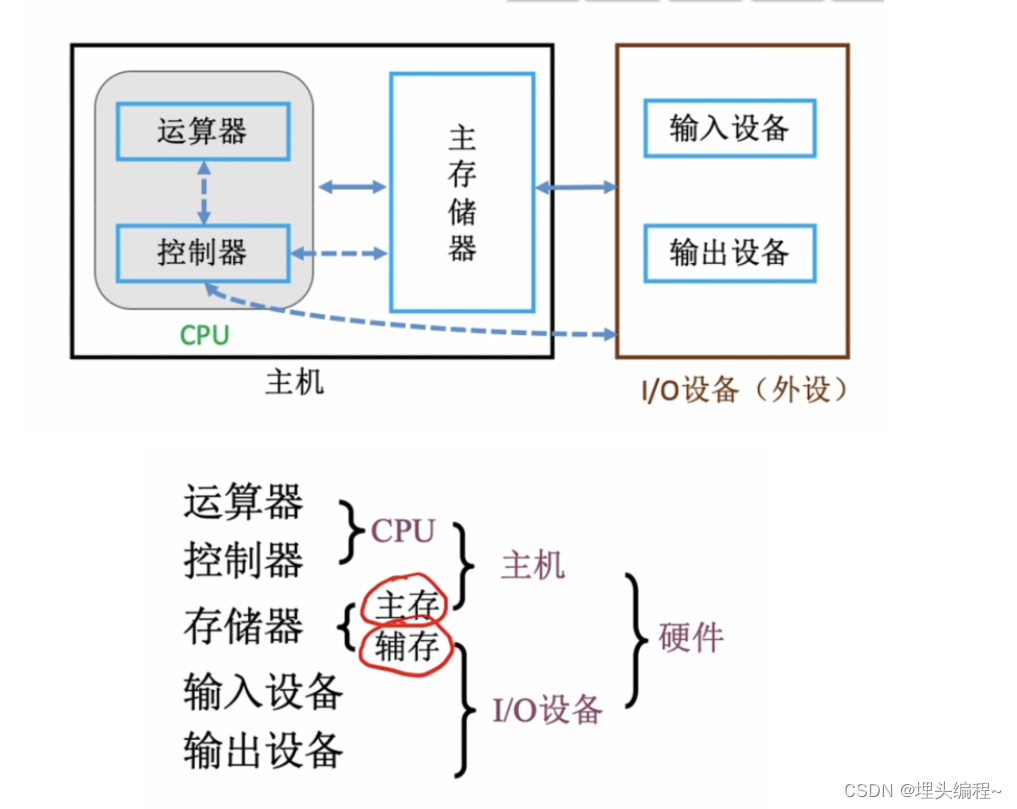

4.现代计算机的结构

通过输入设备将外部的数据和程序转化为计算机熟悉的形式,再将他们存放在存储器当中,由运算器从储存器获取数据进行算术和逻辑的运算,再将运算后的结果存放回储存器当中,最后再由输出设备将这些数据和程序转化为人们熟悉的形式。当然在这些步骤中,必然少不了控制器有条不紊的指挥。

差异:这种模式相比早期的冯诺依曼结构的运算效率快了不少,现代计算机是以储存器为中心。

CPU = 运算器 + 控制器

这里需要知道是的是:SSD属于辅存,是输入设备的一种。

5. 小结

本文主要是讲解了基于早期的冯诺依曼机的组成逻辑结构,逐渐延伸到了现代的计算机逻辑结构。其中还讲解了硬件的基本组成,旨在为后面的学习打好基础。