提供手机自适应网站网站后台管理系统管理员登录

在生成了BSW模块的代码后, 切换到ISOLAR-A系统级设计界面,会发现产生一些基础软件模块的服务软件组件:

BswM、 ComM、 Det和EcuM等, 如图6.60所示。

图6.60 生成了BSW后的服务软件组件

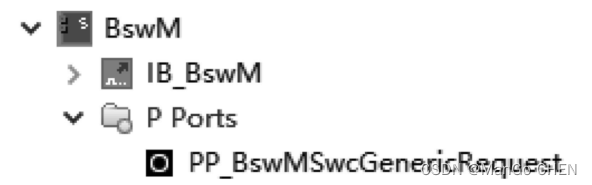

此时, 如果涉及服务软件组件与应用层软件组件的交互, 就需要为应用层软件组件添加相应的服务端口。 本书示例中, 在BswM模块配置阶段已经设计了相应的BswMModeRequestPort, 名为BswM_MRP_ApplicationRequestPort, 打开BswM软件组件也可以看到该端口的信息, 如图6.61所示。

图6.61 BswM软件组件

按照本书示例开发需求, 该端口是和应用层EcuBaseSWC软件组件进行交互的, 所以需要按照基于ISOLAR-A的软件组件设计方法中所提到的方法为EcuBaseSWC软件组件添加一个Port, 其Port Interface为BswMSwcGenericRequest_ClientServerInterface, 结果如图6.62所示。