慕课网电子商务网站开发win10建设本地网站

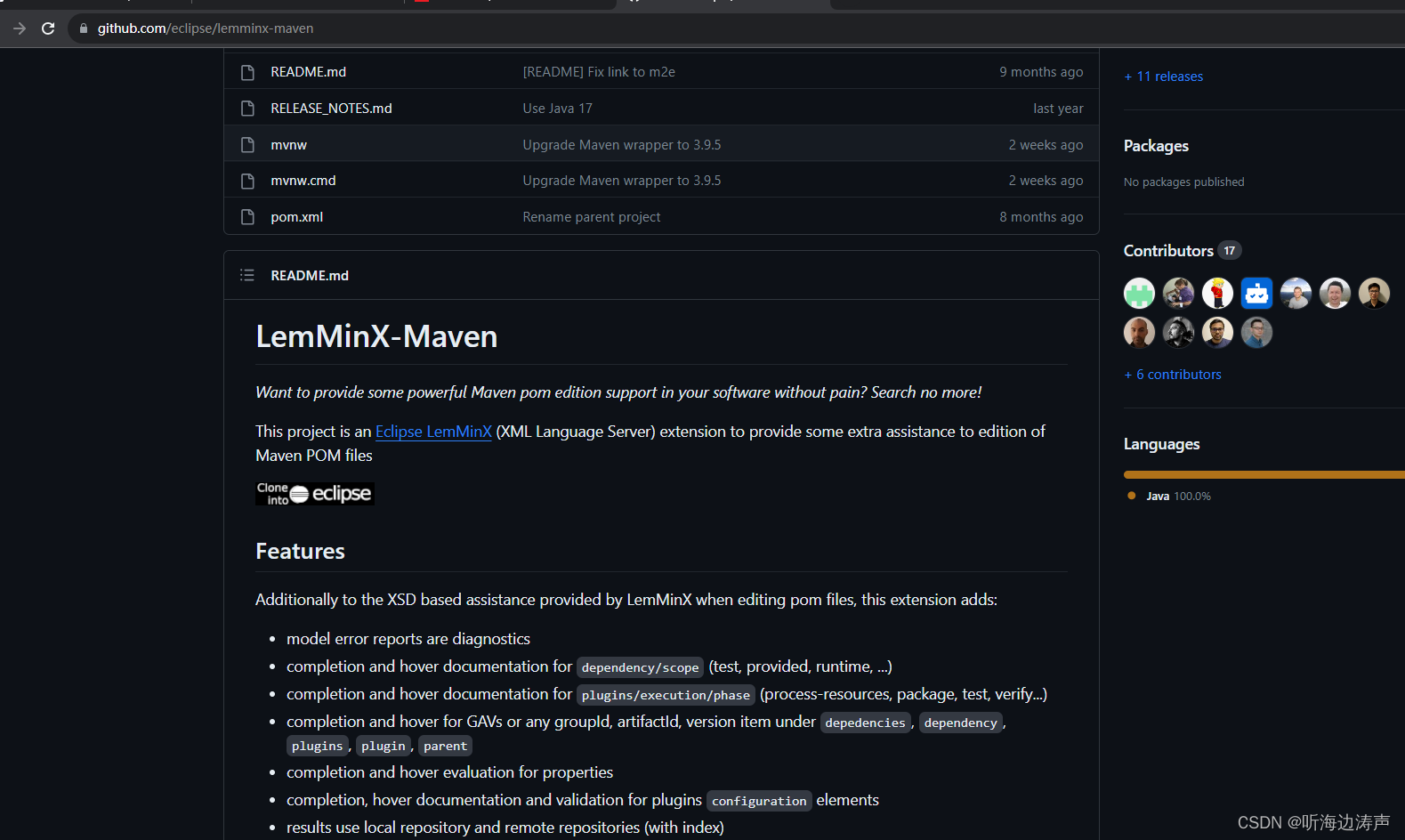

LemMinX-Maven:https://github.com/eclipse/lemminx-maven

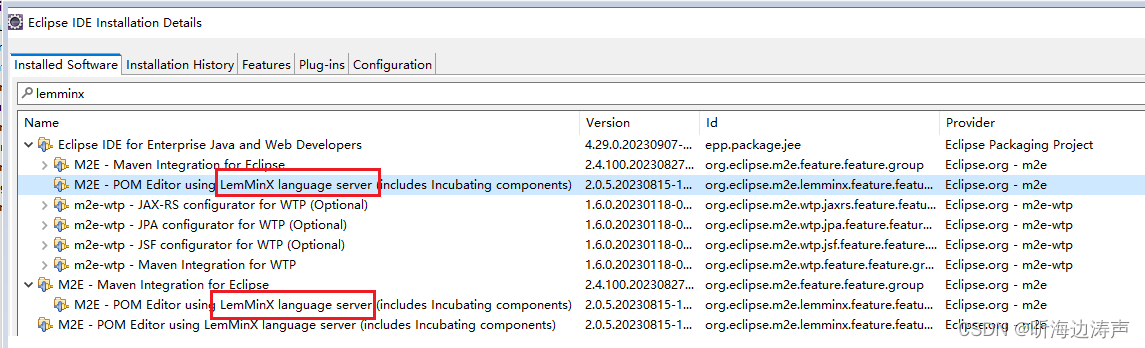

LemMinX-Maven可以帮助我们在eclipse中更方便地编辑maven工程的pom.xml文件,例如补全、提示等。不用单独安装,因为在安装maven eclipse插件的时候已经自动安装了:

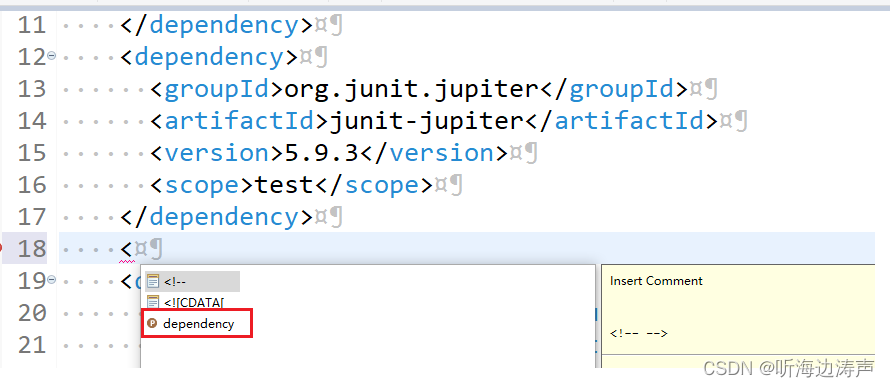

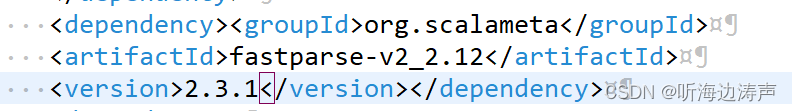

例如,编辑maven工程的pom.xml文件,增加一个依赖:

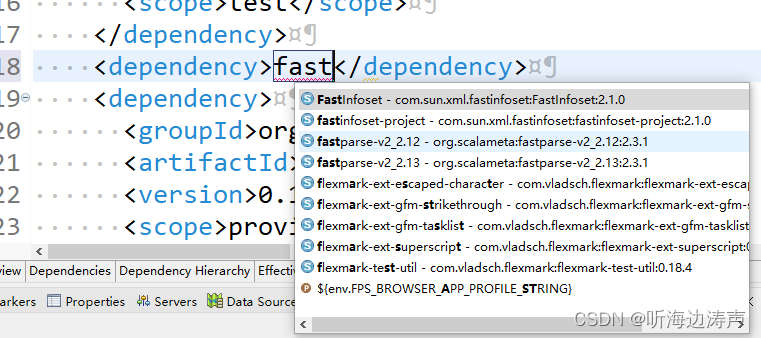

选择自己认为合适的,回车,就自动全部添加上了:

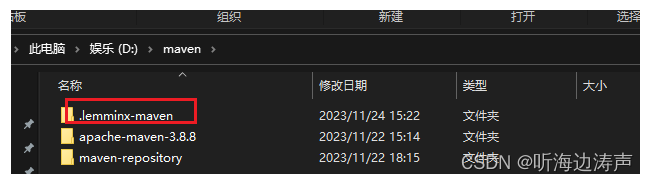

我尝试了下,D:\maven\.lemminx-maven这个目录就是LemMinX-Maven产生的。在eclipse中编辑pom.xml文件,增加依赖,.lemminx-maven这个目录就会更新。

其中D:\maven\apache-maven-3.8.8是maven的安装目录,D:\maven\maven-repository是在D:\maven\apache-maven-3.8.8\conf\settings.xml中配置的maven本地仓库:

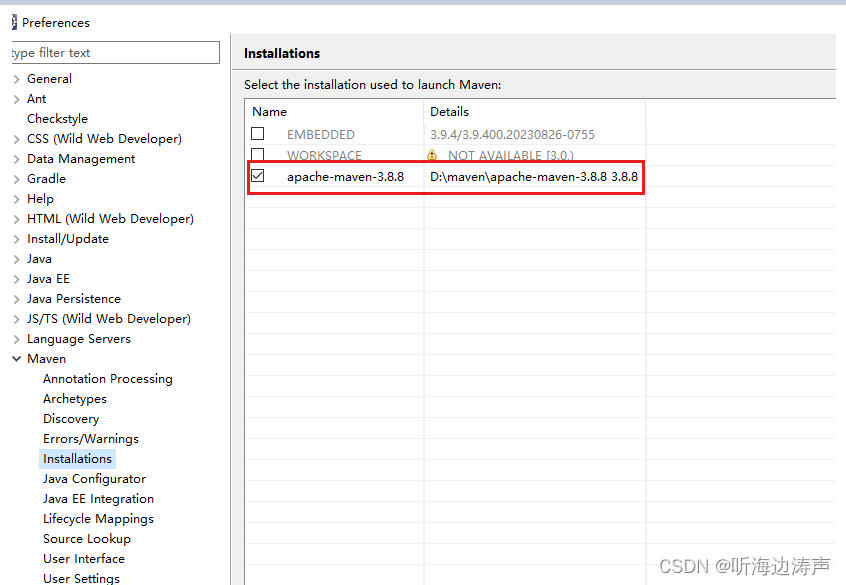

备注:在eclipse中已经配置了maven的安装目录指向D:\maven\apache-maven-3.8.8:

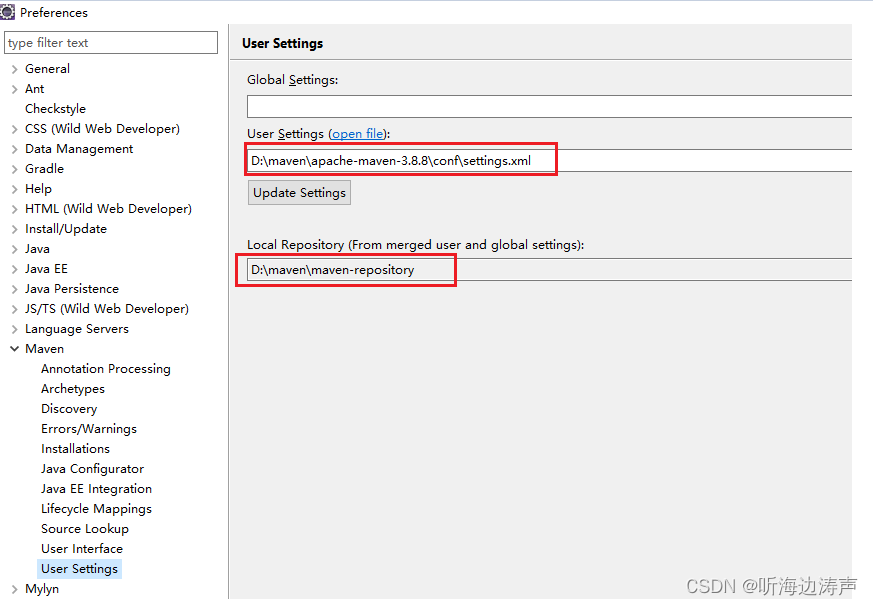

备注:在eclipse中已经配置了User Settings指向D:\maven\apache-maven-3.8.8\conf\settings.xml,配置了maven本地仓库指向D:\maven\maven-repository

疑问:但我找了eclipse的配置,没有看到在哪个地方可以配置.lemminx-maven目录的位置。难道是根据maven的安装目录、maven本地仓库的位置来决定的,而没有提供可供用户配置的配置项?