潍坊网站制作工具哪个网站可以宣传做的蛋糕

本片将介绍 Redis 的安装及简单使用

文章目录

- 1、Redis安装

- 1.1、Windows下Redis的安装

- 1.2、Linux下Redis的安装

- 1.3、Mac下Redis的安装(使用Homebrew)

- 2、Redis使用

- 2.1、启动服务端客户端

- 2.2、Redis简单命令

- 3、Redis命令大全

1、Redis安装

1.1、Windows下Redis的安装

对于 Redis,官方是没有 Windows 版本的。

Windows 版本下载地址:https://github.com/MicrosoftArchive/redis/releases,下载对应版本的 mis 格式安装包:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-3g3gcKn0-1692196336559)(/Users/liziheng/Library/Application Support/typora-user-images/image-20230812223316028.png)]双击刚下载好的 msi 格式的安装包:

-

开始安装

-

选择 “同意协议”,点击下一步继续;

-

选择 “添加Redis目录到环境变量PATH中”,这样方便系统自动识别 Redis 执行文件在哪里;

-

端口号可保持默认的 6379,并选择防火墙例外,从而保证外部可以正常访问 Redis 服务;

-

设定最大值为 100M。作为实验和学习,100M 足够了

接下来,右击 “计算机” > 选择 “管理”。在左侧栏中依次找到并点击 “计算机管理(本地)” > 服务和应用程序 > 服务。再在右侧找到 Redis 名称的服务,查看启动情况。如未启动,则手动启动之。正常情况下,服务应该正常启动并运行了

最后来测试一下 Redis 是否正常提供服务。进入 Redis 的目录使用 cmd。输入 redis-cli 并回车。(redis-cli 是客户端程序)如图正常提示进入,并显示正确端口号,则表示服务已经启动:

实际测试一下读写。输入并回车:

set mykey1 "I love you all!"

再输入以下命令,获取刚才保存的键值

get mykey1

1.2、Linux下Redis的安装

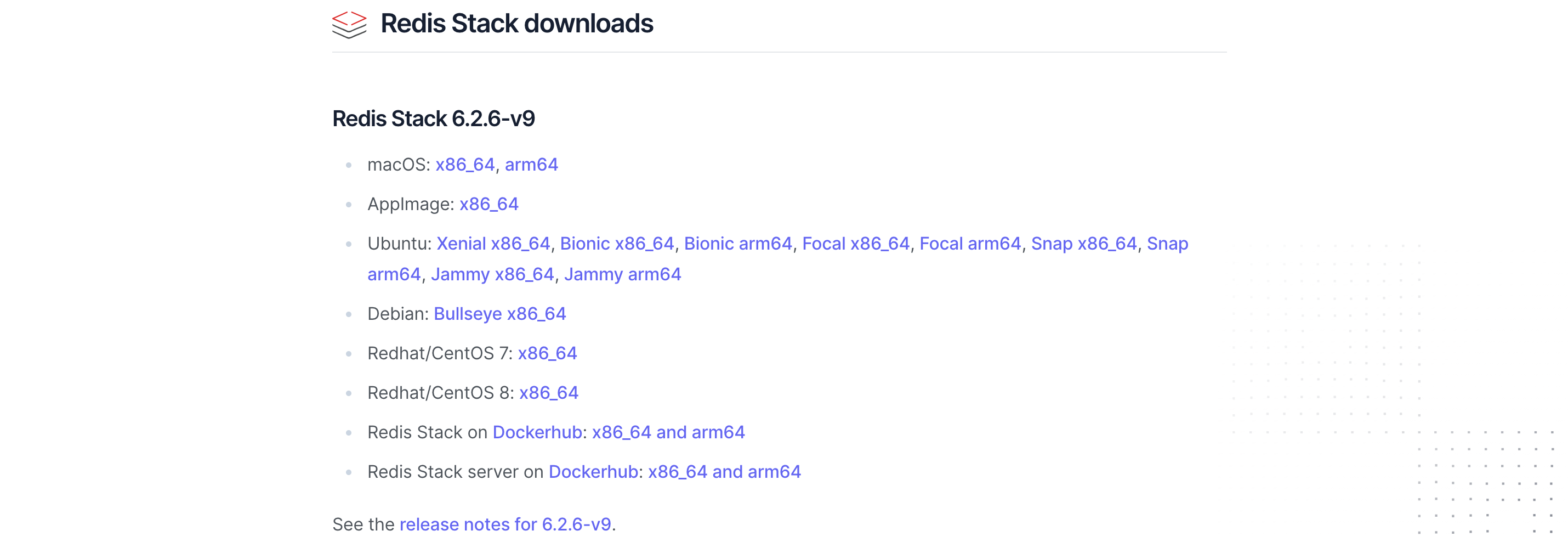

Redis官网下载地址:https://redis.io/download/#redis-stack-downloads

直接点击对应版本下载得到对应的 redis-6.2.6.tar.gz 文件

接下俩,开始 Linux 下 Redis 的安装:

-

把 redis-6.2.6.tar.gz 移动到 /usr/local/ 目录下:

mv redis-6.2.6.tar.gz /usr/local/ -

解压 redis-6.2.6.tar.gz:

tar -zxvf redis-6.2.6.tar.gz -

由于 Redis 是由 C 语言编写的,它的运行需要 C 环境,因此我们需要先安装 gcc:

yum install gcc-c++ -

进入到 /usr/local/redis-6.2.4/ 目录下,进行编译与安装 :

cd redis-6.2.4 make cd ./src make install -

Redis 不是默认后台启动的,需要求改一下配置文件 redis.conf 将 daemonize 属性改为 yes

-

编辑 redis.conf 配置文件,开启 Redis 远程访问服务:

bind 127.0.0.1 这一行给注释掉,这里的bind指的是只有指定的网段才能远程访问这个 Redis,注释掉后,就没有这个限制了 protected-mode no 默认是设置成 yes 的, 防止了远程访问,在 Redis3.2.3 版本后 -

启动 Redis 服务:

redis-server redis.conf -

启动 Redis 客户端服务:

redis-cli -p 6379

1.3、Mac下Redis的安装(使用Homebrew)

没有安装 Homebrew,首先安装 npm 国内的,快一些:

/bin/zsh -c "$(curl -fsSL https://gitee.com/cunkai/HomebrewCN/raw/master/Homebrew.sh)

使用Homebrew安装命令:

brew install redis

查看安装及配置文件位置:

- Homebrew 安装的软件会默认在 /usr/local/Cellar/ 路径下

- Redis 的配置文件 redis.conf 存放在 /usr/local/etc 路径下

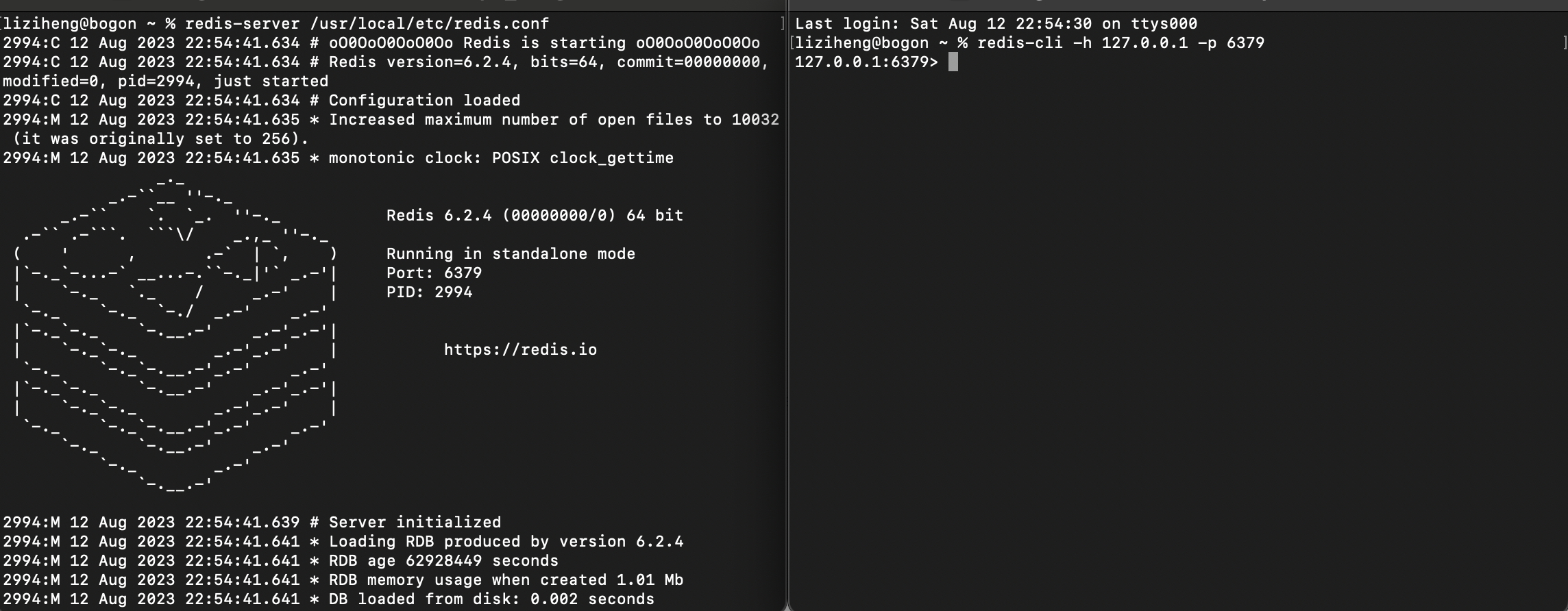

启动 Redis 服务:

redis-server /usr/local/etc/redis.conf

或

brew services start redis

或

redis-server

查看 Redis 服务进程:

ps axu | grep redis

redis-cli 连接 Redis 服务,Redis 默认端口号 6379,默认 auth 为空:

redis-cli -h 127.0.0.1 -p 6379

2、Redis使用

2.1、启动服务端客户端

紧接上文,我们完成 Redis 安装后,进行一些 Redis 的简单使用,完成一些相关操作,来加深对 Redis 的理解。

我们以 Mac 版本进行使用,首先,启动 Redis 的服务端与客户端:

服务端:

redis-server /usr/local/etc/redis.conf

客户端(新建终端页):

redis-cli -h 127.0.0.1 -p 6379

2.2、Redis简单命令

Redis Ping 命令使用客户端向 Redis 服务器发送一个 “PING” ,如果服务器运作正常的话,会返回一个 “PONG” 。

通常用于测试与服务器的连接是否仍然生效,或者用于测量延迟值:

Redis Select 命令用于切换到指定的数据库,数据库索引号 index 用数字值指定,以 0 作为起始索引值。

选择第 6 个数据库:

Redis SET 命令用于设置给定 key 的值。如果 key 已经存储其他值, SET 就覆写旧值,且无视类型。

以 a 为键存一个值 15:

Redis Get 命令用于获取指定 key 的值。如果 key 不存在,返回 nil 。如果key 储存的值不是字符串类型,返回一个错误。

获取 a 的值:

Redis Keys 命令用于查找所有符合给定模式 pattern 的 key

查看该库中的全部键:

Redis Flushdb 命令用于清空当前数据库中的所有 key。

Redis Flushall 命令用于清空整个 Redis 服务器的数据(删除所有数据库的所有 key)

清空全部数据库:

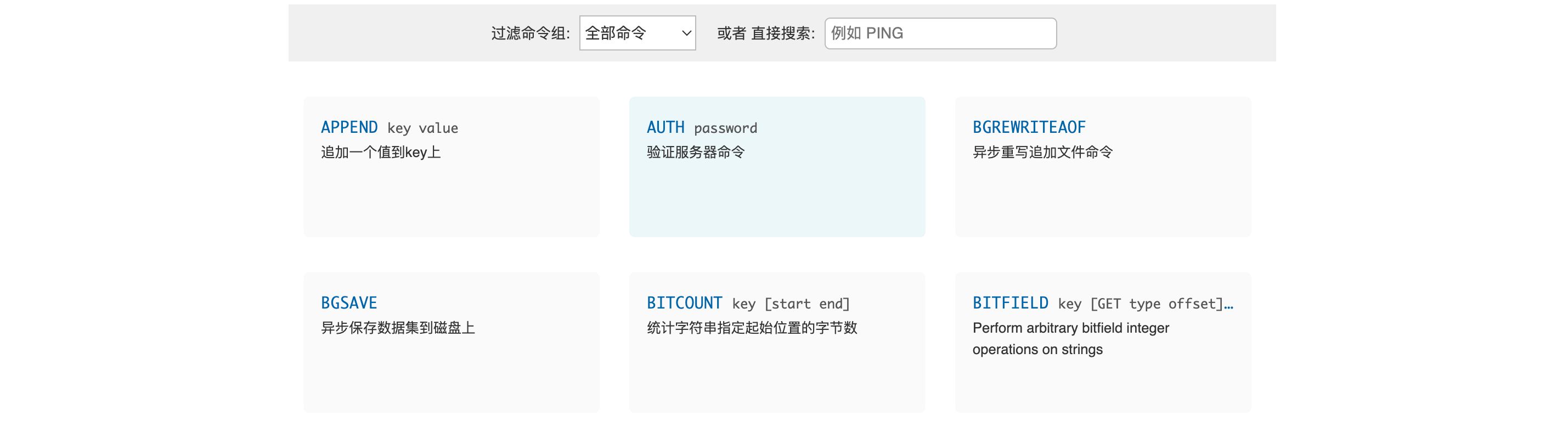

3、Redis命令大全

Redis 命令十分丰富,包括的命令组有 Cluster、Connection、Geo、Hashes、HyperLogLog、Keys、Lists、Pub/Sub、Scripting、Server、Sets、Sorted Sets、Strings、Transactions 一共14个 Redis 命令组两百多个 Redis 命令,Redis 中文命令大全。我们可以通过下面页面的检索功能快速查找命令:http://www.redis.cn/commands.html