做普通网站多少钱星月教你做网站

文章目录

- int main()与int main(void)

- 符号常量

- 常变量

- 无符号

- 赋值

- 将占字节多的赋值给字节少的类型

- 赋初值

- 表达式

- 预处理

- 格式符

- e格式符

- 循环

- for

- 输入

- 长度相关

- 输出

- 文件管理

int main()与int main(void)

- int main(void) 指的是此函数的参数为空,不能传入参数,如果你传入参数,就会出错。

- int main() 表示可以传入参数。

符号常量

#define(预编译指令) P 3.14 是字符常量,它不占内存(不分配存储单元),只是一个临时符号,代表一个值,在预编译后就不存在了,所以不能对P 修改,符号常量一般用大写

常变量

const 某些没有实现C99的功能的编译器是不能使用的。

无符号

如果带有unsigned的整形,那么转换为二进制时,他的符号位会取消掉,数值位便会占据符号位。

赋值

将占字节多的赋值给字节少的类型

将二进制的低字节的数原封不动的送到被赋值的变量中,若赋值后的符号为1就求它的的原码(减一再取反再加负号)就会得到准确值。,在超过存储空间部分的数字会直接消失。

赋初值

- 除了静态存储变量和外部变量(函数外的)的初始化是在编译阶段完成的,其他的实在程序运行时执行该函数时赋予初始值的。

- 如果变量没有赋初值,那么输出时编译器会自动给这些没有赋值的变量赋值。

表达式

赋值表达式也是表达式,所以可以包含在其他表达式中。

预处理

#include <stdio.h>也可以 #include “stdio.h” 他们的差别是:#include<stdio.h>是编译时,编译系统从编译系统中去找头文件(标准方式),而#include "stdio.h"是编译时,现在当前目录(源程序目录)找,若没有再去编译系统中找(适合调用用户自己提供的头文件)。

格式符

输出%号,要在格式字符串中写%%。

e格式符

许多编译器是数字部分的小数部分站6列,指数部分占5列(其实e占一列,符号一列,数字三列)

如 1.234e+003.

循环

for

三个表达式都可以省略。

输入

scanf()会拒收回车,所以在在缓存区数据有回车的一定要把缓存去的回车吸收掉。

长度相关

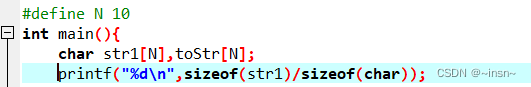

sizeof(不是函数)计算的是开辟整个空间的大小,包括‘\0’,可以计算任何类型

例如:这儿输出的是10,是整个数据的长度而不是字符个数

strlen()(是函数)计算的就是字符长度,不包括’\0’,只能计算字符类型

输出

用printf()时输出的格式一定要和变量一致,否则会输不出来值(整形和字符型除外);

文件管理

用读入和输出函数时,与打开的文件形式要对应,否则不好发现错误

。