武侯区旅游网站建设互联网登录的网站名

1. git日志显示

# 显示前3条日志

git log -3# 单行显示

git log --oneline# 图表日志

git log --graph# 显示更改摘要

git log --stat# 显示更改位置

git log --patch 或 git log -p# 查看指定文件的提交历史记录

git log {filename}

例子1:单行显示

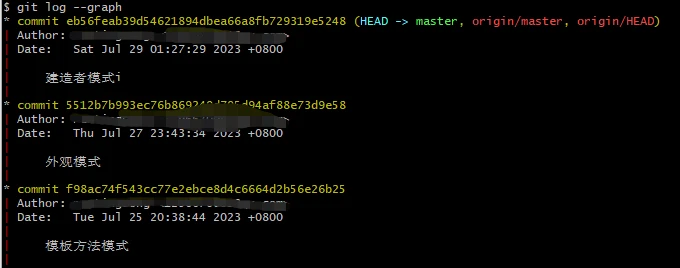

例子2:图标日志

例子3:显示更改摘要

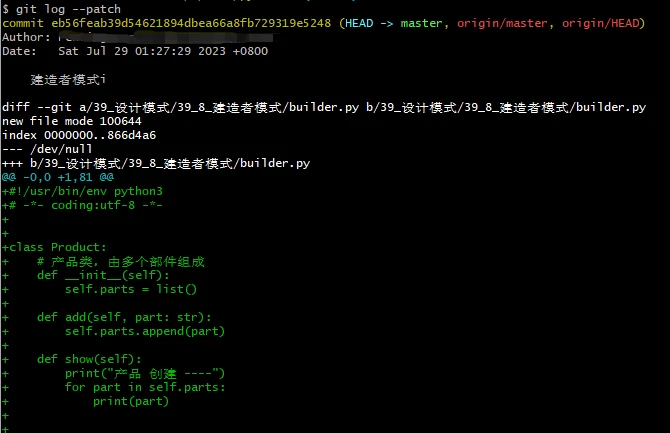

例子4:显示修改的地方

2. git日志筛选

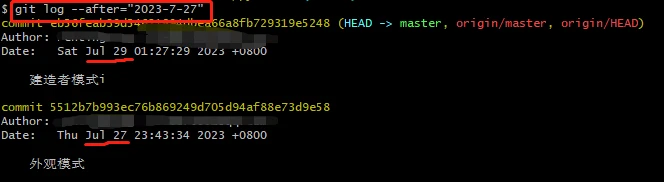

2.1 根据时间筛选

参数–after, --beofre。

git log --after="2023-07-27"

git log --before="2023-07-29"

git log --before="2023-07-29 12:00:00" --after="2023-07-27 12:00:00"

git log --before="today"

git log --after="yesterday"

git log --after="30 day age"

git log --after="1 week ago"

git log --after="1 month ago"

例子1:筛选出2023-07-27之后的提交记录,使用–after参数指定。

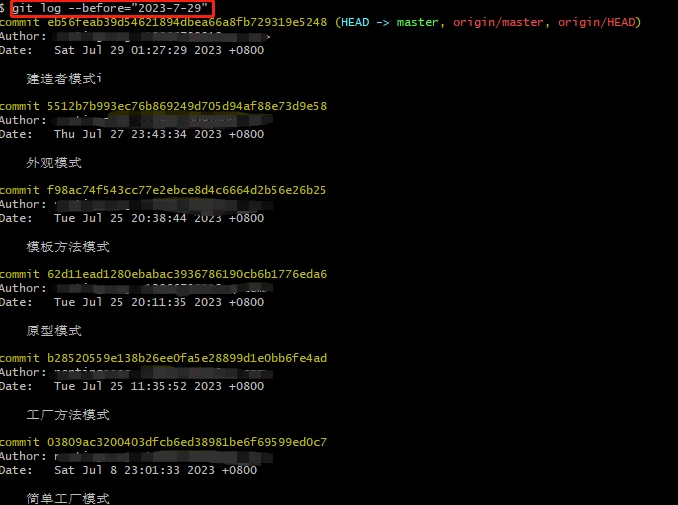

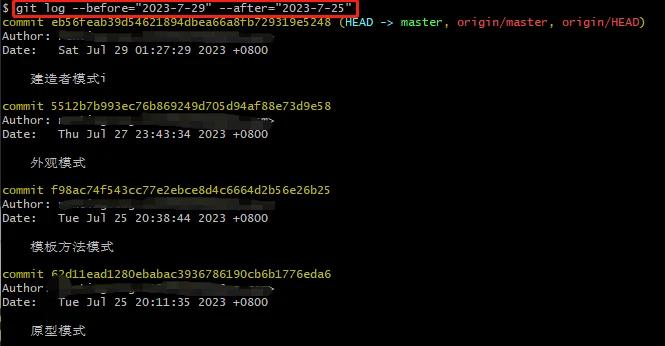

例子2:筛选出2023-07-29之前的提交记录,使用–before参数指定。

例子3:筛选出2023-07-27 ~ 2023-07-29之间的提交记录。

2.2 按作者进行筛选

匹配的时候是不完全匹配。

git log --author="@qq.con"

git log --author="ting"

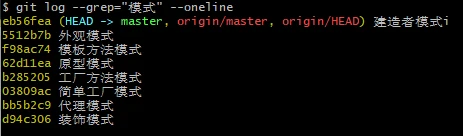

2.3 按提交信息进行筛选

git log --grep="模式"

例子1:搜索提交信息中包含"模式"的记录

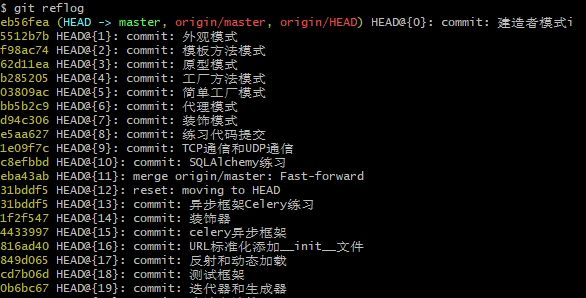

3. 引用日志

提交之后,上面这些普通日志会成为版本库中的一部分,历史记录会一直保存起来。

引用日志只保存在本地,不会跟着版本库迁移,它记录了HEAD节点和分支引用所指向的历史。简明地说:reflog记录所有的更改,当项目损坏时,只要提交过,给了挽回的机会。

它只保存在本地仓库,不能push,且默认只保留90天。

引用日志要比普通日志更详细。

引用日志查看:

git reflog