网站建设系统规划上海网站建设公司网站

前言:

- 写这个的目的是因为本人健忘所以做个记录以便日后再折腾时查阅,。

- 本人笔拙如有选词,错字,语法,标点错误请忽视,大概率知道了也不会修改,本人能看懂就好。

- 内容仅适用于本人的使用环境,不同环境请忽视或仅作参考。

- 文中出现的内容来自网络和本人浅薄的认知,如果万一有侵犯他人内容请私信。

- 纯自己瞎记录, 虽然没啥可能性如果万一以千万分之一的概率得到赏识被转载的话还请注明作者和出处

环境:

- 软路由 4个2.5G网口 (N5105板子+Intel E1G42ET 4口2.5G千兆网卡)

- 演示版本 Proxmox VE(PVE) 7.3

内容:

- 安装&简单配置PVE(Porxmox VE)

1. PVE(Proxmox VE) 下载地址

https://www.proxmox.com/en/downloads

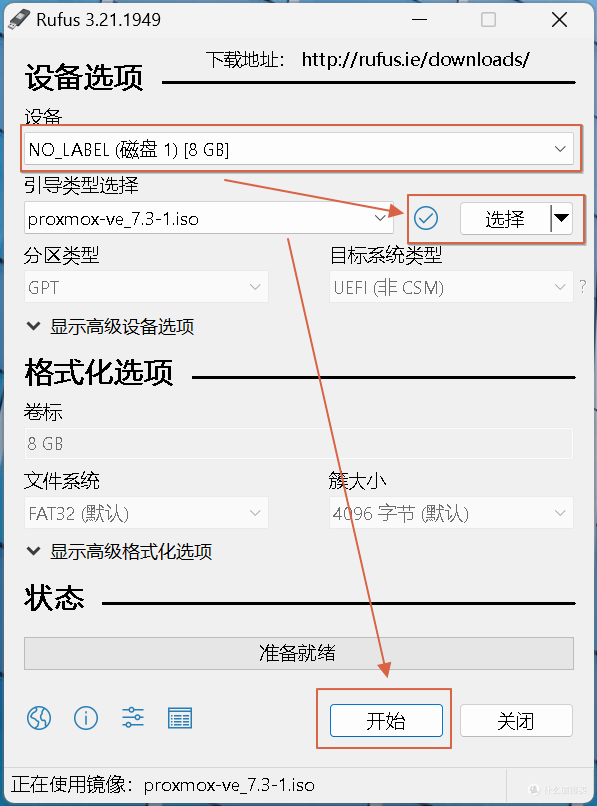

2. 制作安装U盘

找个U盘制作PVE安装U盘 制作工具很多自行选择,这里用Rufus,方法如下

3. 安装PVE系统

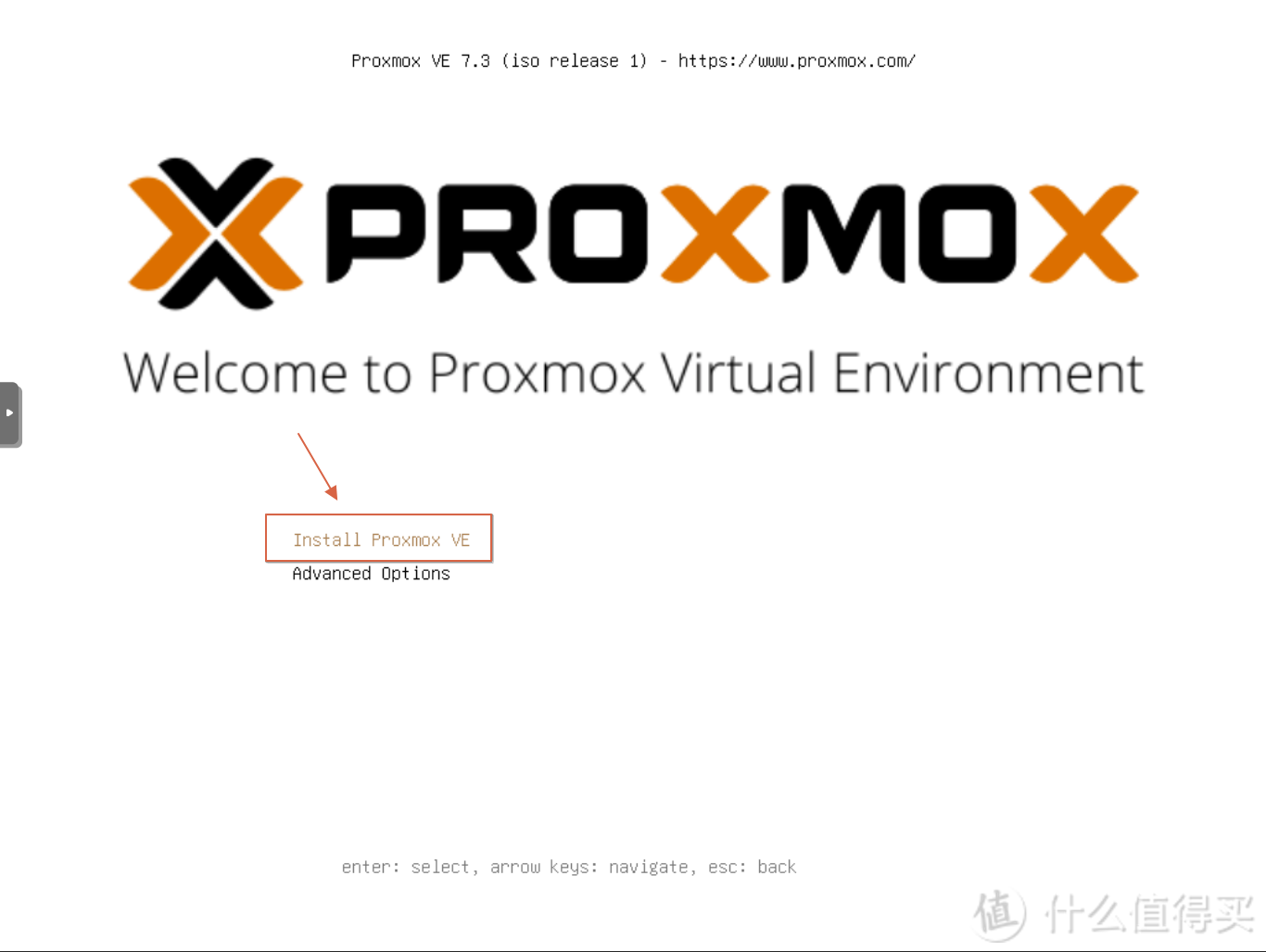

制作好的U盘插到电脑U盘启动进行安装

键盘方向键移动到Install Proxmox VE进行安装

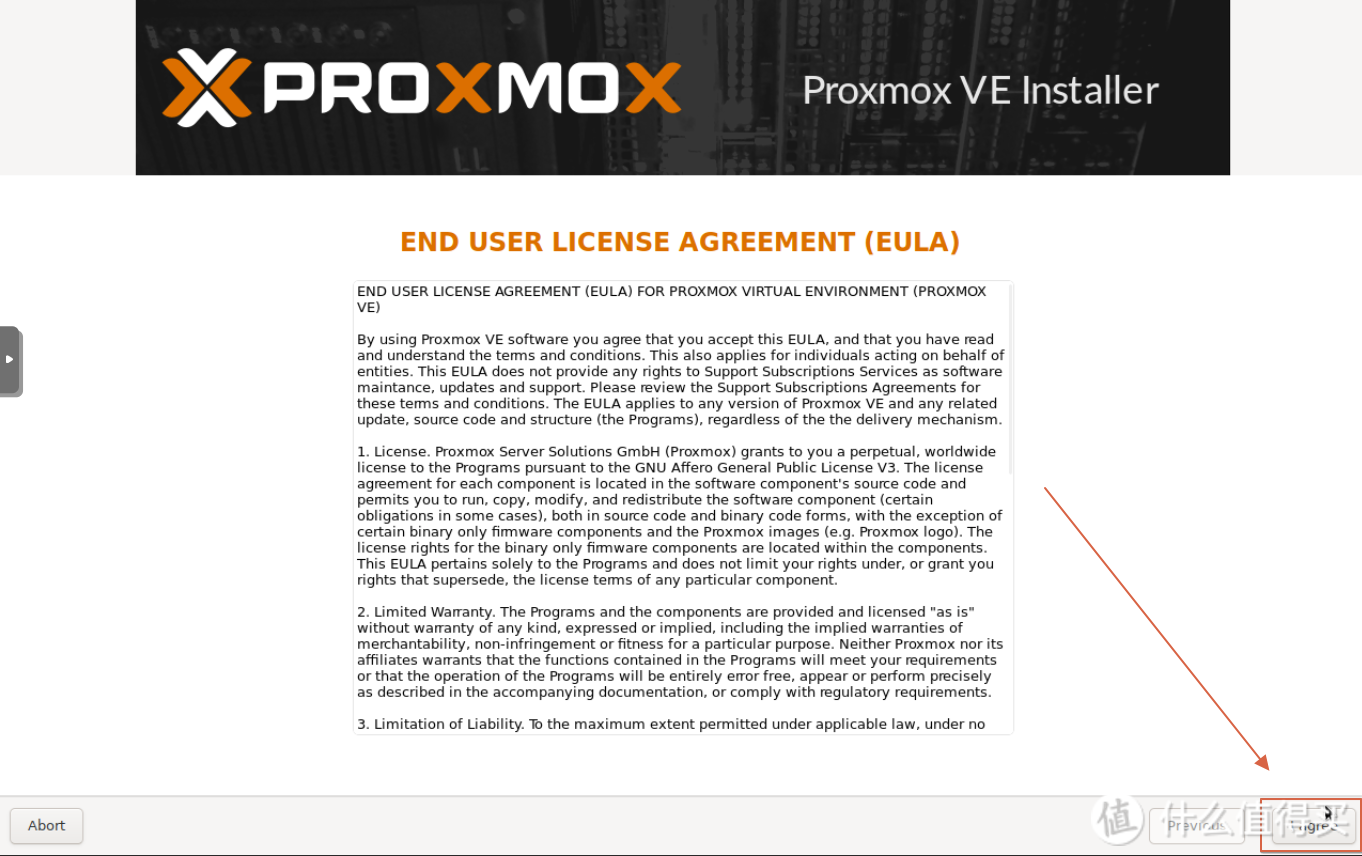

点击同意

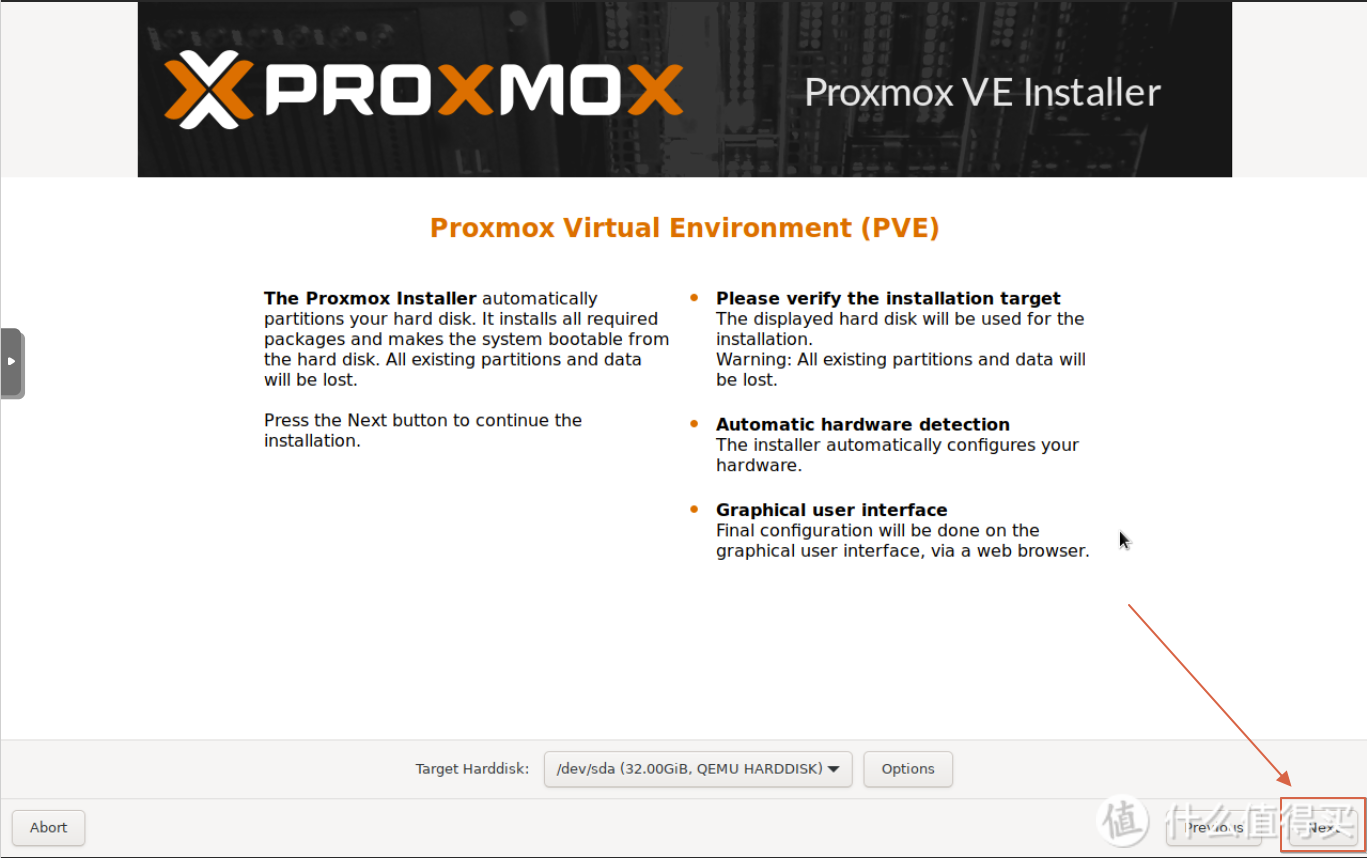

选择安装硬盘,下一步

默认或者按需,下一步

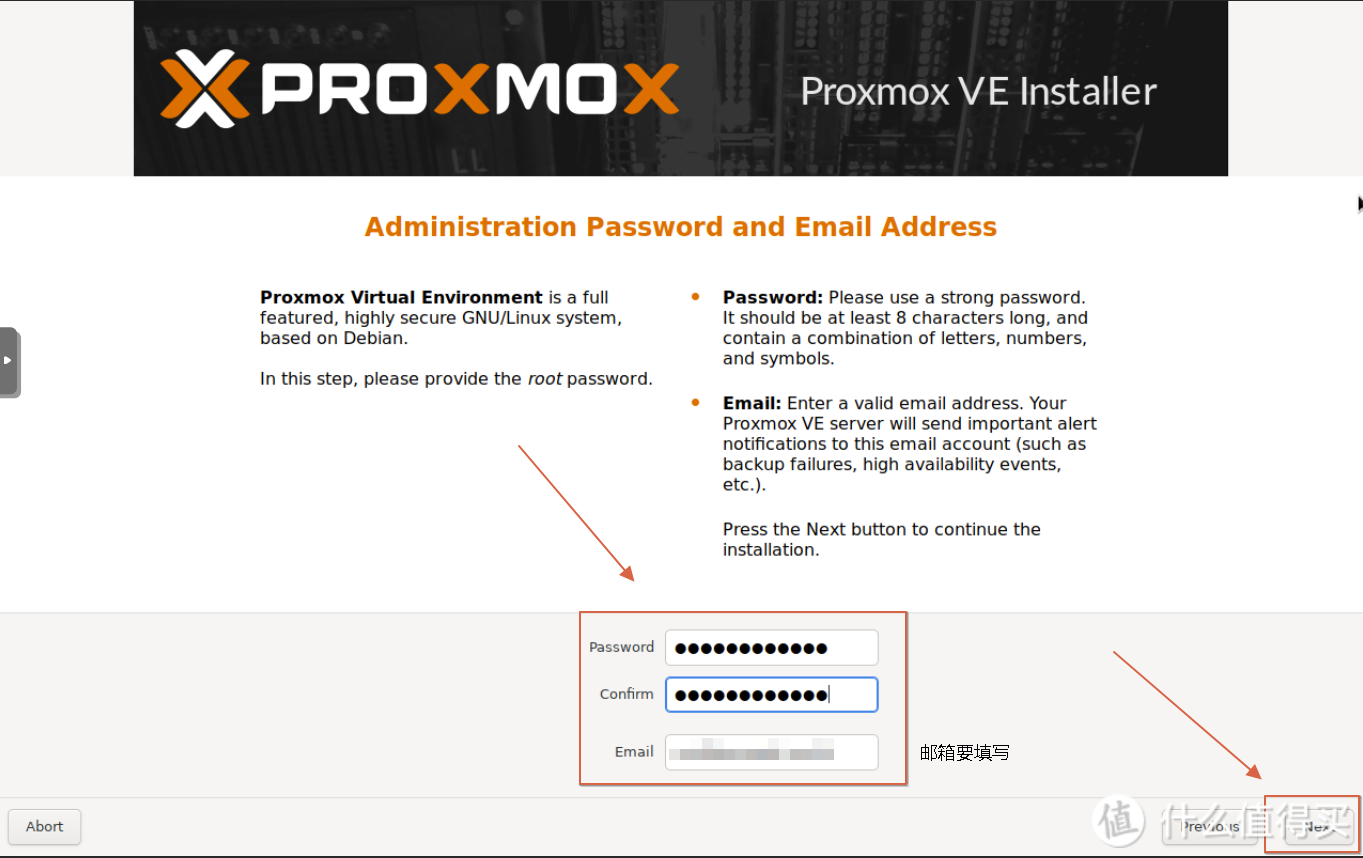

设置密码,邮件要写,下一步

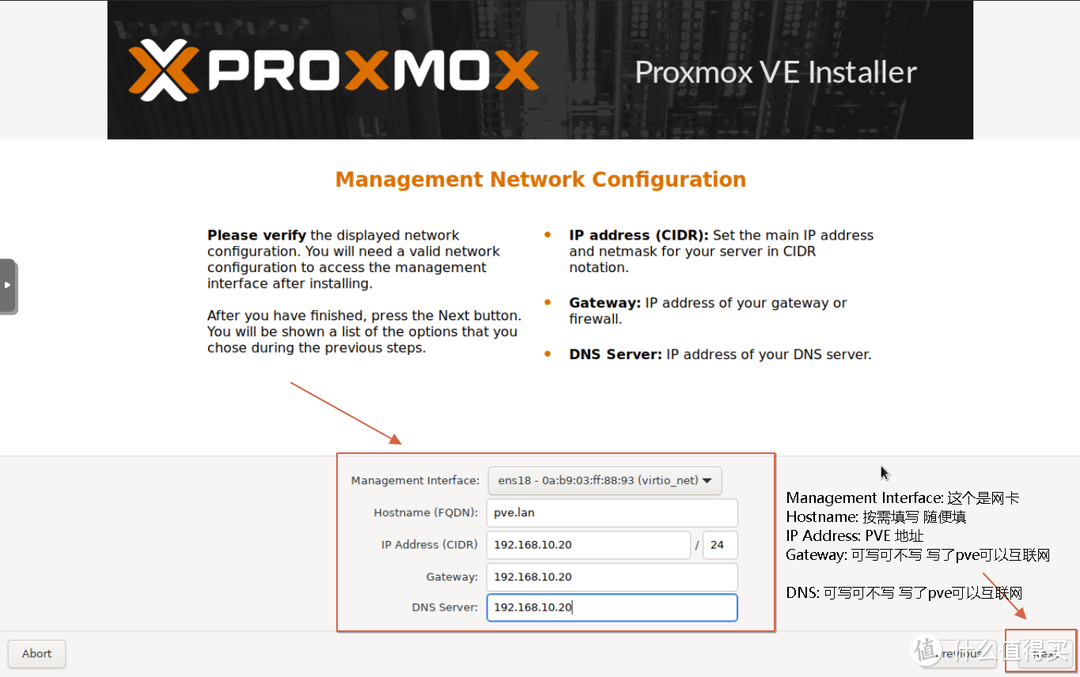

按需设置,这里的设置的IP就是登录PVE要使用到的IP,下一步

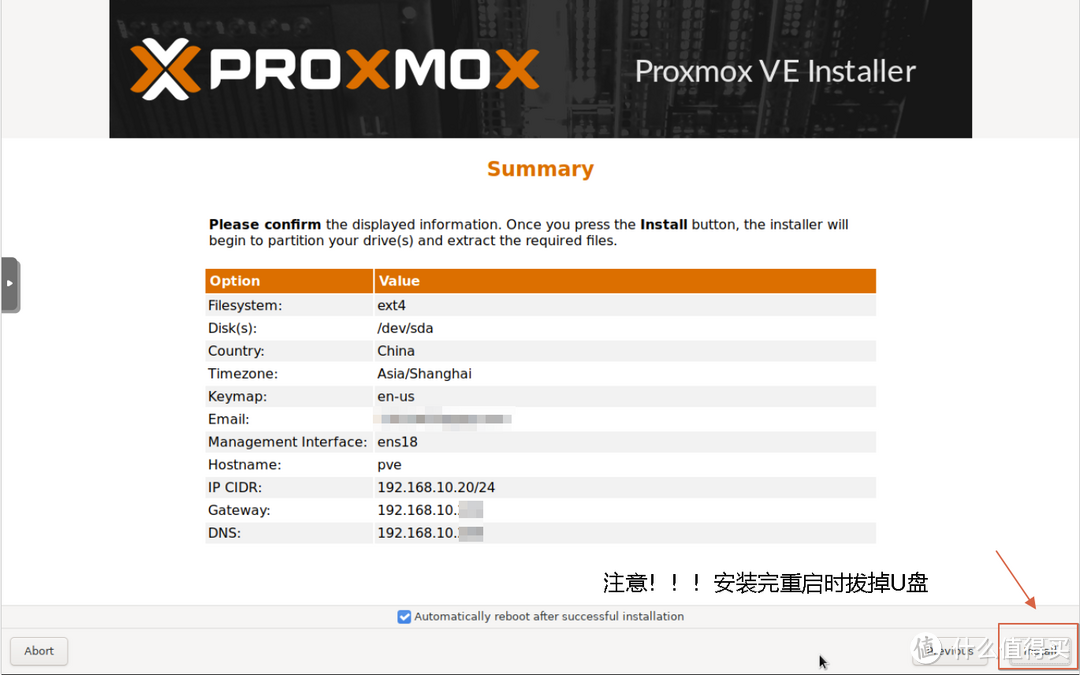

点Install 进行安装

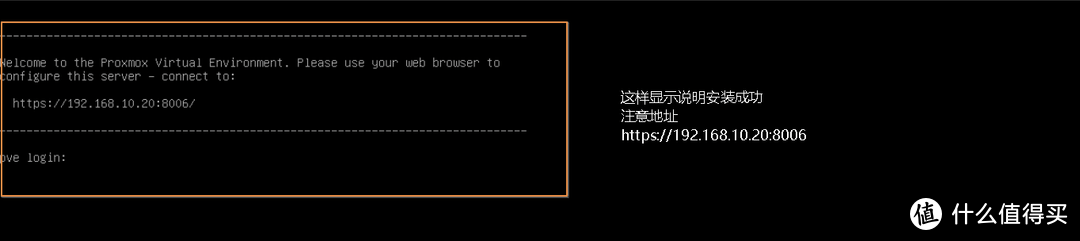

出现这个画面说明安装成功,记住链接

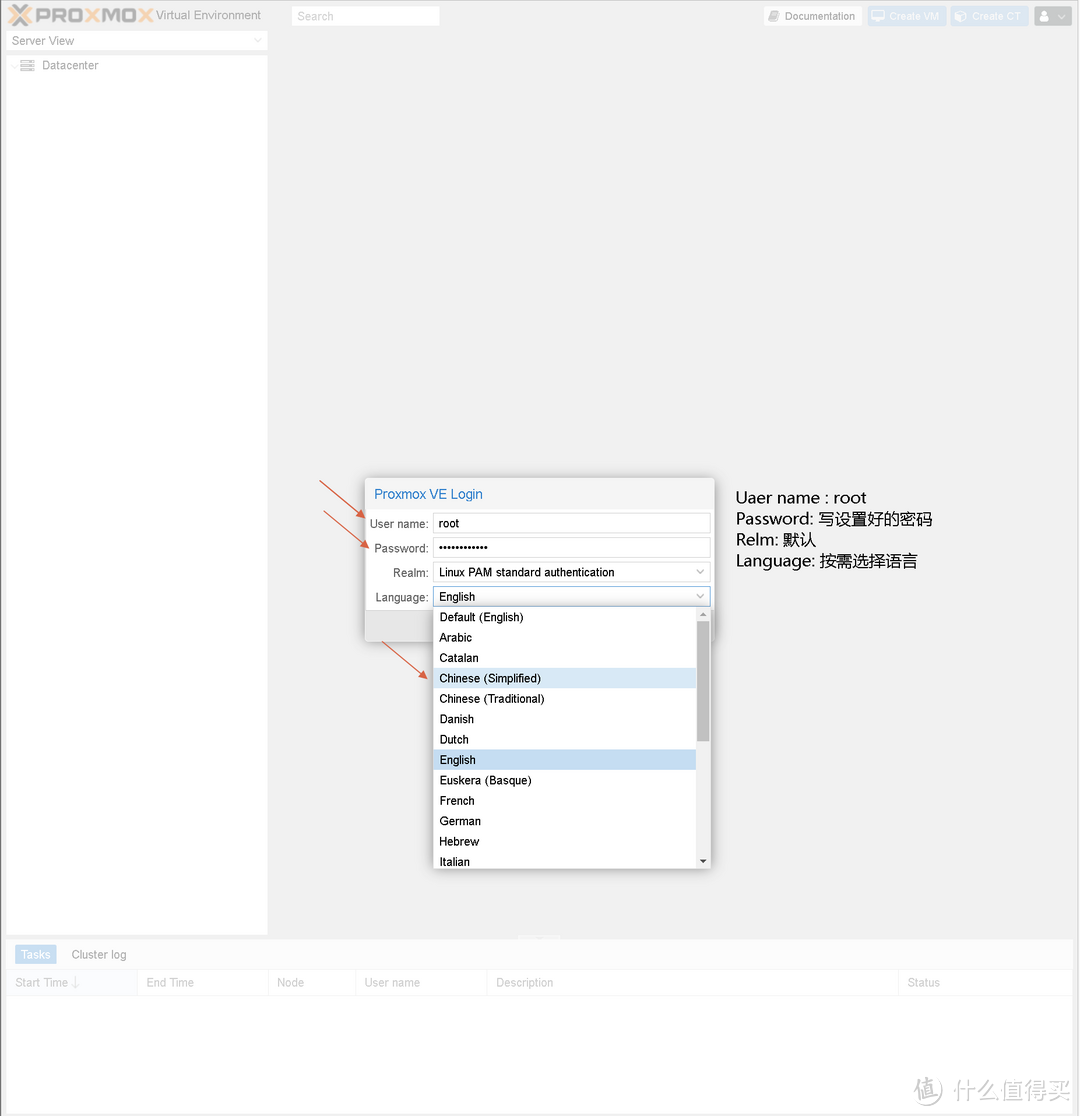

4. 登陆PVE界面

https://192.169.10.xx:8006 # 注意! 地址前面一定要加 https

输入链接出现如上画面,点击高级,点击链接进入PVE web画面

输入用户名: root,密码, 语言选择能看懂的,登录

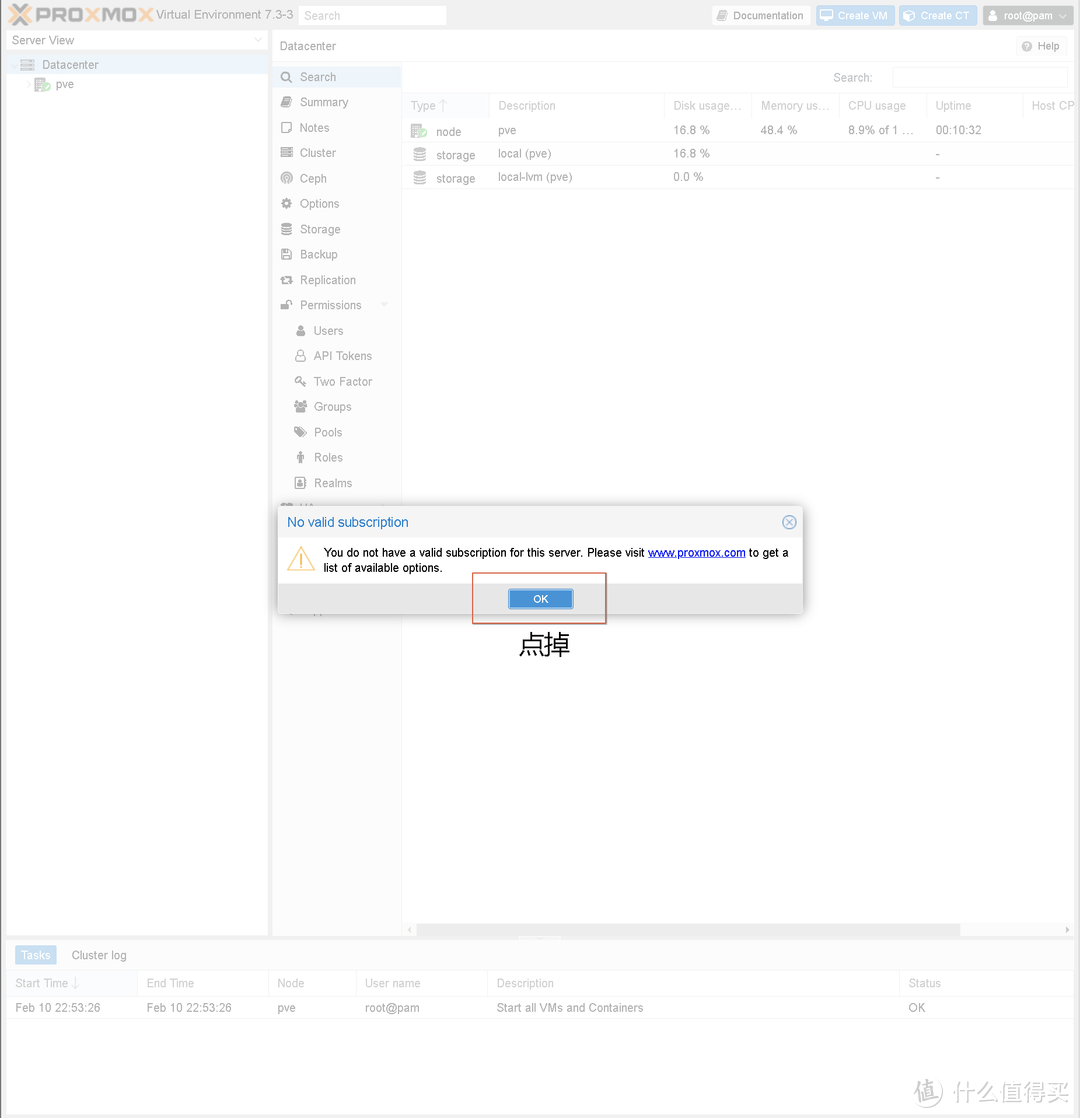

点掉

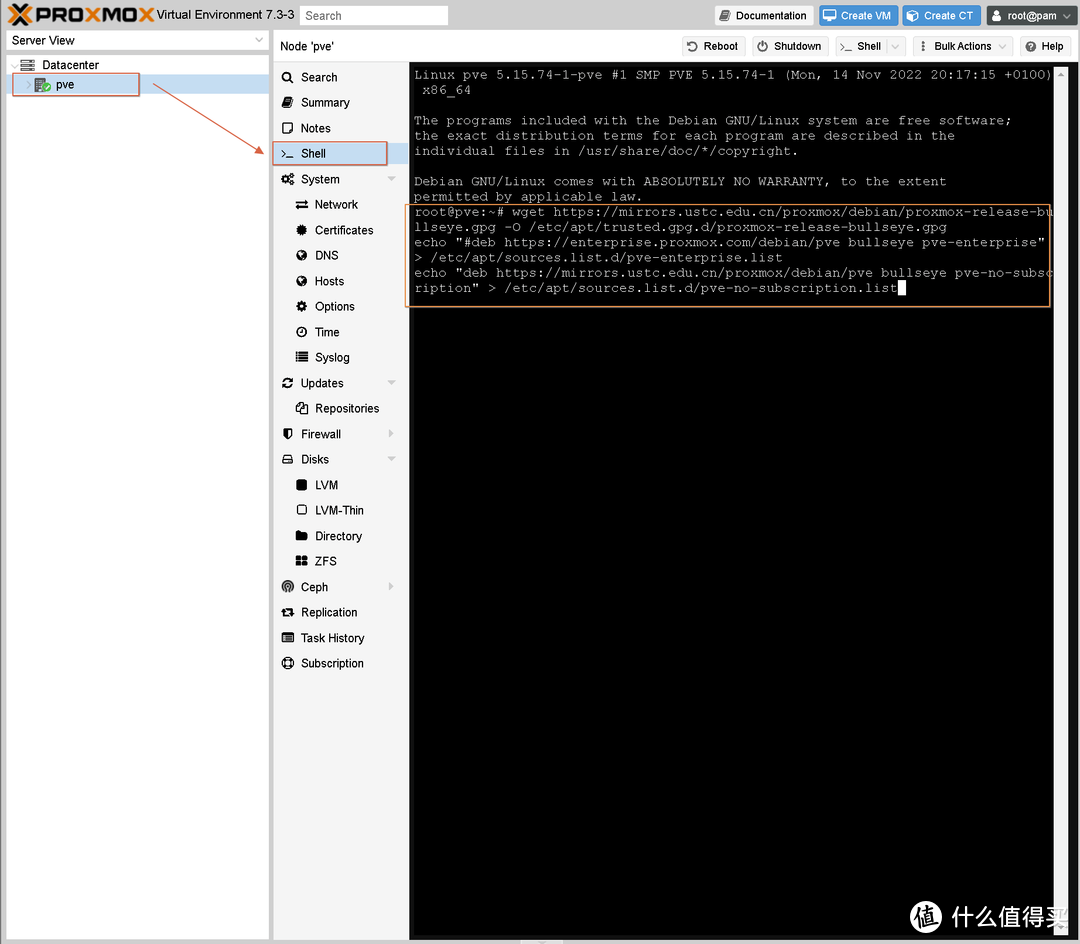

5. 更换国内源:

如下图进入Shell画面

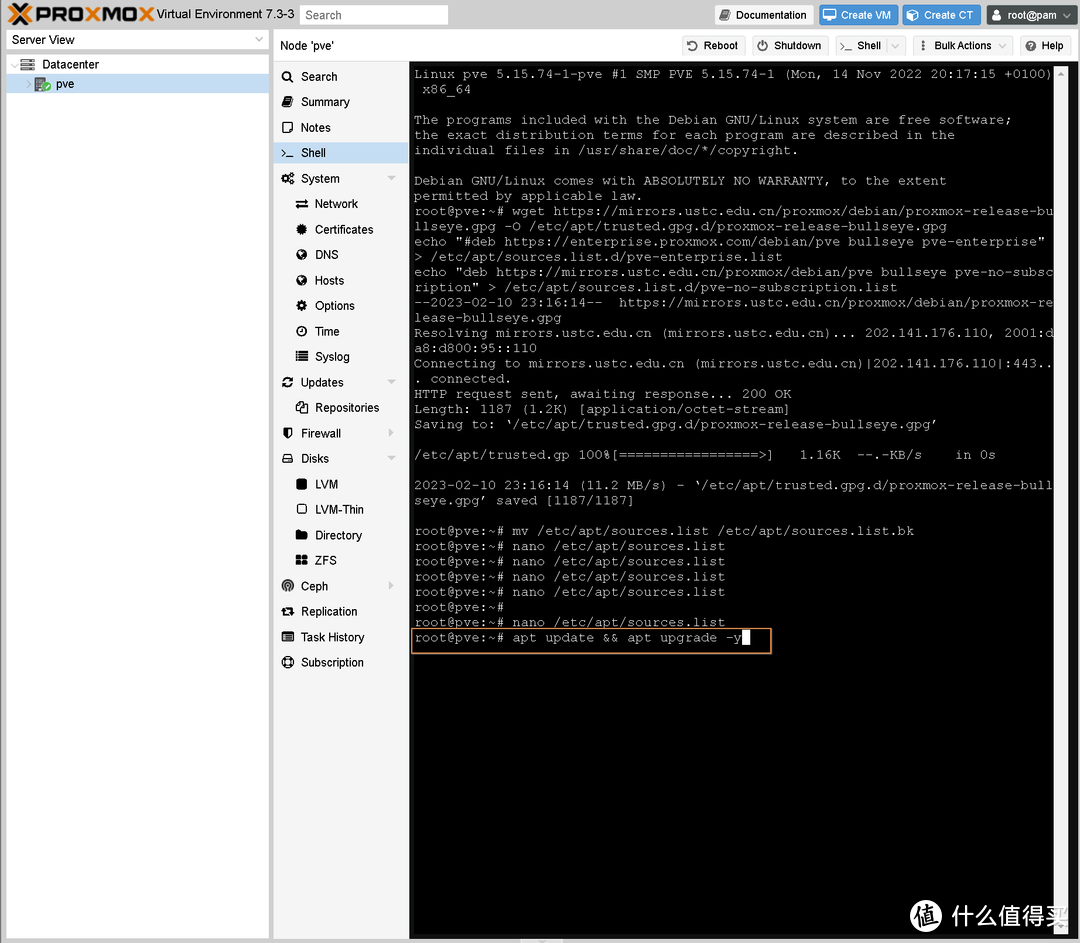

PVE换源: 下面三行命令全部复制粘贴到Shell里然后回车执行 (注意删掉下面命令https中的*,总共3个 不知道为什么加上去后不能发布文章)

wget ht*tps://mirrors.ustc.edu.cn/proxmox/debian/proxmox-release-bullseye.gpg -O /etc/apt/trusted.gpg.d/proxmox-release-bullseye.gpg

echo "#deb ht*tps://enterprise.proxmox.com/debian/pve bullseye pve-enterprise" > /etc/apt/sources.list.d/pve-enterprise.list

echo "deb ht*tps://mirrors.ustc.edu.cn/proxmox/debian/pve bullseye pve-no-subscription" > /etc/apt/sources.list.d/pve-no-subscription.list

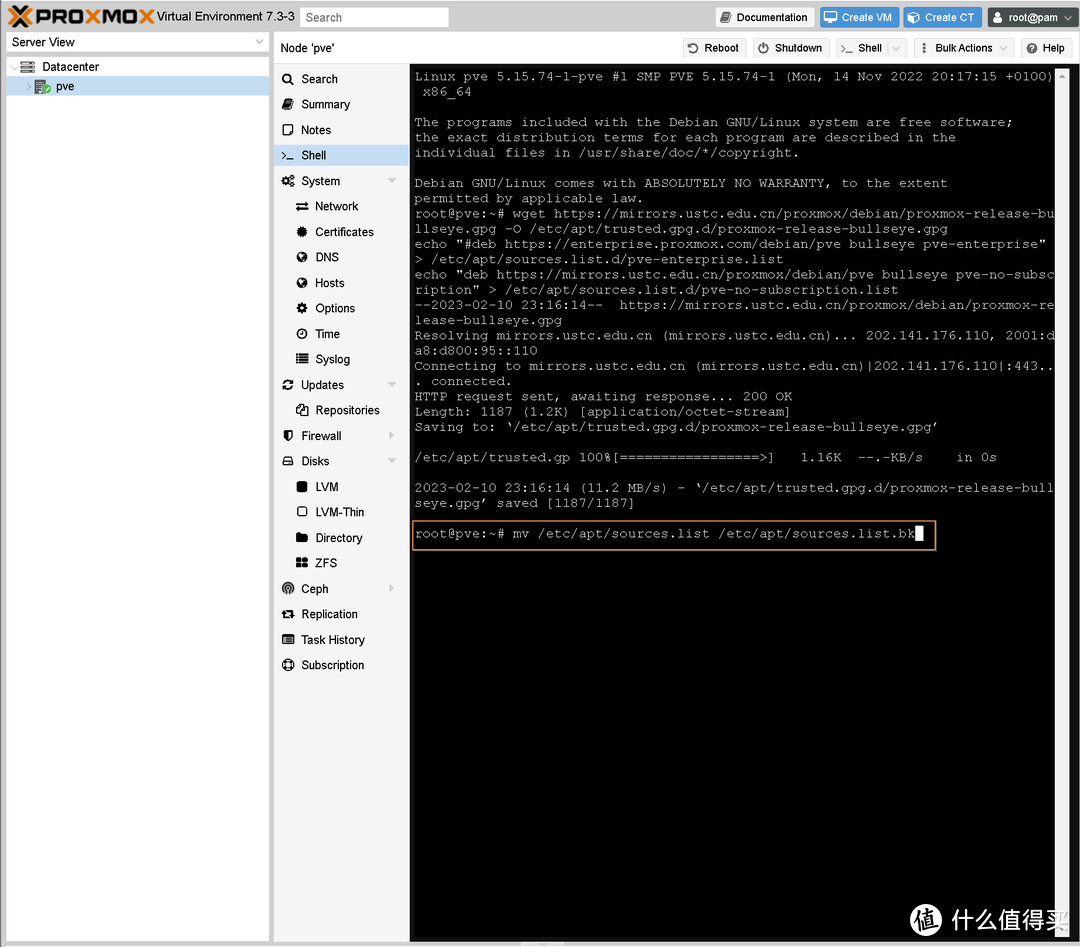

Debian换源

Shell里输入下面命令备份sources.list

mv /etc/apt/sources.list /etc/apt/sources.list.bk

输入 nano /etc/apt/sources.list 打开nano编辑器编辑sources.list

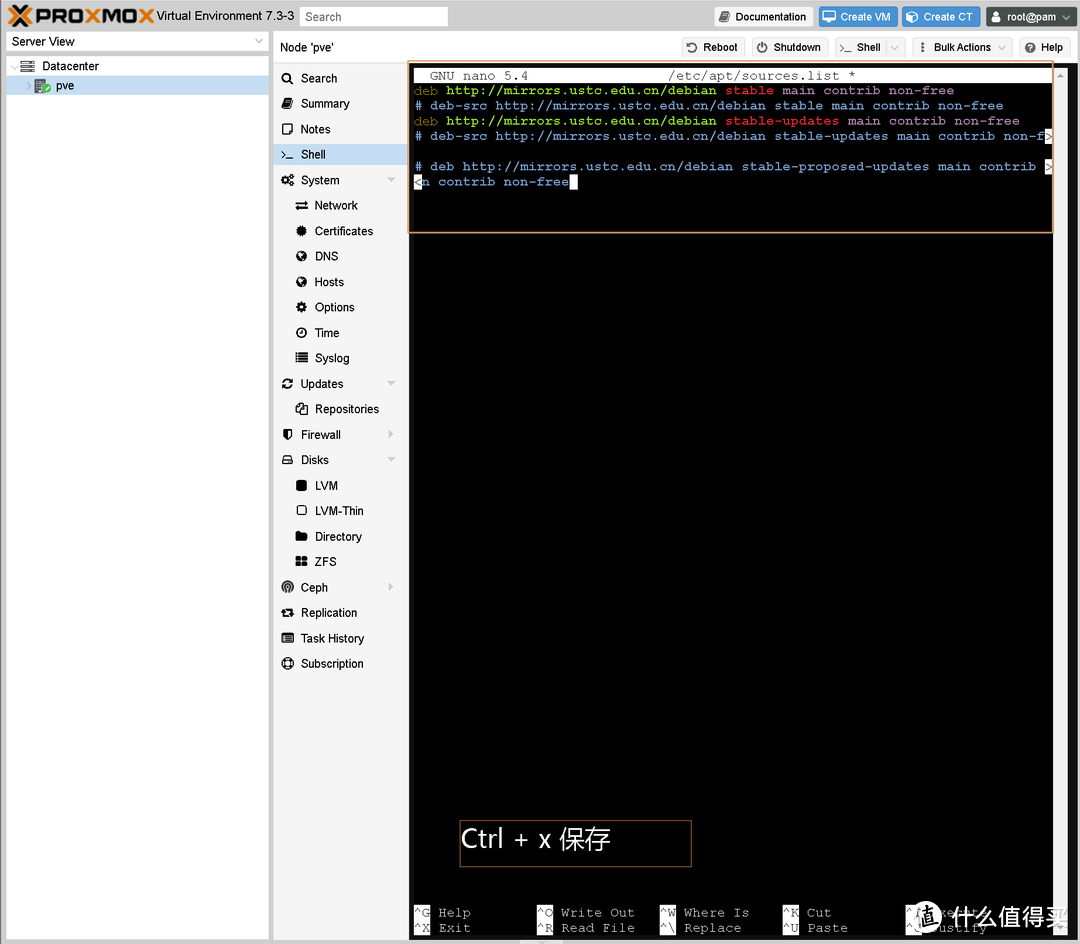

在打开的nano编辑器后粘贴以下内容(复制粘贴,如上图)

deb http://mirrors.ustc.edu.cn/debian stable main contrib non-free

# deb-src http://mirrors.ustc.edu.cn/debian stable main contrib non-free

deb http://mirrors.ustc.edu.cn/debian stable-updates main contrib non-free

# deb-src http://mirrors.ustc.edu.cn/debian stable-updates main contrib non-free

# deb http://mirrors.ustc.edu.cn/debian stable-proposed-updates main contrib non-free

# deb-src http://mirrors.ustc.edu.cn/debian stable-proposed-updates main contrib non-free

用nano 编辑器 编辑完sources.list后后 Ctrl + x ->Y ->回车保存退出

输入 apt update && apt upgrade -y 更新

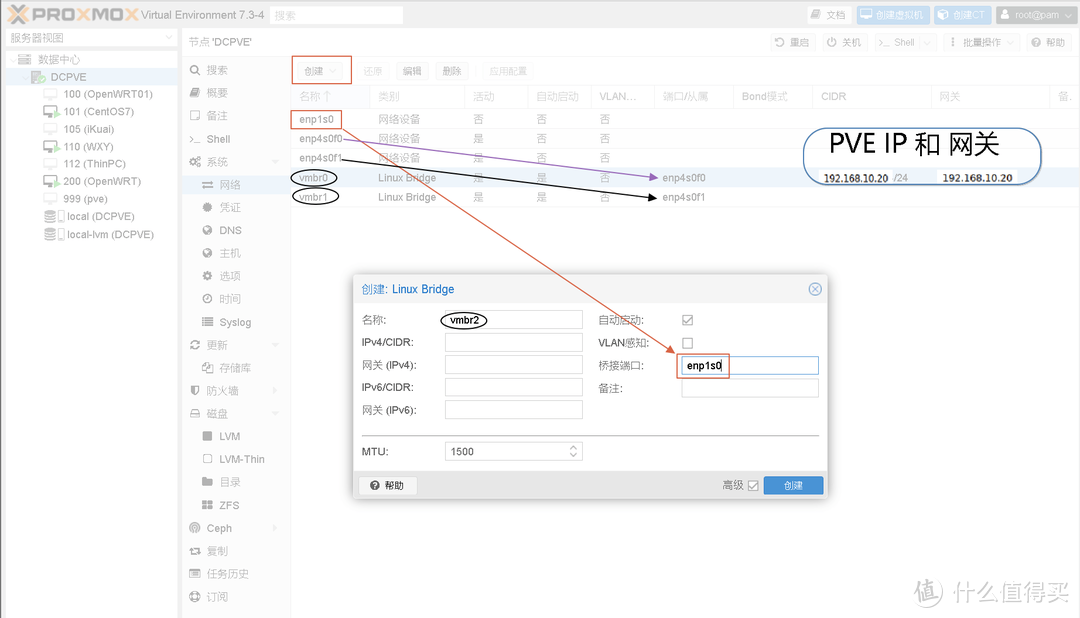

参考上图设置网卡,我这个是3个口 ,注意桥接端口,注意对应关系。

vmbr0的IP是安装时设置的IP,即访问web管理画面登录所使用的IP

7. 建议:

上述设置完后PVE就能使用了,不熟悉的情况下不建议乱修改设置,稳定最重要!

文末

内容都是简单的内容仅写到能无障碍的使用为止,应该更适合大部分刚入坑的伙伴们,照着做就可以,更多功能自行琢磨。

#Proxmox VE

#PVE