做网站收益小制作灯笼简单又漂亮

下面是部分BUAA网络安全实验✅的实验内容 :

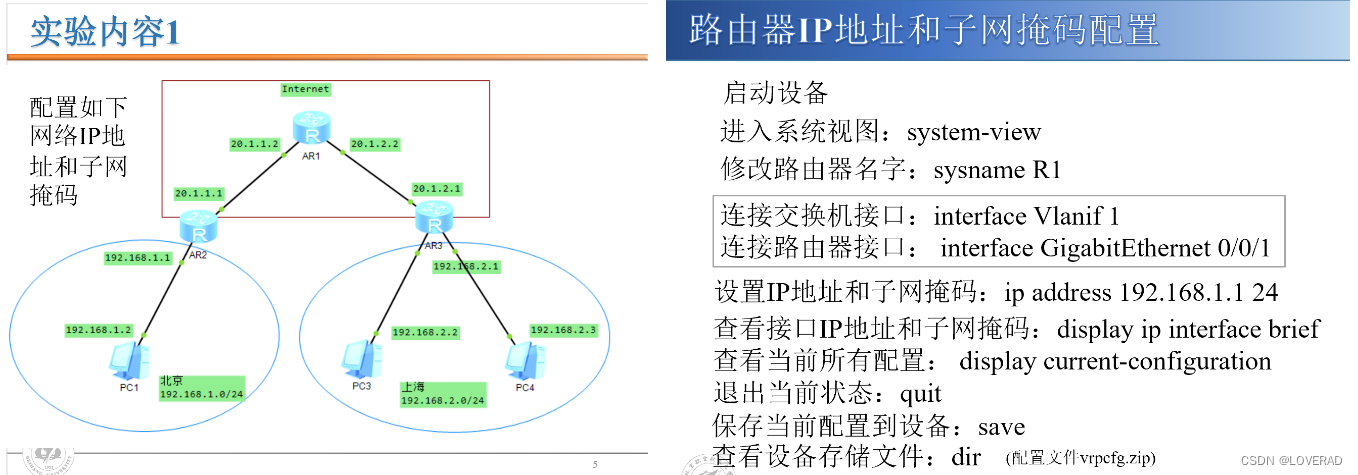

- 认识路由器、交换机。

- 掌握路由器配置的基本指令。

- 掌握正确配置路由器的方法,使网络正常工作。

本博客包括网络安全课程所有的实验报告:内容详细,一次下载打包

- 实验1-路由器配置

- 实验2-APP欺骗攻击与防御实验

- 实验3-源IP地址欺骗攻击防御

- 实验4-DHCP欺骗攻击与防御实验

- 实验5-密码实验

- 实验6-MD5编程实验

- 实验7-数字签名综合实验

- 实验8-RIP路由项欺骗攻击

- 实验9-流量管制实验

- 实验10-网络地址转换实验

- 实验11-防火墙实验

- 实验12-入侵检测实验

- 实验13-WEP配置实验

- 实验14-点对点IP隧道实验

配置完成网络IP地址和子网掩码后,路由器默认只知道直连的网段,即同一网段的主机之间可以相互通信,但分属于不同网段的主机之间还无法通信,因此需要进一步配置路由器实现整个网络的互连互通,方法是添加静态路由。

查看路由器的路由表:display ip routing-table

添加静态路由:ip route-static 下一网段 网关

【R1】ip route-static 192.168.1.0 24 20.1.1.1

【R1】ip route-static 192.168.2.0 24 20.1.2.1

【R2】ip route-static 192.168.2.0 24 20.1.1.2

【R2】ip route-static 20.1.2.0 24 20.1.1.2

【R3】ip route-static 192.168.1.0 24 20.1.2.2

【R3】ip route-static 20.1.1.0 24 20.1.2.2

验证PC1与PC3之间能够相互通信

在适当接口处进行数据抓包,调试网络运行状态右键点击

下面全部实验报告:包括实验PPT,实验报告word版,以及实验的工程文件,满分通过。

需要的在这里下载:网络安全实验-全部实验-打包带走最划算