网站如何合理建设seo建行24小时人工电话

1、Seata 概述

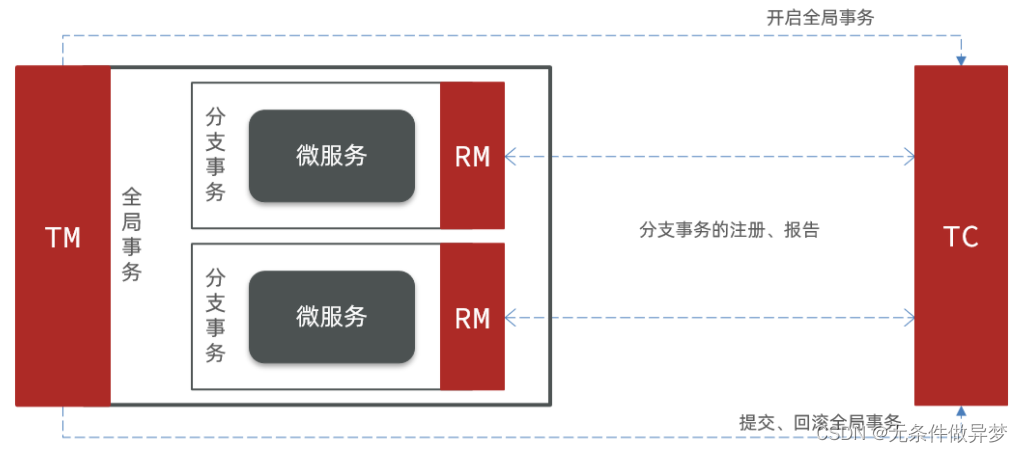

Seata事务管理中有三个重要的角色:

-

TC (Transaction Coordinator) - **事务协调者:**维护全局和分支事务的状态,协调全局事务提交或回滚。

-

TM (Transaction Manager) - **事务管理器:**定义全局事务的范围、开始全局事务、提交或回滚全局事务。

-

RM (Resource Manager) - **资源管理器:**管理分支事务处理的资源,与TC交谈以注册分支事务和报告分支事务的状态,并驱动分支事务提交或回滚。

整体的架构如图:

Seata基于上述架构提供了四种不同的分布式事务模式解决方案:

- XA模式:强一致性分阶段事务模式,牺牲了一定的可用性,无业务侵入

- TCC模式:最终一致的分阶段事务模式,有业务侵入

- AT模式:最终一致的分阶段事务模式,无业务侵入,也是Seata的默认模式

- SAGA模式:长事务模式,有业务侵入

无论哪种方案,都离不开TC,也就是事务的协调者。

1.1 微服务集成Seata

我们以order-service为例来演示。

1.1.1 引入依赖

首先,在order-service中引入依赖:

<!--seata-->

<dependency><groupId>com.alibaba.cloud</groupId><artifactId>spring-cloud-starter-alibaba-seata</artifactId><exclusions><!--版本较低,1.3.0,因此排除--> <exclusion><artifactId>seata-spring-boot-starter</artifactId><groupId>io.seata</groupId></exclusion></exclusions>

</dependency>

<dependency><groupId>io.seata</groupId><artifactId>seata-spring-boot-starter</artifactId><!--seata starter 采用1.4.2版本--><version>${seata.version}</version>

</dependency>

1.1.2 配置TC地址

在order-service中的application.yml中,配置TC服务信息,通过注册中心nacos,结合服务名称获取TC地址:

seata:registry: # TC服务注册中心的配置,微服务根据这些信息去注册中心获取tc服务地址type: nacos # 注册中心类型 nacosnacos:server-addr: 127.0.0.1:8848 # nacos地址namespace: "" # namespace,默认为空group: DEFAULT_GROUP # 分组,默认是DEFAULT_GROUPapplication: seata-tc-server # seata服务名称username: nacospassword: nacostx-service-group: seata-demo # 事务组名称service:vgroup-mapping: # 事务组与cluster的映射关系seata-demo: SH

微服务根据这些配置寻找TC的地址:

从注册到Nacos中的微服务,确定一个具体实例需要四个信息:

- namespace:命名空间

- group:分组

- application:服务名

- cluster:集群名

以上四个信息,在刚才的yaml文件中都能找到:

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-VZcWwWzX-1691830680782)(assets/image-20210724173654258.png)]](https://img-blog.csdnimg.cn/651d9f367a9e43bd95f6144decdefb06.png)

namespace为空,就是默认的public

结合起来,TC服务的信息就是:public@DEFAULT_GROUP@seata-tc-server@SH,这样就能确定TC服务集群了。然后就可以去Nacos拉取对应的实例信息了。

1.2 XA模式

XA 规范 是 X/Open 组织定义的分布式事务处理(DTP,Distributed Transaction Processing)标准,XA 规范 描述了全局的TM与局部的RM之间的接口,几乎所有主流的数据库都对 XA 规范 提供了支持。

1.2.1 两阶段提交

XA是规范,目前主流数据库都实现了这种规范,实现的原理都是基于两阶段提交。

正常情况:

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-pM4ZC7nX-1691830814657)(assets/image-20210724174102768.png)]](https://img-blog.csdnimg.cn/71f11c817c214f77beff54af916162d5.png)

异常情况:

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-f4omlMck-1691830814658)(assets/image-20210724174234987.png)]](https://img-blog.csdnimg.cn/5fbb88770330487ca39dd4f0f9e3b89d.png)

一阶段:

- 事务协调者通知每个事物参与者执行本地事务

- 本地事务执行完成后报告事务执行状态给事务协调者,此时事务不提交,继续持有数据库锁

二阶段:

- 事务协调者基于一阶段的报告来判断下一步操作

- 如果一阶段都成功,则通知所有事务参与者,提交事务

- 如果一阶段任意一个参与者失败,则通知所有事务参与者回滚事务

1.2.2 Seata的XA模型

Seata对原始的XA模式做了简单的封装和改造,以适应自己的事务模型,基本架构如图:

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ePI5vD5x-1691830814658)(assets/image-20210724174424070.png)]](https://img-blog.csdnimg.cn/9abbde7f54d141af82c8105328442071.png)

RM一阶段的工作:

① 注册分支事务到TC

② 执行分支业务sql但不提交

③ 报告执行状态到TC

TC二阶段的工作:

-

TC检测各分支事务执行状态

a.如果都成功,通知所有RM提交事务

b.如果有失败,通知所有RM回滚事务

RM二阶段的工作:

- 接收TC指令,提交或回滚事务