铜陵保障性住房和城乡建设网站什么网站可以做字体效果图

换脸技术已经不是新鲜事物,但如何实现简单、快速、高效的换脸操作呢?Roop插件正是为解决这一问题而生的。

sd-webui-roop 插件适用于已经本地部署了SD的用户。相较于传统的换脸技术,Roop插件几乎不需要训练,只需一张照片,即可在10秒内完成换脸。

但是要注意到是必须注意法律风险,并且该插件目前仅支持图片操作,并不支持视频操作,如果想要视频替换的小伙伴还是直接使用原有仓库代码即可。

文章目录

- sd-webui-roop 安装

- sd-webui-roop 使用

- sd-webui-roop API接口

- 其他常见错误和解决办法

sd-webui-roop 安装

整体安装比较麻烦,按照顺序来别跳步。

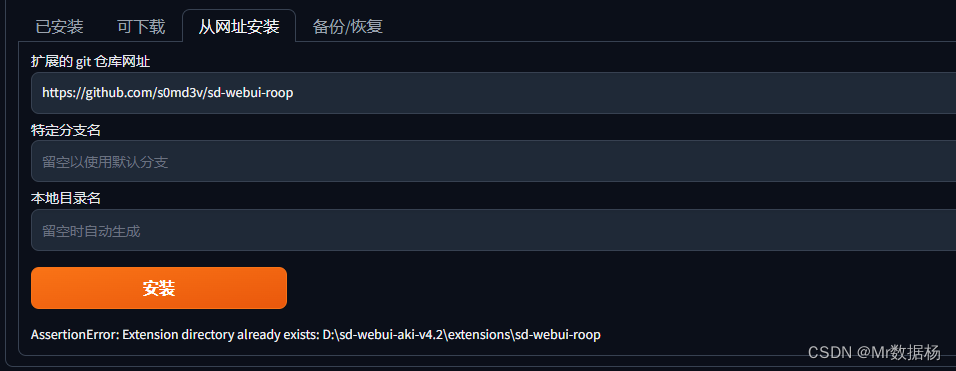

在SD扩展界面安装,复制命令https://github.com/s0md3v/sd-webui-roop,显示已经存在表示安装成功。

下载 inswapper_128