舟山工程建设信息网站做网站的项目职责怎么写

死锁

死锁是这样一种情形:多个线程同时被阻塞,它们中的一个或者全部都在等待某个资源被释放。由于线程被无限期地阻塞,因此程序不可能正常终止。

场景1:一个线程,一把锁

一个线程,一把锁,线程连续加锁两次。如果只给锁是不可重入锁,那就是死锁,synchronized的话是可重入锁,不影响。

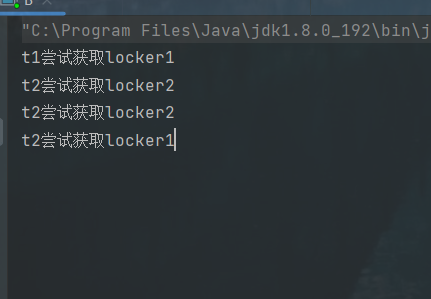

场景2:两个线程两把锁

两个线程两把锁:

public static void main(String[] args) throws InterruptedException {Object locker1 = new Object();Object locker2 = new Object();Thread t1 = new Thread(()->{System.out.println("t1尝试获取locker1");synchronized (locker1) {try {Thread.sleep(1000);} catch (InterruptedException e) {throw new RuntimeException(e);}System.out.println("t2尝试获取locker2");synchronized (locker2) {System.out.println("t1获取两把锁成功");}}});Thread t2 = new Thread(()->{System.out.println("t2尝试获取locker2");synchronized (locker2) {try {Thread.sleep(1000);} catch (InterruptedException e) {throw new RuntimeException(e);}System.out.println("t2尝试获取locker1");synchronized (locker1) {System.out.println("t2获取两把锁成功");}}});t1.start();t2.start();

}

面对这种场景,锁再怎么可重入也无济于事。

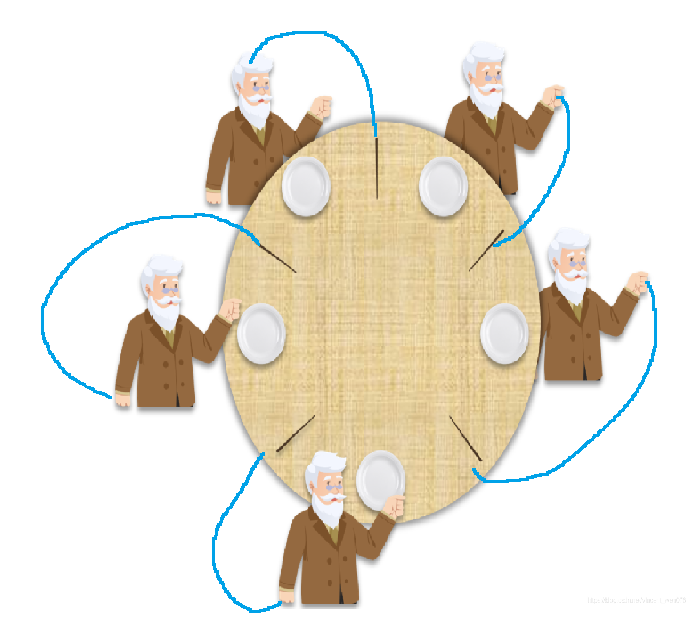

场景3:多个线程多把锁【哲学家就餐】

死锁典型模型:哲学家就餐问题

桌子,一碗意大利面

五个哲学家

五根筷子~ 分别放到两个人之间~

每个哲学家只会做两件事:

1.思考人生 啥都不千(线程阻塞了)

2.吃面条,先拿起左手的筷子,再拿起右手的筷子,吃一会,就放下了

多线程下:一般情况下这个模型是正常的,不会死锁,极端情况除外;

极端情况:五个哲学家同时拿起左手的筷子,且互不相让。

这个时候就会死锁了。

如何解决死锁?

死锁产生的四个必要条件:

1、互斥使用:锁A被线程1占用,线程2就用不了

2、不可抢占:锁A被线程1占用,线程2不能吧锁A给抢过来,除非线程1主动释放

3、请求和保持:即当资源请求者在请求其他的资源的同时保持对原有资源的占有。

4、循环等待:线程1等待线程2释放锁,线程2要释放锁得等待线程3来释放锁,线程3释放锁还得等待线程1释放锁。

当上述四个条件都成立的时候,便形成死锁。当然,死锁的情况下如果打破上述任何一个条件,便可让死锁消失。

其中最容易破坏的就是 “循环等待”.

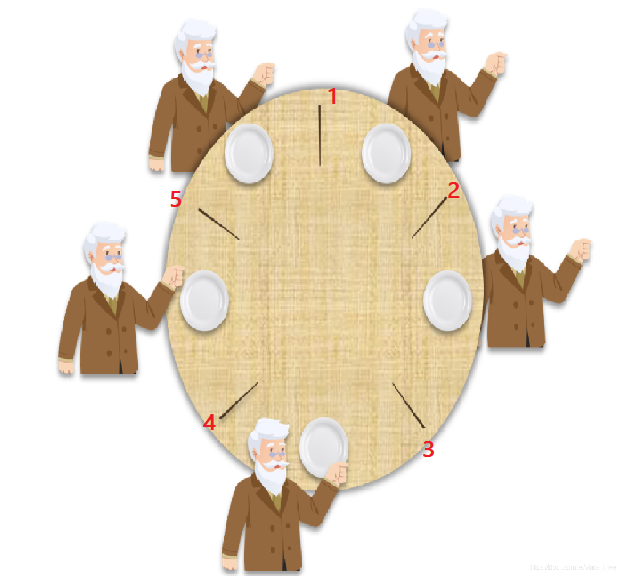

破坏循环等待

最常用的一种死锁阻止技术就是锁排序. 假设有 N 个线程尝试获取 M 把锁, 就可以针对 M 把锁进行编号

(1, 2, 3…M).

N 个线程尝试获取锁的时候, 都按照固定的按编号由小到大顺序来获取锁. 这样就可以避免环路等待.

约定:将筷子编号,要求必须先取身边编号小的后取编号大的,即使小的被别人拿了也要等待别人释放以后再拿。

按照这样的顺序,假设还是5个哲学家同时拿筷子:

1号哲学家先拿1号筷子,二号哲学家后拿身边的二号筷子,三号哲学家拿三号筷子,四号哲学家拿四号筷子。五号哲学家想拿一号筷子,但是发现一号筷子已经被一号哲学家拿走了,那么他就要等待一号筷子被一号哲学家释放,此时四号哲学家可以选择拿五号筷子加上之前选的四号筷子先用餐。然后用完以后,他将他将四号筷子放下,然后三号哲学家就可以拿三号筷子和四号筷子,以此类推。

【面试题】

谈谈死锁是什么,如何避免死锁,避免算法? 实际解决过没有?

死锁:

多个线程同时被阻塞,它们中的一个或者全部都在等待某个资源被释放。由于线程被无限期地阻塞,因此程序不可能正常终止。

推。

【面试题】

谈谈死锁是什么,如何避免死锁,避免算法? 实际解决过没有?

死锁:

多个线程同时被阻塞,它们中的一个或者全部都在等待某个资源被释放。由于线程被无限期地阻塞,因此程序不可能正常终止。

解决方法:避免循环等待,哲学家问题。