企业网站建设难吗个人网站示例

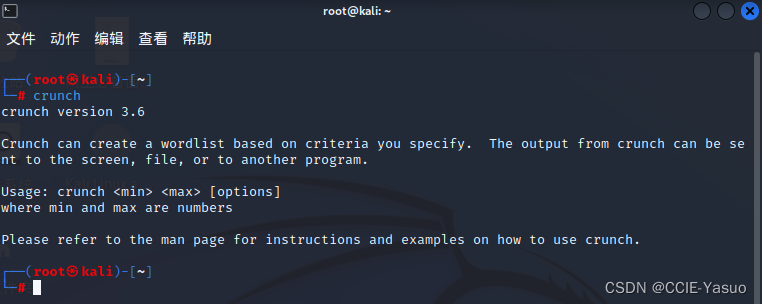

网络安全-字典生成-crunch

crunch工具,在kali已经集成好了

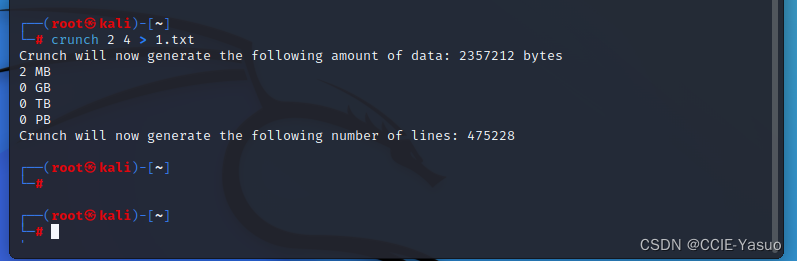

2是代表最小字符长度 4是最大字符长度

生成了一个2M的文件

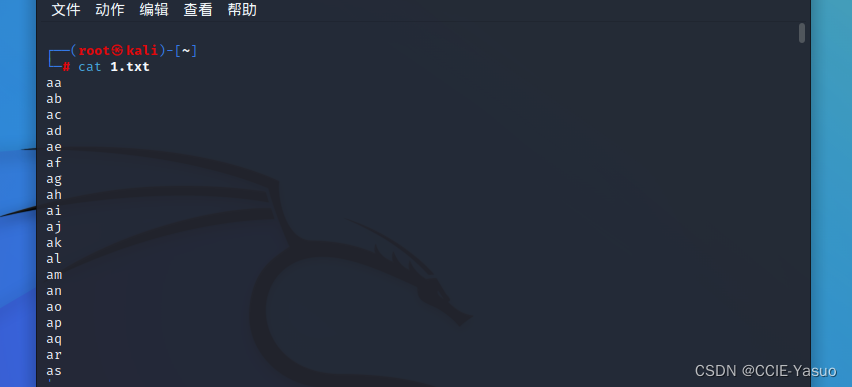

还有 我们来查看这个密码本

我们来查看这个密码本

从abcd26个英文字母的2位到4位的组合,他全部排列了一次

还可以自定义数字,特殊字符,大小写等。

那么这个就是自己做的密码本的

介绍一下特性

min 设定最小长度

max 设定最大长度

-o 生成字典保存指定路径

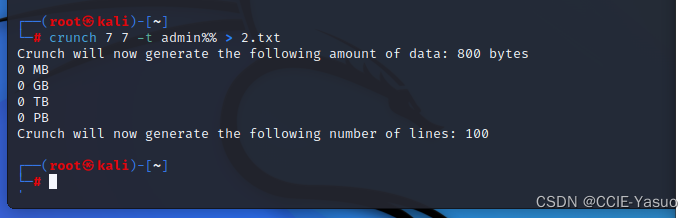

-t 输出密码的格式

-p 指定元素组合

% 代表数字

@代表小写字母

,代表大写字母

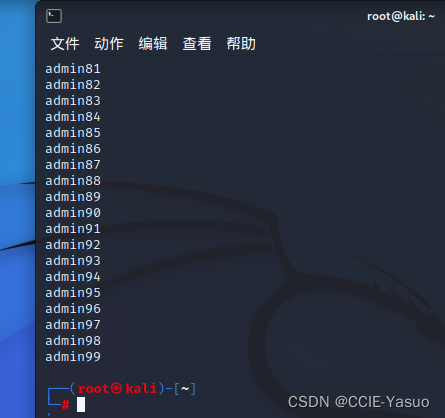

比如这个

crunch 7 7 -t admin%% >2.txt

使用这个软件 长度都为七位数的密码 -t为指定格式 admin开头,后面跟两个数字的密码格式

输出到2.txt这个文件里面

那么他就会生成admin1-admin99的字典

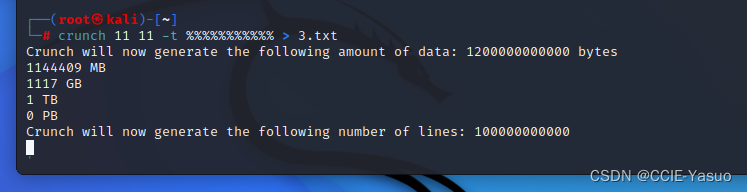

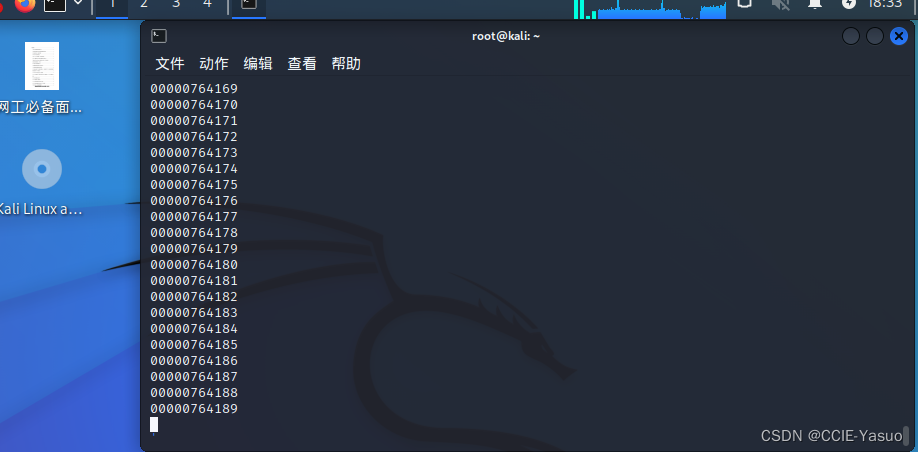

生成全世界的手机号

crunch 11 11 -t %%%%%%%%%%% >3.txt

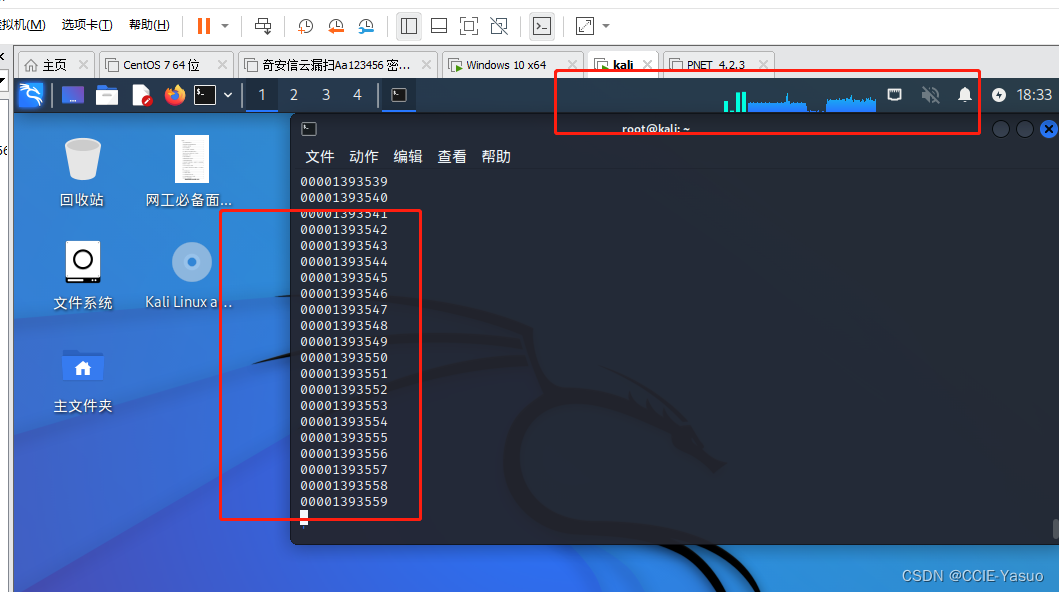

由于我这个是虚拟机,我没办法继续做了,他要1个多T呢,没那么多空间玩

他会把0-9,11位的长度的数字组合全部给你弄出来

可以看到上面的使用率嘎嘎往上涨

你也可以根据你的想法自己来生成词典

小提示,比如高校的SSL的账号密码,不都是学号嘛,那做个字典,再找个密码本,暴力破解不就容易了一点点了嘛,只要他不限制你错误登陆次数,一个一个尝试,爆破出来就是时间问题

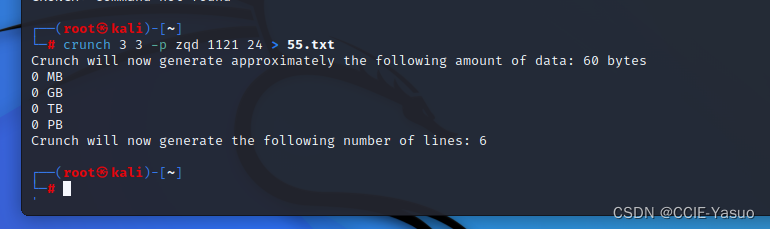

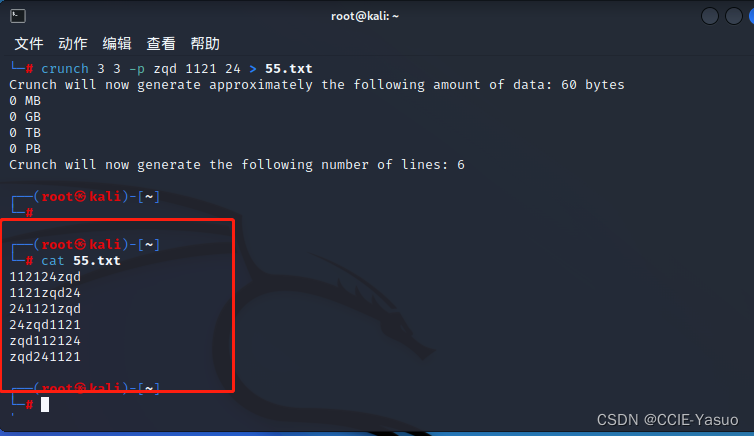

crunch 3 3 -p zqd 1121 24 > 55.txt 这个是什么意思呢

-p是是那个字符串随机组合起来,

这个zqd 1121 24 我是乱打的

意思是

每个模块取用3个,随机组成密码

然后输出到55.txt这个地方