高端网站建设哪家公司好国际情况最新消息

目录

前言:

一.龙蜥(Anolis)操作系统上安装GCC

1.安装gcc

2.检验安装

二.安装出现 make: *** 没有规则可以创建“default”需要的目标“build” 问题

1.解压安装nginx

2.安装出现问题展示

3.解决措施

4.重新编译进行安装

5.开放端口号80

6.启动nginx

前言:

在首次安装nginx的过程中,可能会遇到各种问题,其中最常见的问题之一就是“make: *** 没有规则可以创建‘default’需要的目标‘build’”。这个问题通常是由于缺少必要的依赖项或配置文件引起的。在这篇博客中,我们将探讨这个问题及其解决方案,帮助您顺利完成nginx的安装。

问题分析

该错误信息表明,在执行make命令时,无法找到生成“build”目标的规则。这通常意味着Makefile文件中的规则存在问题,或者缺少必要的依赖项。

一.龙蜥(Anolis)操作系统上安装GCC

1.安装gcc

sudo yum groupinstall 'Development Tools'这将安装包括GCC在内的开发工具包。

等待安装完成。安装过程可能需要一些时间,具体取决于你的系统配置和网络速度

2.检验安装

gcc --version

二.安装出现 make: *** 没有规则可以创建“default”需要的目标“build” 问题

1.解压安装nginx

解压

tar -zxvf nginx包名

安装nginx

# 进入安装包目录

cd nginx-1.13.7

# 编译,执行配置: 考虑到后续安装ssl证书 添加两个模块

./configure --with-http_stub_status_module --with-http_ssl_module2.安装出现问题展示

3.解决措施

通过执行以下代码进行重新安装nginx所需依赖,前言也提到出现此问题代码所需依赖不足导致出现此问题

yum -y install gcc openssl openssl-devel pcre-devel zlib zlib-devel

4.重新编译进行安装

./configure --with-http_stub_status_module --with-http_ssl_module编译,执行配置成功的标志

安装

安装

make && make install

5.开放端口号80

#开放端口

firewall-cmd --zone=public --add-port=80/tcp --permanent

#跟新防火墙规则

firewall-cmd --reload

#防火墙列表

firewall-cmd --zone=public --list-ports6.启动nginx

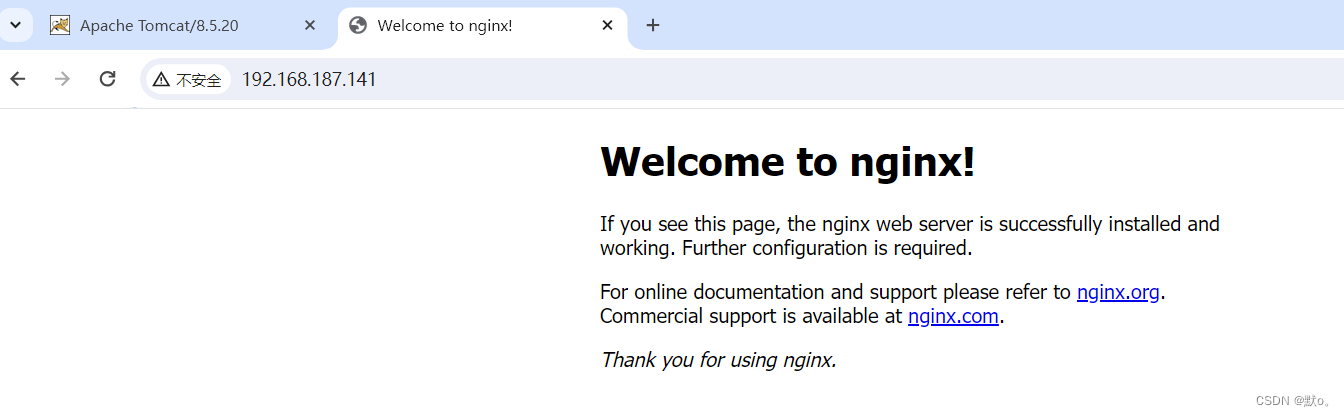

启动 nginx 服务

安装好的 nginx 服务在 /usr/local/nginx 下:

进入 /usr/local/nginx/sbin 目录下启动:

# 启动

./nginx# 重启

./nginx -s reload# 关闭

./nginx -s stop