购物网站开发问题epr系统

目录

启动hive

方式一

方式二

修改hdfs上给定文件执行的读写权限

创建数据库

查看数据库

查看数据库详细信息

查看当前数据库

创建表

查看建表语句

查看表信息

删除表

添加数据

查看表数据

删除数据库

强制删除数据库

启动hive

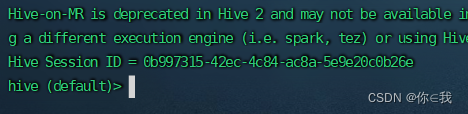

方式一

[root@hadoop1 ~]# hive

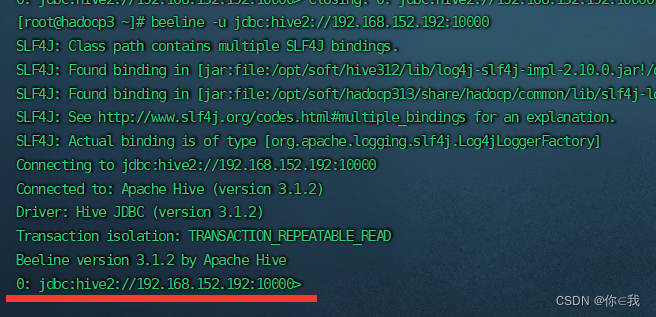

方式二

[root@hadoop1 ~]# hive --service hiveserver2

beeline -u jdbc:hive2://IP地址:10000

[root@hadoop1 ~]# beeline -u jdbc:hive2://192.168.152.192:10000

TIP:

hive --service hiveserver2这样的话就会占用两个窗口,那么就用下面的语句让反馈信息放到一个黑洞里面这样就不用占用一个窗口用来反馈信息

[root@hadoop3 stufile]nohup hiveserver2 1>/dev/null 2>&1 &

修改hdfs上给定文件执行的读写权限

[root@hadoop1 ~]# hdfs dfs -chmod -R 777 /tmp

[root@hadoop1 ~]# hadoop fs -chmod -R 777 /tmp

创建数据库

0: jdbc:hive2://192.168.152.192:10000> create if not exists database test;

查看数据库

0: jdbc:hive2://192.168.152.192:10000> show databases;

查看数据库详细信息

0: jdbc:hive2://192.168.152.192:10000> describe database test;

查看当前数据库

0: jdbc:hive2://192.168.152.192:10000> select current_database();

创建表

0: jdbc:hive2://192.168.152.192:10000> create table student(id int ,name string);

查看建表语句

0: jdbc:hive2://192.168.152.192:10000> show create table student;

查看表信息

0: jdbc:hive2://192.168.152.192:10000> describe student;

删除表

0: jdbc:hive2://192.168.152.192:10000> drop table if exists student;

添加数据

0: jdbc:hive2://192.168.152.192:10000> insert into student values(1,'zs'),(2,'ls');

查看表数据

0: jdbc:hive2://192.168.152.192:10000> select * from student;

删除数据库

0: jdbc:hive2://192.168.152.192:10000> drop database if exists test;

这样删除数据库,如果数据库里面有数据则不可以删除,那就用下面强制删除

强制删除数据库

0: jdbc:hive2://192.168.152.192:10000> drop database if exists test cascade;