做网站游戏推广赚钱吗个人怎么做一个网站

点击下载源码

当今社会人们生活质量越来越高,人们对生活品质的追求不断提升,对于孩子求学,变更住所等情况时有发生,因此对于户籍变动管理就显得十分重要,管理用户的户籍信息可以有效防止信息错乱,信息管理过程中出现问题可能会带来很多不必要的麻烦;因此,需要进行信息化对户籍信息进行管控。

本系统主要设计出发点就是围绕着户籍管理方面来进行设计,开发一套符合现代社会需求户籍管理的系统平台,给用户更多的便利和实惠;系统主要包括了登陆模块,注册模块,用户模块,户籍模块,迁入出模块,身份管理模块,缴费模块等等,系统设计采用的是WEB开发模式,结合简单的架构,运用java的开发语法,在强大的数据库支持下完成的,系统开发符合软件工程标准,数据准确,系统稳定。

技术可行性分析

技术可行性主要是对软件从技术层面上进行评估软件开发的可行性,本次系统开发主要是采用BS结构,目前比较实用的JAVA开发语言运用其中,而这个服务器是可以完美运行Tomcat,再加上强大数据库的支持,系统开发设备采用配置较高的台式机器,这种技术搭配基本可以满足所有的客户设计需求,完成客户的系统设计功能,在结合开发经验十足的开发团队,把系统按照相应的标准开发,就可以保证在整个开发过程当中可能出现的问题与困难能够顺利解决,所以,经过技术层面分析,项目开发在技术上可以通过。

背景的复杂性不断增加的产品和客户的需求,公司正在采用新的策略来满足不断变化的技术需求,较短的产品生命周期和制造业务的全球化。产品设计需要更复杂的程序和流程,需要设计师和工程师拥有不同的技能,知识和经验一起工作。为应对这些挑战,基于人工智能(AI)技术越来越多的被用于改善产品设计生命周期的有效性和效率。智能系统的许多方面进行了有益的应用还设计和设计相关的任务在不同的阶段,例如,确定客户的需求和要求,设计和规划、生产、交付、销售和客户服务等。个人智能模式(如模糊逻辑、神经网络、遗传算法、基于案例推理,特别是专家系统)已经应用到具体的设计过程(产品规划、概念设计、详细设计)。然而,越来越多的混合动力解决方案,整合多个个体智能技术需要解决复杂设计问题。集成智能环境可以提供各种类型的信息和知识支持快速和智能决策在整个设计过程。这是符合产品设计过程的进化趋势,从传统的CAD系统进入知识工程和综合智能设计系统通过结合并行工程,协同工程和集成智能技术。近年来,随着人工智能与信息科学和技术的进步,已经有了复苏的工作结合个人智能模式(知识系统、模糊逻辑、神经网络、遗传算法、基于案例推理、机器学习与知识发现、数据挖掘算法,智能代理,软计算,用户智能接口,等等)到集成智能系统来解决复杂的问题。杂交不同的智能系统是一个创新的方法来构建计算智能系统包括人工神经网络、模糊推理系统,近似推理和derivative-free优化方法如进化计算等等。不同的学习和适应技术的集成,克服个人的局限性,实现协同效应通过杂交或这些技术的融合,导致了大量的新的智能系统的设计。混合智能系统正在成为一个非常重要的解决问题的方法影响领域的研究者和实践者,从科学、技术、商业和贸易。综合智能系统在工程设计获得更好的接受。背后的驱动力是综合情报和分布式3 c(合作,合作,协调)允许人类知识的获取和应用程序,实现高质量的designs/产品。进一步的动力来自稳定的个人和混合智能系统技术的进步,和计算资源的广泛可用性,通过内部网和网络通信能力。需要一个编辑的文章,以反映新兴的集成智能技术及其在工程设计中的应用。AI的广度和扩展意义和综合智能系统(IIS)领域在国际舞台上需要一个主要参考工作充分的实质性的话题。其目的是,这项工作就会满足这种需要。这本书这本书的目的旨在描述最近的发现和新兴技术,使用智能系统(特别是集成和混合模式)在工程设计中,和示例应用程序。进步的目标是采取快照相关研究系统支持设计和传播的方式集成的最新进展,知识密集型的,人工智能和计算技术可以改善和增强这种支持。提供了一个集成的、整体的角度对这个复杂的挑战和提供严谨的研究结果。

功能需求

户籍管理系统主体将围绕户籍信息,身份证服务管理等方面进行展开设计,系统分为前台信息展示,后台的数据处理两大模块。必须选择非功能性需求与功能需求共同实施,提高软件项目的成功。三种方法存在执行优先级使用合适的优先级技术的非功能性需求。实验进行分析各个方法的准确性和精度的变化与软件项目的复杂性。结果表明,单独选择非功能性需求,但按照功能在另两种方法具有较高的精度。进一步,同样其他方法,目击者的准确性下降增加软件的复杂性,但减少最小。域分析是至关重要的核心资产软件产品线工程的发展。然而,大多数现有方法依赖于领域专家的经验来分析系统领域的共性和可变性,这仍然是一个手动和强化的过程。本文解决了问题提出了一个模型驱动的自动化领域需求推导过程。本文着重于用例之间的匹配现有的单个产品和产品线的域功能需求。通过引入一组语言描述维度区分sub-variations在一个用例,用例模板扩展模型的变化。为此,制定维持转换过程,推导出信息用例,并匹配域功能需求。本文还提出了一种原型实现图形化描述的推导过程作为一个模型转换模型转换语言翻车鲀。这种方法补充现有的域分析技术减少人工操作成本和更高的效率通过自动化领域功能需求的发展。

在信息和通信技术创新项目通常包括很多终端用户使用不同的用例,结果在不同的需求。这需要一种特殊的方法进行分析和分类的需求以及收敛于一个架构的解决方案,它解决了所有终端用户的需求。最终用户和开发人员之间的沟通应该相应的支持。这是在不同的研究和相关的软件开发项目,涉及大量的用户和开发者。本文描述了异构需求扩展的方法在分析传统方法与额外的迭代步骤旨在发现用例之间的共性。大的方法是验证PLANTCockpit欧盟资助的研究项目。其中主要的功能如下。

户籍管理员权限

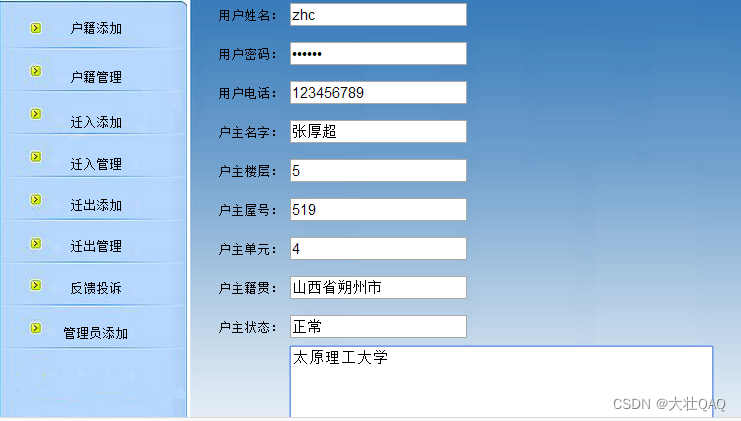

1.用户信息管理模块:主要是管理用户的基本注册信息,审核用户,删除用户等。

2.户籍管理模块:对人口的出生,死亡,迁入,迁出,变更等信息的录入,管理,修改,查询操作。

3.反馈管理模块:及时查看反馈信息,答复反馈信息。

4.权限管理模块:确定用户权限,合理分配权限功能。

5.身份服务模块:添加,管理身份证信息,及时发布,修改,方便用户查询,领取等。

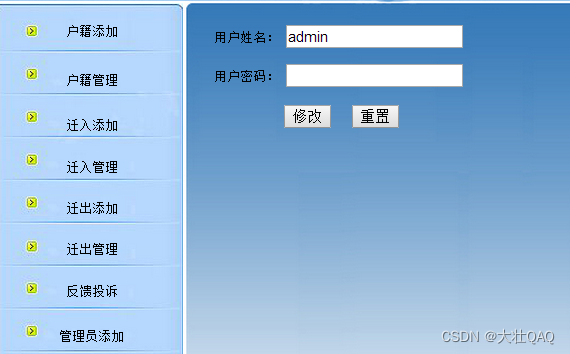

6.综合管理模块:密码修改,数据维护等操作。

7.暂住信息管理:主要登记临时居住的用户信息

用户权限

1.登陆注册模块:这个模块主要是用来进行系统登录,记录登录系统者的信息,可以进行一些相关功能操作;新用户需要注册为系统会员才能进行操作。

2.迁入信息模块,用户查询到自己的迁入信息,核对信息情况。

3.迁出信息模块,用户可以查询到自己的迁出信息,核对信息真实情况。

4.户籍状态查询:用户可以查询户籍状态情况。

5.反馈信息模块:用户可以将反馈信息发布出去,与管理员沟通。

6.身份服务模块:用户可以查看办证信息及领证信息等;

7.密码修改模块:主要是提供密码修改服务的。