沈阳网站备案wordpress回复旧版本

在整合mybatis和mybatis-plus的时候发现一个小坑,单独使用mybatis,配置别名如下:

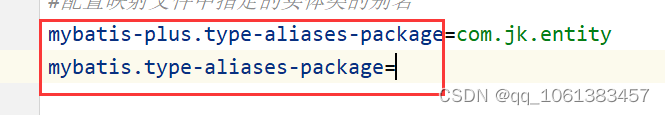

#配置映射文件中指定的实体类的别名

mybatis.type-aliases-package=com.jk.entityXML映射文件如下:

<update id="update" parameterType="student">update student<set><if test="name!=null and name!=''">name=#{name}</if><if test="gender!=null and gender!=''">gender=#{gender}</if><if test="classname!=null and classname!=''">classname=#{classname}</if></set>where id=#{id}</update>单元测试发现没有问题

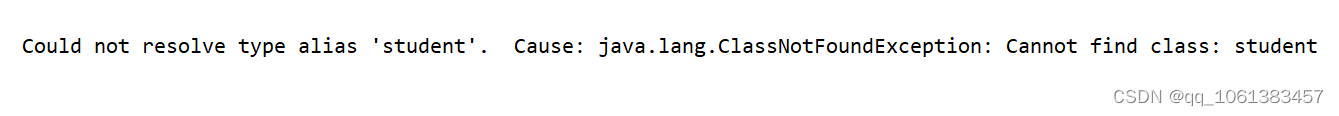

添加mybatis-plus依赖后,单元测试报错:

显示无法解析XML映射文件中的student

解决办法:要把配置文件里的别名配置改成mybatis-plus的配置,如下:

#配置映射文件中指定的实体类的别名

mybatis-plus.type-aliases-package=com.jk.entity区别