360搜索怎么做网站自然优化做网站用什么电脑好

数据挖掘,计算机网络、操作系统刷题笔记54

2022找工作是学历、能力和运气的超强结合体,遇到寒冬,大厂不招人,可能很多算法学生都得去找开发,测开

测开的话,你就得学数据库,sql,oracle,尤其sql要学,当然,像很多金融企业、安全机构啥的,他们必须要用oracle数据库

这oracle比sql安全,强大多了,所以你需要学习,最重要的,你要是考网络警察公务员,这玩意你不会就别去报名了,耽误时间!

考网警特招必然要考操作系统,计算机网络,由于备考时间不长,你可能需要速成,我就想办法自学速成了,课程太长没法玩

刷题系列文章

【1】Oracle数据库:刷题错题本,数据库的各种概念

【2】操作系统,计算机网络,数据库刷题笔记2

【3】数据库、计算机网络,操作系统刷题笔记3

【4】数据库、计算机网络,操作系统刷题笔记4

【5】数据库、计算机网络,操作系统刷题笔记5

【6】数据库、计算机网络,操作系统刷题笔记6

【7】数据库、计算机网络,操作系统刷题笔记7

【8】数据库、计算机网络,操作系统刷题笔记8

【9】操作系统,计算机网络,数据库刷题笔记9

【10】操作系统,计算机网络,数据库刷题笔记10

【11】操作系统,计算机网络,数据库刷题笔记11

【12】操作系统,计算机网络,数据库刷题笔记12

【13】操作系统,计算机网络,数据库刷题笔记13

【14】操作系统,计算机网络,数据库刷题笔记14

【15】计算机网络、操作系统刷题笔记15

【16】数据库,计算机网络、操作系统刷题笔记16

【17】数据库,计算机网络、操作系统刷题笔记17

【18】数据库,计算机网络、操作系统刷题笔记18

【19】数据库,计算机网络、操作系统刷题笔记19

【20】数据库,计算机网络、操作系统刷题笔记20

【21】数据库,计算机网络、操作系统刷题笔记21

【22】数据库,计算机网络、操作系统刷题笔记22

【23】数据库,计算机网络、操作系统刷题笔记23

【24】数据库,计算机网络、操作系统刷题笔记24

【25】数据库,计算机网络、操作系统刷题笔记25

【26】数据库,计算机网络、操作系统刷题笔记26

【27】数据库,计算机网络、操作系统刷题笔记27

【28】数据库,计算机网络、操作系统刷题笔记28

【29】数据库,计算机网络、操作系统刷题笔记29

【30】数据库,计算机网络、操作系统刷题笔记30

【31】数据库,计算机网络、操作系统刷题笔记31

【32】数据库,计算机网络、操作系统刷题笔记32

【33】数据库,计算机网络、操作系统刷题笔记33

【34】数据库,计算机网络、操作系统刷题笔记34

【35】数据挖掘,计算机网络、操作系统刷题笔记35

【36】数据挖掘,计算机网络、操作系统刷题笔记36

【37】数据挖掘,计算机网络、操作系统刷题笔记37

【38】数据挖掘,计算机网络、操作系统刷题笔记38

【39】数据挖掘,计算机网络、操作系统刷题笔记39

【40】数据挖掘,计算机网络、操作系统刷题笔记40

【41】数据挖掘,计算机网络、操作系统刷题笔记41

【42】数据挖掘,计算机网络、操作系统刷题笔记42

【43】数据挖掘,计算机网络、操作系统刷题笔记43

【44】数据挖掘,计算机网络、操作系统刷题笔记44

【45】数据挖掘,计算机网络、操作系统刷题笔记45

【46】数据挖掘,计算机网络、操作系统刷题笔记46

【47】数据挖掘,计算机网络、操作系统刷题笔记47

【48】数据挖掘,计算机网络、操作系统刷题笔记48

【49】数据挖掘,计算机网络、操作系统刷题笔记49

【50】数据挖掘,计算机网络、操作系统刷题笔记50

【51】数据挖掘,计算机网络、操作系统刷题笔记51

【52】数据挖掘,计算机网络、操作系统刷题笔记52

【53】数据挖掘,计算机网络、操作系统刷题笔记53

文章目录

- 数据挖掘,计算机网络、操作系统刷题笔记54

- @[TOC](文章目录)

- 数据挖掘分析应用:关联规则

- 半监督学习

- 本章小结

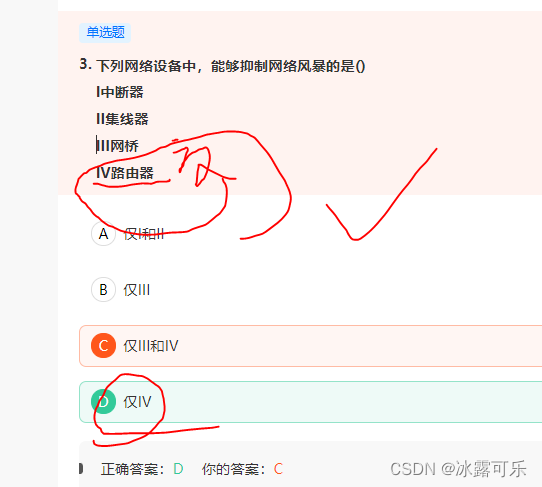

- 下列网络设备中,能够抑制网络风暴的是()

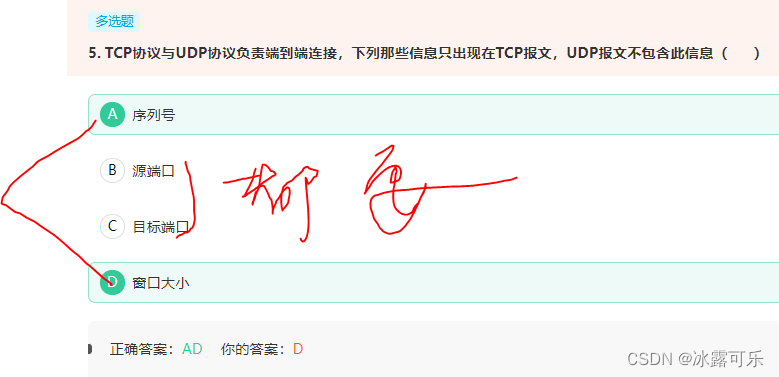

- TCP协议与UDP协议负责端到端连接,下列那些信息只出现在TCP报文,UDP报文不包含此信息( )

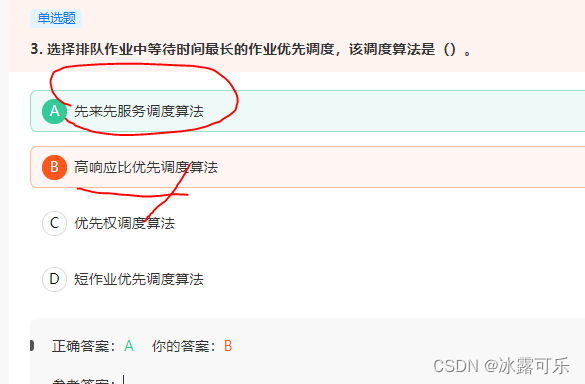

- 选择排队作业中等待时间最长的作业优先调度,该调度算法是()。

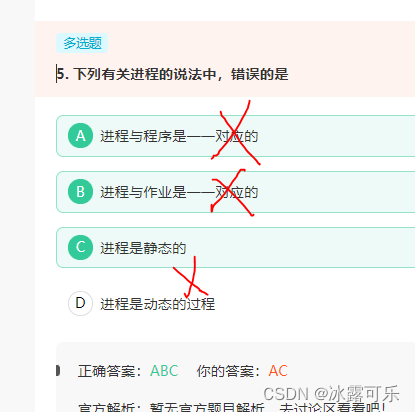

- 下列有关进程的说法中,错误的是

- 为了对文件系统中的文件进行安全管理,任何一个用户在进入系统时都必须进行注册,这一级管理是() 安全管理。

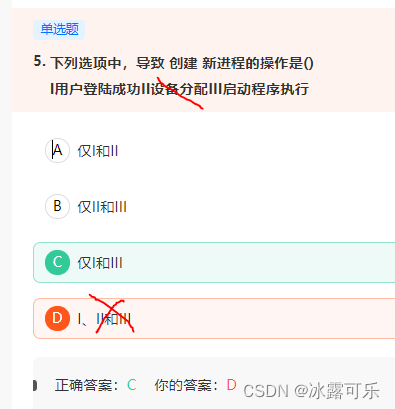

- 引起创建进程的事件:

- 总结

文章目录

- 数据挖掘,计算机网络、操作系统刷题笔记54

- @[TOC](文章目录)

- 数据挖掘分析应用:关联规则

- 半监督学习

- 本章小结

- 下列网络设备中,能够抑制网络风暴的是()

- TCP协议与UDP协议负责端到端连接,下列那些信息只出现在TCP报文,UDP报文不包含此信息( )

- 选择排队作业中等待时间最长的作业优先调度,该调度算法是()。

- 下列有关进程的说法中,错误的是

- 为了对文件系统中的文件进行安全管理,任何一个用户在进入系统时都必须进行注册,这一级管理是() 安全管理。

- 引起创建进程的事件:

- 总结

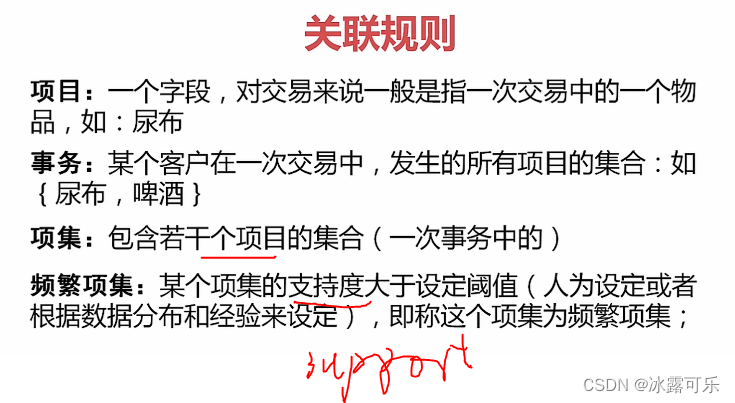

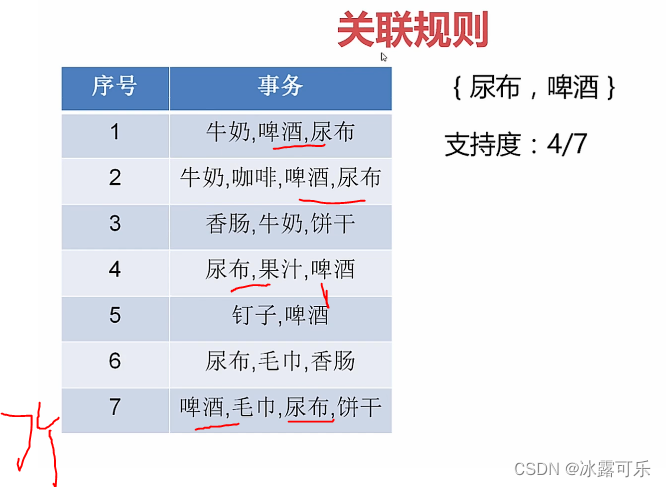

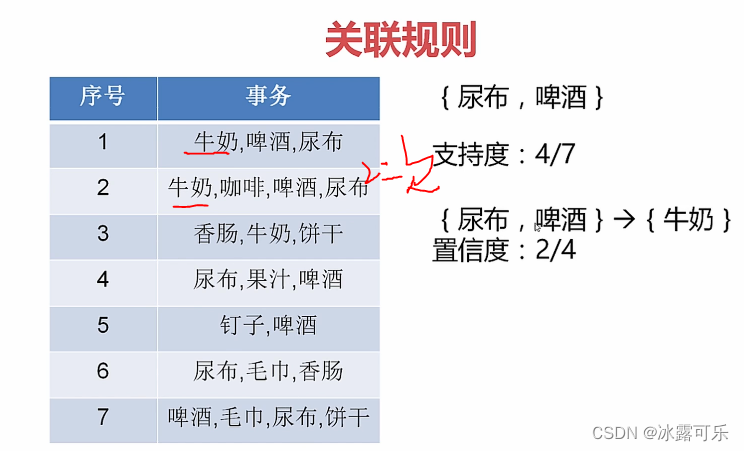

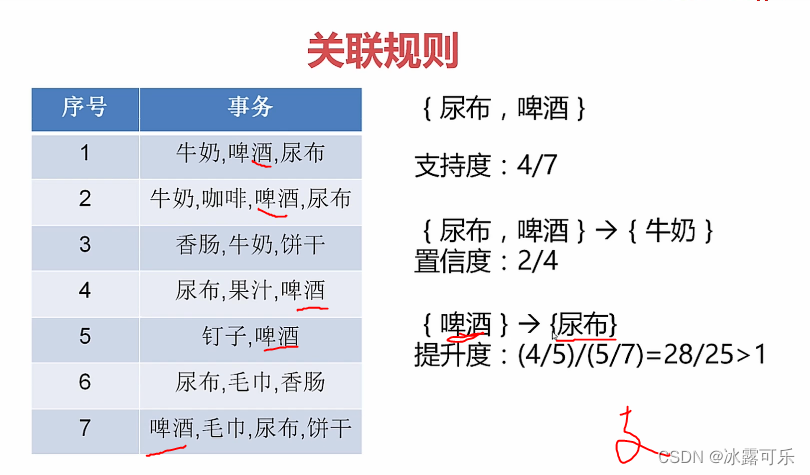

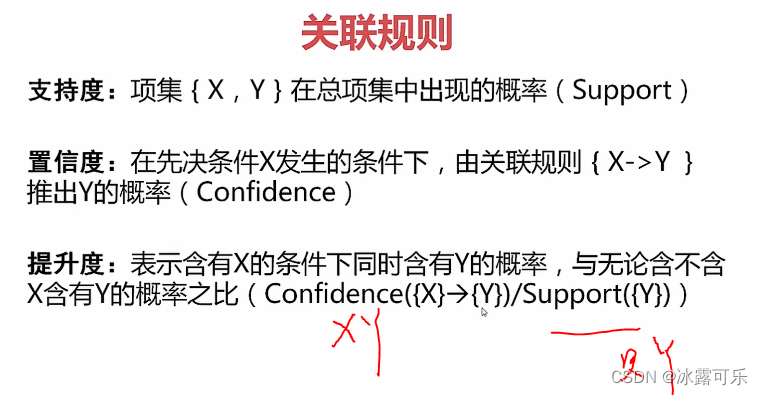

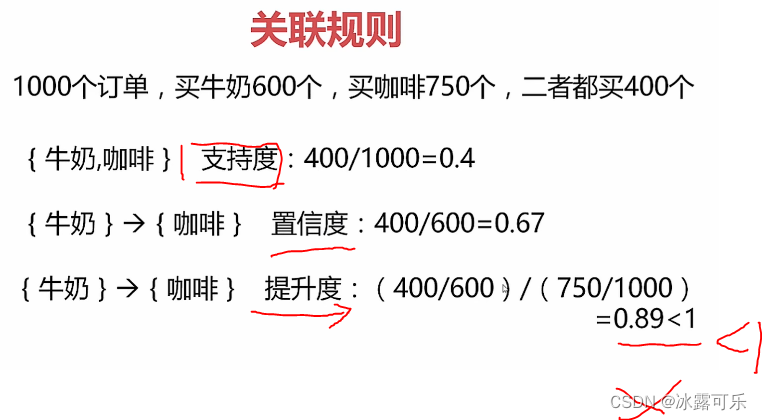

数据挖掘分析应用:关联规则

反应一个事物与其他事物之间的相互依存的关系

超市里面的技巧都这样

小瓶装放在门口

蔬菜肉类放在最深处

很多人的项集

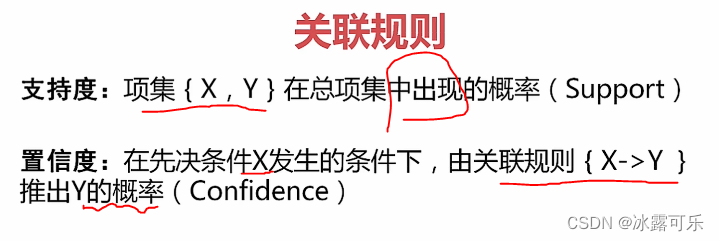

算支持度,超过阈值,他们的项集合起来就是频繁集

算概率

只看尿布

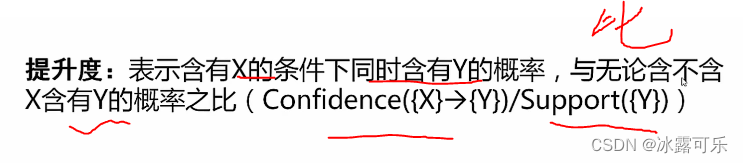

啤酒是对尿布有提升作用

这俩是相斥的

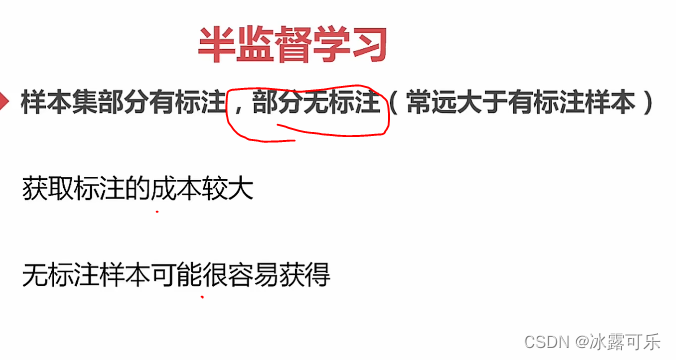

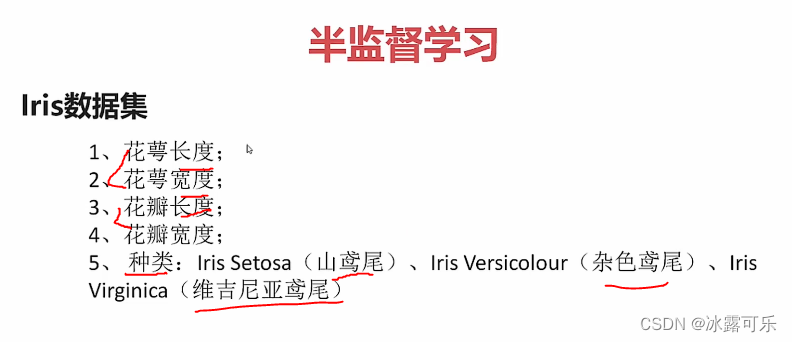

半监督学习

生成模型:联合分布

分批标注打标签

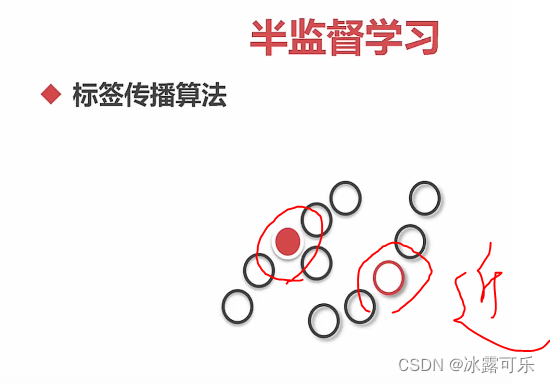

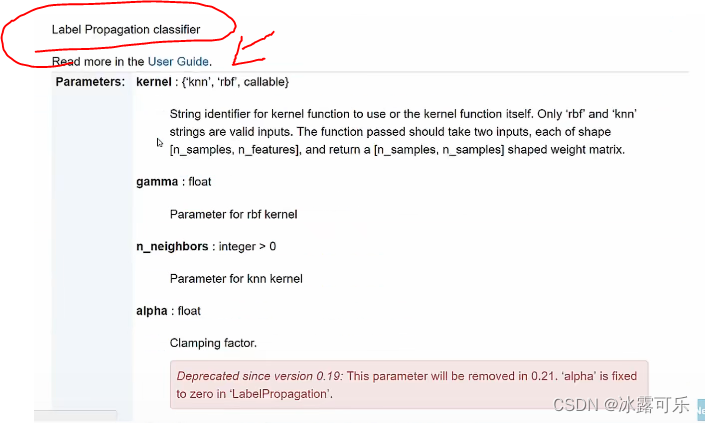

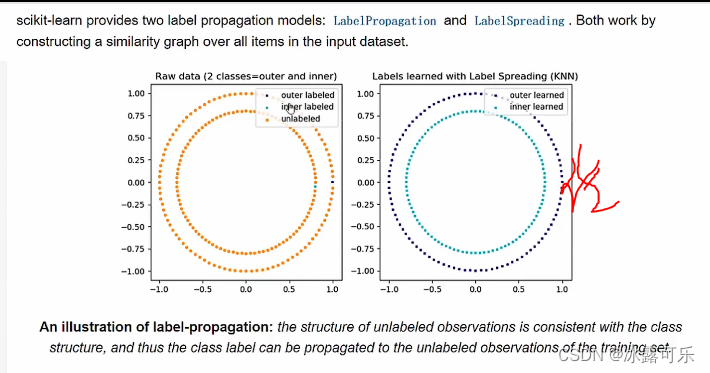

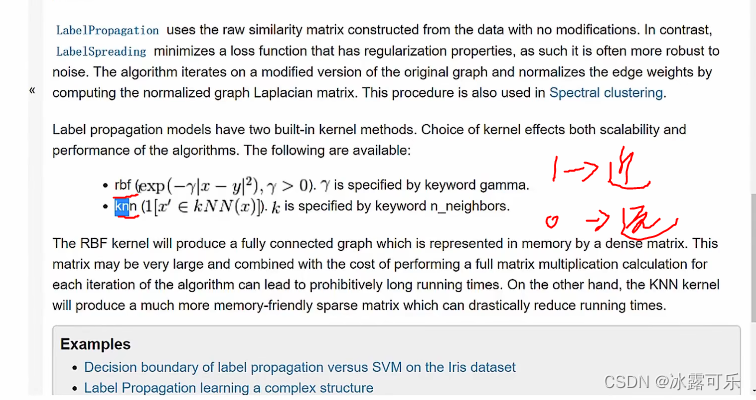

判别式模型:标签传播算法

去算rbf和中心点的距离

附近k个有标注的数据,标注多的,赋值

引入包

看代码

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasetsiris = datasets.load_iris()

print(iris)def f1():passif __name__ == '__main__':f1(){'data': array([[5.1, 3.5, 1.4, 0.2],[4.9, 3. , 1.4, 0.2],[4.7, 3.2, 1.3, 0.2],[4.6, 3.1, 1.5, 0.2],[5. , 3.6, 1.4, 0.2],[5.4, 3.9, 1.7, 0.4],[4.6, 3.4, 1.4, 0.3],[5. , 3.4, 1.5, 0.2],[4.4, 2.9, 1.4, 0.2],[4.9, 3.1, 1.5, 0.1],[5.4, 3.7, 1.5, 0.2],[4.8, 3.4, 1.6, 0.2],[4.8, 3. , 1.4, 0.1],[4.3, 3. , 1.1, 0.1],[5.8, 4. , 1.2, 0.2],[5.7, 4.4, 1.5, 0.4],[5.4, 3.9, 1.3, 0.4],[5.1, 3.5, 1.4, 0.3],[5.7, 3.8, 1.7, 0.3],[5.1, 3.8, 1.5, 0.3],[5.4, 3.4, 1.7, 0.2],[5.1, 3.7, 1.5, 0.4],[4.6, 3.6, 1. , 0.2],[5.1, 3.3, 1.7, 0.5],[4.8, 3.4, 1.9, 0.2],[5. , 3. , 1.6, 0.2],[5. , 3.4, 1.6, 0.4],[5.2, 3.5, 1.5, 0.2],[5.2, 3.4, 1.4, 0.2],[4.7, 3.2, 1.6, 0.2],[4.8, 3.1, 1.6, 0.2],[5.4, 3.4, 1.5, 0.4],[5.2, 4.1, 1.5, 0.1],[5.5, 4.2, 1.4, 0.2],[4.9, 3.1, 1.5, 0.2],[5. , 3.2, 1.2, 0.2],[5.5, 3.5, 1.3, 0.2],[4.9, 3.6, 1.4, 0.1],[4.4, 3. , 1.3, 0.2],[5.1, 3.4, 1.5, 0.2],[5. , 3.5, 1.3, 0.3],[4.5, 2.3, 1.3, 0.3],[4.4, 3.2, 1.3, 0.2],[5. , 3.5, 1.6, 0.6],[5.1, 3.8, 1.9, 0.4],[4.8, 3. , 1.4, 0.3],[5.1, 3.8, 1.6, 0.2],[4.6, 3.2, 1.4, 0.2],[5.3, 3.7, 1.5, 0.2],[5. , 3.3, 1.4, 0.2],[7. , 3.2, 4.7, 1.4],[6.4, 3.2, 4.5, 1.5],[6.9, 3.1, 4.9, 1.5],[5.5, 2.3, 4. , 1.3],[6.5, 2.8, 4.6, 1.5],[5.7, 2.8, 4.5, 1.3],[6.3, 3.3, 4.7, 1.6],[4.9, 2.4, 3.3, 1. ],[6.6, 2.9, 4.6, 1.3],[5.2, 2.7, 3.9, 1.4],[5. , 2. , 3.5, 1. ],[5.9, 3. , 4.2, 1.5],[6. , 2.2, 4. , 1. ],[6.1, 2.9, 4.7, 1.4],[5.6, 2.9, 3.6, 1.3],[6.7, 3.1, 4.4, 1.4],[5.6, 3. , 4.5, 1.5],[5.8, 2.7, 4.1, 1. ],[6.2, 2.2, 4.5, 1.5],[5.6, 2.5, 3.9, 1.1],[5.9, 3.2, 4.8, 1.8],[6.1, 2.8, 4. , 1.3],[6.3, 2.5, 4.9, 1.5],[6.1, 2.8, 4.7, 1.2],[6.4, 2.9, 4.3, 1.3],[6.6, 3. , 4.4, 1.4],[6.8, 2.8, 4.8, 1.4],[6.7, 3. , 5. , 1.7],[6. , 2.9, 4.5, 1.5],[5.7, 2.6, 3.5, 1. ],[5.5, 2.4, 3.8, 1.1],[5.5, 2.4, 3.7, 1. ],[5.8, 2.7, 3.9, 1.2],[6. , 2.7, 5.1, 1.6],[5.4, 3. , 4.5, 1.5],[6. , 3.4, 4.5, 1.6],[6.7, 3.1, 4.7, 1.5],[6.3, 2.3, 4.4, 1.3],[5.6, 3. , 4.1, 1.3],[5.5, 2.5, 4. , 1.3],[5.5, 2.6, 4.4, 1.2],[6.1, 3. , 4.6, 1.4],[5.8, 2.6, 4. , 1.2],[5. , 2.3, 3.3, 1. ],[5.6, 2.7, 4.2, 1.3],[5.7, 3. , 4.2, 1.2],[5.7, 2.9, 4.2, 1.3],[6.2, 2.9, 4.3, 1.3],[5.1, 2.5, 3. , 1.1],[5.7, 2.8, 4.1, 1.3],[6.3, 3.3, 6. , 2.5],[5.8, 2.7, 5.1, 1.9],[7.1, 3. , 5.9, 2.1],[6.3, 2.9, 5.6, 1.8],[6.5, 3. , 5.8, 2.2],[7.6, 3. , 6.6, 2.1],[4.9, 2.5, 4.5, 1.7],[7.3, 2.9, 6.3, 1.8],[6.7, 2.5, 5.8, 1.8],[7.2, 3.6, 6.1, 2.5],[6.5, 3.2, 5.1, 2. ],[6.4, 2.7, 5.3, 1.9],[6.8, 3. , 5.5, 2.1],[5.7, 2.5, 5. , 2. ],[5.8, 2.8, 5.1, 2.4],[6.4, 3.2, 5.3, 2.3],[6.5, 3. , 5.5, 1.8],[7.7, 3.8, 6.7, 2.2],[7.7, 2.6, 6.9, 2.3],[6. , 2.2, 5. , 1.5],[6.9, 3.2, 5.7, 2.3],[5.6, 2.8, 4.9, 2. ],[7.7, 2.8, 6.7, 2. ],[6.3, 2.7, 4.9, 1.8],[6.7, 3.3, 5.7, 2.1],[7.2, 3.2, 6. , 1.8],[6.2, 2.8, 4.8, 1.8],[6.1, 3. , 4.9, 1.8],[6.4, 2.8, 5.6, 2.1],[7.2, 3. , 5.8, 1.6],[7.4, 2.8, 6.1, 1.9],[7.9, 3.8, 6.4, 2. ],[6.4, 2.8, 5.6, 2.2],[6.3, 2.8, 5.1, 1.5],[6.1, 2.6, 5.6, 1.4],[7.7, 3. , 6.1, 2.3],[6.3, 3.4, 5.6, 2.4],[6.4, 3.1, 5.5, 1.8],[6. , 3. , 4.8, 1.8],[6.9, 3.1, 5.4, 2.1],[6.7, 3.1, 5.6, 2.4],[6.9, 3.1, 5.1, 2.3],[5.8, 2.7, 5.1, 1.9],[6.8, 3.2, 5.9, 2.3],[6.7, 3.3, 5.7, 2.5],[6.7, 3. , 5.2, 2.3],[6.3, 2.5, 5. , 1.9],[6.5, 3. , 5.2, 2. ],[6.2, 3.4, 5.4, 2.3],[5.9, 3. , 5.1, 1.8]]), 'target': array([0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,0, 0, 0, 0, 0, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1,1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1,1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2,2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2,2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2]), 'frame': None, 'target_names': array(['setosa', 'versicolor', 'virginica'], dtype='<U10'), 'DESCR': '.. _iris_dataset:\n\nIris plants dataset\n--------------------\n\n**Data Set Characteristics:**\n\n :Number of Instances: 150 (50 in each of three classes)\n :Number of Attributes: 4 numeric, predictive attributes and the class\n :Attribute Information:\n - sepal length in cm\n - sepal width in cm\n - petal length in cm\n - petal width in cm\n - class:\n - Iris-Setosa\n - Iris-Versicolour\n - Iris-Virginica\n \n :Summary Statistics:\n\n ============== ==== ==== ======= ===== ====================\n Min Max Mean SD Class Correlation\n ============== ==== ==== ======= ===== ====================\n sepal length: 4.3 7.9 5.84 0.83 0.7826\n sepal width: 2.0 4.4 3.05 0.43 -0.4194\n petal length: 1.0 6.9 3.76 1.76 0.9490 (high!)\n petal width: 0.1 2.5 1.20 0.76 0.9565 (high!)\n ============== ==== ==== ======= ===== ====================\n\n :Missing Attribute Values: None\n :Class Distribution: 33.3% for each of 3 classes.\n :Creator: R.A. Fisher\n :Donor: Michael Marshall (MARSHALL%PLU@io.arc.nasa.gov)\n :Date: July, 1988\n\nThe famous Iris database, first used by Sir R.A. Fisher. The dataset is taken\nfrom Fisher\'s paper. Note that it\'s the same as in R, but not as in the UCI\nMachine Learning Repository, which has two wrong data points.\n\nThis is perhaps the best known database to be found in the\npattern recognition literature. Fisher\'s paper is a classic in the field and\nis referenced frequently to this day. (See Duda & Hart, for example.) The\ndata set contains 3 classes of 50 instances each, where each class refers to a\ntype of iris plant. One class is linearly separable from the other 2; the\nlatter are NOT linearly separable from each other.\n\n.. topic:: References\n\n - Fisher, R.A. "The use of multiple measurements in taxonomic problems"\n Annual Eugenics, 7, Part II, 179-188 (1936); also in "Contributions to\n Mathematical Statistics" (John Wiley, NY, 1950).\n - Duda, R.O., & Hart, P.E. (1973) Pattern Classification and Scene Analysis.\n (Q327.D83) John Wiley & Sons. ISBN 0-471-22361-1. See page 218.\n - Dasarathy, B.V. (1980) "Nosing Around the Neighborhood: A New System\n Structure and Classification Rule for Recognition in Partially Exposed\n Environments". IEEE Transactions on Pattern Analysis and Machine\n Intelligence, Vol. PAMI-2, No. 1, 67-71.\n - Gates, G.W. (1972) "The Reduced Nearest Neighbor Rule". IEEE Transactions\n on Information Theory, May 1972, 431-433.\n - See also: 1988 MLC Proceedings, 54-64. Cheeseman et al"s AUTOCLASS II\n conceptual clustering system finds 3 classes in the data.\n - Many, many more ...', 'feature_names': ['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)'], 'filename': 'C:\\ProgramData\\Anaconda3\\envs\\AES\\lib\\site-packages\\sklearn\\datasets\\data\\iris.csv'}Process finished with exit code 0data有四个属性

target是标注类别,012三种

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasetsiris = datasets.load_iris()

# print(iris)

labels = np.copy(iris.target) # 复制一份标签def f1():print(len(labels)) # 150条unlabeled_points = np.random.rand(len(iris.target)) # 0-1的随机数unlabeled_points = unlabeled_points < 0.3 # 返回1和0的数labels[unlabeled_points] = -1 # 重置随机位置的标签,下标随机是1的那部分统统搞为-1print(iris.target)print(labels)if __name__ == '__main__':f1()150

[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 00 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 11 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 2 2 2 2 2 2 2 2 2 2 22 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 22 2]

[ 0 0 0 -1 -1 0 0 0 -1 -1 -1 -1 0 0 0 -1 -1 0 0 0 0 -1 0 -10 -1 0 0 0 0 0 -1 0 -1 0 -1 0 0 0 0 0 -1 0 0 0 -1 -1 00 -1 -1 -1 1 1 1 1 1 1 -1 -1 -1 -1 1 1 1 1 -1 -1 1 -1 1 -1-1 -1 1 1 1 1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 -1 -1 -1 -1 1 11 1 1 -1 2 2 2 2 2 2 2 2 2 -1 2 2 2 -1 2 2 -1 2 -1 22 2 2 2 2 -1 2 2 -1 2 2 -1 -1 2 2 2 2 2 2 2 2 2 -1 -1-1 2 2 2 2 -1]Process finished with exit code 0标签是-1的就是没有标签,懂?

这样就把半监督数据集搞出来了哦

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasetsiris = datasets.load_iris()

# print(iris)

labels = np.copy(iris.target) # 复制一份标签def f1():print(len(labels)) # 150条unlabeled_points = np.random.rand(len(iris.target)) # 0-1的随机数unlabeled_points = unlabeled_points < 0.3 # 返回1和0的数labels[unlabeled_points] = -1 # 重置随机位置的标签,下标随机是1的那部分统统搞为-1# print(iris.target)# print(labels)Y = labels[unlabeled_points] # 看看哪些是-1print(Y)print("无标注个数", list(labels).count(-1))if __name__ == '__main__':f1()150

[-1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1-1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1 -1]

无标注个数 38Process finished with exit code 0

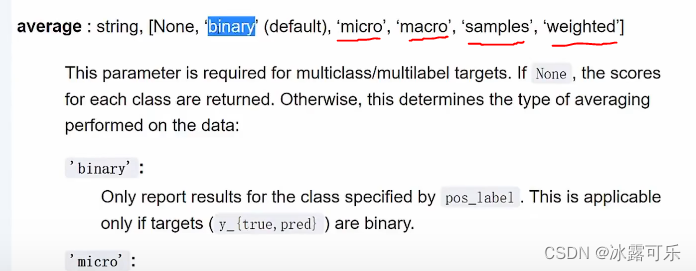

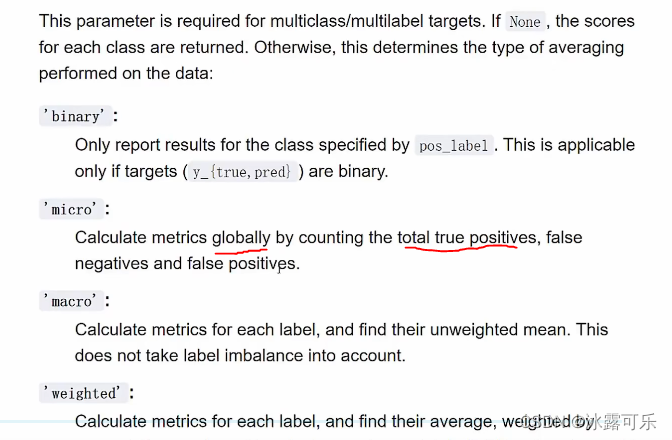

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasetsiris = datasets.load_iris()

# print(iris)

labels = np.copy(iris.target) # 复制一份标签def f1():print(len(labels)) # 150条unlabeled_points = np.random.rand(len(iris.target)) # 0-1的随机数unlabeled_points = unlabeled_points < 0.3 # 返回1和0的数Y = labels[unlabeled_points] # 看看哪些是-1print(Y)labels[unlabeled_points] = -1 # 重置随机位置的标签,下标随机是1的那部分统统搞为-1# print(iris.target)# print(labels)# print("无标注个数", list(labels).count(-1))# 然后建立半监督数据模型from sklearn.semi_supervised import LabelPropagationmodel = LabelPropagation()model.fit(iris.data, labels) # fity_pred = model.predict(iris.data)print(y_pred)y_pred = y_pred[unlabeled_points] # 看看哪些是-1print(y_pred)from sklearn.metrics import accuracy_score, recall_score, f1_scoreprint("acc:", accuracy_score(Y, y_pred))print("recall_score:", recall_score(Y, y_pred, average="micro"))print("f1_score:", f1_score(Y, y_pred, average="micro"))if __name__ == '__main__':f1()150

[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 2 2 2 2 2 2 22 2 2 2 2 2 2 2 2 2]

[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 00 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 11 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 2 2 2 2 2 2 2 2 2 2 22 2 2 2 2 2 2 2 1 2 2 2 2 2 2 2 2 2 2 2 2 2 1 2 2 2 2 2 2 2 2 2 2 2 2 2 22 2]

[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 2 2 2 2 2 2 12 1 2 2 2 2 2 2 2 2]

acc: 0.9574468085106383

recall_score: 0.9574468085106383

f1_score: 0.9574468085106385Process finished with exit code 0反正通过有监督的数据,将这些无标注的数据打上标签,搞定

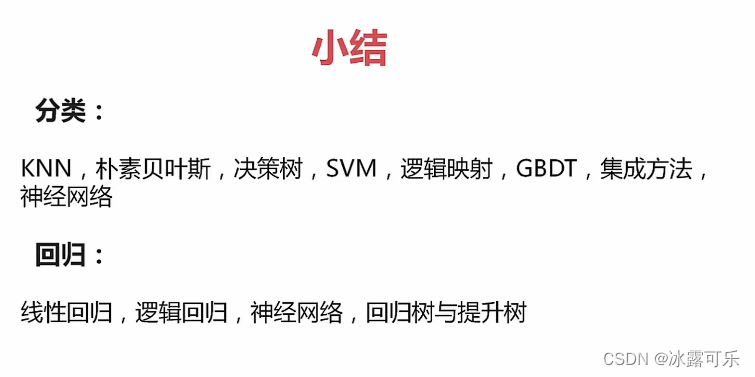

本章小结

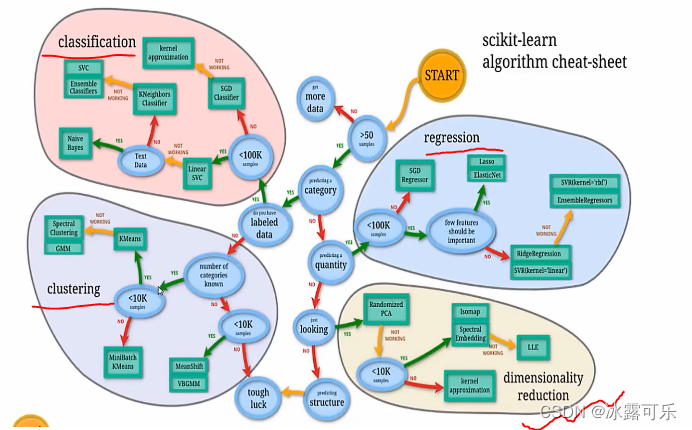

sklearn的机器学习分类

不见得人工神经网络能干一切事情

下列网络设备中,能够抑制网络风暴的是()

TCP协议与UDP协议负责端到端连接,下列那些信息只出现在TCP报文,UDP报文不包含此信息( )

选择排队作业中等待时间最长的作业优先调度,该调度算法是()。

下列有关进程的说法中,错误的是

为了对文件系统中的文件进行安全管理,任何一个用户在进入系统时都必须进行注册,这一级管理是() 安全管理。

引起创建进程的事件:

1、用户登录

2、作业调度

3、提供服务(用户程序提出请求)

4、应用请求(基于应用进程的需求)

总结

提示:重要经验:

1)

2)学好oracle,操作系统,计算机网络,即使经济寒冬,整个测开offer绝对不是问题!同时也是你考公网络警察的必经之路。

3)笔试求AC,可以不考虑空间复杂度,但是面试既要考虑时间复杂度最优,也要考虑空间复杂度最优。